XiaoMi-AI文件搜索系统

World File Search System第 8 章:主导策略 1 囚徒困境 2 ...

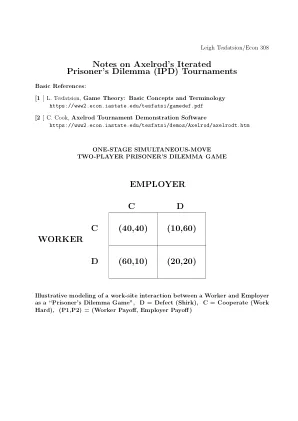

这个博弈就是著名的囚徒困境,其中 C i 解释为玩家 i 与另一个玩家合作,而 D i 则背叛另一个玩家。这个博弈对人类的悲惨结局提供了深刻的解释(以及可能躲避厄运的复杂指示)。但是现在我们仅用它来介绍严格支配策略的概念。玩家 i 的策略 si 被另一个策略 s ′ i 严格支配,并且无论另一个玩家选择哪种策略,该玩家的预期收益都严格大于 si。例如,在囚徒困境中,C 1 被 D 1 严格支配:如果玩家 2 选择 C 2 ,则 C 1 的收益为 1 而 D 1 的收益为 2 ;如果玩家 2 选择 D 2 ,则 C 1 的收益为 - 3 而 D 1 的收益为零。因此,玩家 1 将选择 D 1 。同样,C 2 严格受 D 2 支配,因此玩家 2 会选择 D 2 。因此,尽管如果他们选择 (C 1, C 2),可能会得到 (1, 1) 的“双赢”结果,但两位玩家最终选择 (D 1, D 2),从而得到 (0, 0)。因此,我们得到 (D 1, D 2) 作为博弈的主导策略均衡。

重复囚徒困境的策略

数学家卡尔·西格蒙德 (Karl Sigmund) 在其 2009 年出版的《自私的演算》[7] 一书中,从博弈论的角度解答了关于自私与合作的问题。因此,很多讨论自然都与 IPD 有关。在本节中,我们将尝试从复制器动态的角度研究 IPD 博弈,并观察一些策略如何随时间演变。我们可以考虑之前在 1 中提出的 IPD。现在,由于博弈是迭代的,我们需要一种随机的方式来模拟博弈的持续时间。因此,我们可以引入一个变量 ω ∈ (0 , 1)。然后在每一轮中,以概率 ω 再次进行博弈。这可以被认为是一个几何分布,我们等待成功(游戏结束),其概率为 1 − ω 。因此,预期游戏长度为 1 1 − ω 。

量子囚徒困境与高频交易......

高频交易 (HFT) 为商用第一代准量子计算机提供了一个绝佳的使用案例和潜在的杀手级应用。为此,我们在此提供一个简单的 HFT 博弈论模型,即著名的双人游戏“囚徒困境”。我们探索使用 Eisert、Wilkens 和 Lewenstein 量子中介通信协议在 (准) 量子云上将 HFT 实现为囚徒困境的一个实例,以及这种实现如何不仅可以提高交易速度,还可以改善 HFT 参与者的命运。使用合作博弈论推理,我们还注意到,在不久的将来,当互联网完全量子化时,玩家将能够在 HFT 中实现帕累托最优,作为强化机器学习的一个实例。

量子囚徒困境如何支持谈判

最优经济学研究 NR 5 (71) 2014 Marek SZOPA 1 量子囚徒困境如何支持谈判 2 摘要 囚徒困境游戏模拟谈判双方的决策。该游戏以量子方式制定,其中玩家策略是基于相反决策选项建立的量子位的幺正变换。量子策略通过量子纠缠机制相互关联,游戏结果通过所得变换状态的崩溃获得。量子玩家允许的策略范围比经典游戏更丰富,因此可以更好地优化游戏结果。另一方面,量子游戏可以防止窃听,玩家可以确信这种类型的量子仲裁是公平的。我们表明,量子囚徒困境比其经典类似物具有更有利的纳什均衡,并且它们接近帕累托最优解。并提出了一些利用量子博弈纳什均衡的经济实例。关键词:博弈论;量子博弈;囚徒困境;纳什均衡;帕累托最优解。1. 谈判如同博弈谈判方做出的许多决策依赖于他们之间的战略互动。这意味着谈判方可以在不同的策略之间进行选择,通常是冲突或合作。他们都同意相互合作是最可取的行为,但他们的选择是在不知道对方决定的情况下同时做出的。这产生了拒绝合作(背叛)的诱惑。这种互动通常用经典博弈论来描述。囚徒困境 [PD] 博弈是该类型中最著名的博弈之一。它最早由 Flood 和 Dresher [Flood, Dresher, 1952] 提出,并由 Albert Tucker 推广,他的两个囚犯的故事是该游戏当前名称的基础。PD 的流行源于其通用的游戏方案,它描述了日常生活中非常常见的谈判困境。一个典型的场景包含一个假设,即两个玩家 Alice 和 Bob 彼此独立地在合作 (C) 和背叛 (D) 之间做出选择。这两个玩家的选择是收益矩阵的基础,如表 1 所示。

关于阿克塞尔罗德的迭代囚徒困境 (IPD) 锦标赛的注释

• 生态锦标赛:第二届锦标赛的参赛者(加上随机)用作由 1000“代”组成的“进化”锦标赛的初始条件。第 G 代开始时种群池中 T 类策略的数量设置为等于上一代 G-1 中 T 类策略赢得的总分数。

经济战

我们应该期望各国在参与经济战争时采取什么行动?本文首先表明,赢得战争的目标意味着一个非常简单直观的经济战争目标:最大化自己的收益减去对手的收益(权重调整后)。然后将此目标函数应用于许多典型的战略经济环境,以展示战争如何改变它们。在买方和卖方之间的战争均衡中,交易量低于和平时期,但令人惊讶的是,价格可能会更低。分析表明,在战争中,贸易何时会完全崩溃,以及在战争中,双方之间的贸易何时会持续存在。囚徒困境博弈(例如,垄断竞争或气候变化缓解)在战争中仍然是囚徒困境博弈,在无限重复的情况下,合作也可能无法实现。战争中,具有不同偏好(例如选择技术标准)的协调博弈要么会演变为故意的不协调,要么会演变为“一分钱一分货”,即一个国家试图模仿另一个国家,而另一个国家则试图避免这种情况。从俄罗斯和西方之间当前的经济战争的角度来看,其结果是可以解释的。

学习和游戏 AI - DROPS - Schloss Dagstuhl

将学习融入商业游戏可以丰富玩家体验,但可能会让开发者担心诸如失去对游戏世界的控制等问题。我们探讨了一些应用研究和一些实地应用,这些应用表明机器学习研究具有巨大的可能性,包括实时战略游戏、飞行模拟游戏、汽车和摩托车赛车游戏、围棋等棋盘游戏,甚至囚徒困境等传统博弈论问题。这些研究的共同特点是机器学习有可能减轻游戏开发者的负担。然而,存在一些挑战阻碍了机器学习的更广泛应用。我们讨论了其中的一些挑战,同时探索了在游戏中广泛使用机器学习的机会。

2024 年步兵基础军官领导课程 (IBOLC) 阅读清单

书籍。i. Kerr, James. (2013)。遗产:全黑队能教给我们什么关于人生的道理。康斯特布尔和罗宾逊。j. Marshall, Tim. (2016)。地理的囚徒:十张地图告诉你关于全球政治的一切。埃利奥特和汤普森。k. McCormack, Joseph (2014)。简报:少说多做,影响更大。威利。l. Rommel, E. (2009)。步兵攻击。Zenith Press。m. Moore, HG 和 Galloway, JL (1992)。我们曾经是战士……而且年轻:Ia Drang –

平均收益 IPD 的良好无敌策略

重复囚徒困境 (IPD) 是研究理性主体长期行为的著名基准。许多著名策略都得到了研究,从简单的针锋相对 (TFT) 到更复杂的策略,如 Press 和 Dyson 最近研究的零决定因素和敲诈策略。在本文中,我们考虑所谓的无敌策略。这些策略在极限情况下的平均收益永远不会输给任何其他策略。我们对这类策略进行了简单的描述,并表明无敌策略也可以是好策略。我们讨论了它与一些重要策略的关系,并将我们的结果推广到一些典型的重复 2x2 博弈。众所周知,从实验上讲,像 TFT 这样的好策略和敲诈策略可以作为合作进化的催化剂。我们的实验表明,一些既不好也不敲诈的无敌策略也是如此。