XiaoMi-AI文件搜索系统

World File Search System利用基于语言的表示,以更好地解决与大语模型的符号相关问题

符号(例如数值序列,化学公式和表格定界符)广泛存在,在与符号相关的任务中扮演重要角色,例如抽象推理,化学培养物预测和表格提问。与基于自然语言表达式的任务相比,大型语言模型(LLMS)在理解和理性的基于符号的表示方面存在局限性,因此他们很难处理与符号相关的问题。在本文中,我们提出了符号到语言(S2L),该方法将基于符号的表示形式转换为基于语言的代表,为推理过程中语言模型提供了宝贵的信息。我们发现,对于封闭源和开放源LLM,可以通过合并基于语言的代表来在很大程度上增强解决符号问题的能力。例如,通过为GPT-4使用S2L,可以进行+21的实质性改进。9%和+9。分别用于1D ARC和DYCK语言任务的准确性5%。 在其他六个一般符号相关的任务(例如表理解和推文分析)中也有一致的改进。 我们在https://github.com/thunlp-mt/symble2language 1中重新租用GPT日志。分别用于1D ARC和DYCK语言任务的准确性5%。在其他六个一般符号相关的任务(例如表理解和推文分析)中也有一致的改进。我们在https://github.com/thunlp-mt/symble2language 1中重新租用GPT日志。

重新越狱大语言模型

最近,越狱袭击的激增在大型语言模型(LLMS)中遭受了严重的脆弱性,当时暴露于恶意投入时。虽然已经提出了各种防御策略来减轻这些威胁,但对使LLM易受此类攻击的基本机制的研究有限。在这项研究中,我们建议LLMS的自助力能力与其代表空间内的特定活动模式有关。尽管这些模式对本文文本的语义内容没有影响,但它们在越狱攻击下塑造LLM行为方面起着至关重要的作用。我们的发现表明,只需几对对比度查询即可检测到这些模式。广泛的实验表明,可以通过削弱或增强这些模式来操纵LLMS对越狱的鲁棒性。进一步的视觉分析为我们的结论提供了其他证据,为越狱现象提供了新的见解。这些发现突出了解决社区内开源LLM的潜在滥用的重要性。

探索在财务文本中回答的多语言和生成大语言模型的有效性

本文研究了Fincausal 2025共享任务中使用大型语言模型(LLMS)进行财务因果关系检测,这是对生成和多语言问题答案(QA)任务的努力。我们的研究采用了生成性和歧视方法,利用GPT-4O用于生成质量质量质量和基本基础式的,XLM-ROBERTA-LARGE和XLM-ROBERTA-BASE,用于跨英语和西班牙数据集的多语言质量检查。数据集由财务披露组成,问题反映了因果关系,并与直接从文本得出的提取答案配对。使用序列答案相似性(SAS)和精确匹配(EM)指标进行评估。虽然XLM-Roberta-large模型取得了最佳总体表现,但在English中排名第五(SAS:0.9598,EM:0.7615),西班牙语中排名第四(SAS:0.9756,EM:0.8084),在11个团队中,我们的结果也很高,在11个团队中,也可以强大的结果。值得注意的是,GPT-4O在几乎没有的设置中取得了令人鼓舞的结果,SAS得分接近了微调判别模型的分数,表明尽管缺乏特定于任务特定的微调,但生成性的AP可以提供竞争性能。此比较强调了一般LLM作为强大的多功能替代方案的潜力,用于复杂的质量质量质量质量因果关系检测。

llava-re:具有多模式大语模型

多模式生成型AI通常涉及在另一种模态中给定输入给定的图像或文本响应。图像文本相关性的评估对于衡量响应质量或对候选响应的排名至关重要。在二元相关性评估中,即,“相关”与“不相关”是一个基本问题。但是,考虑到文本具有多种格式,相关性的定义在不同的情况下有所不同,这是一项具有挑战性的任务。我们发现,多模式的大型语言模型(MLLM)是构建此类评估者的理想选择,因为它们可以灵活地处理复杂的文本格式并掌握适当的任务信息。在本文中,我们介绍了Llava-re,这是与MLLM进行二进制图像文本相关性评估的首次尝试。它遵循LLAVA体系结构,并采用详细的任务指令和多模式IN上下文样本。此外,我们提出了一个新型的二进制相关数据集,该数据集涵盖了各种任务。实验结果验证了我们框架的有效性。

关于关系数据库和大语言模型的混合查询

数据库传统上查询在封闭世界中运行,对超出数据库中存储的数据之外的问题的问题没有提供任何答案。使用SQL的混合查询通过将关系数据库与大型语言模型(LLMS)集成在一起以回答超越数据库问题,从而提供了替代方案。在本文中,我们介绍了第一个跨域基准,天鹅,其中包含120个超越数据库问题的问题。为了利用最新的语言模型来解决天鹅中的这些复杂问题,我们提出了两个解决方案:一个基于模式扩展,另一个基于用户定义的功能。我们还讨论优化机会和潜在的未来方向。我们的评估表明,使用GPT-4 Turbo几乎没有提示,可以实现高达40.0%的执行准确性,而数据事实可达到48.2%。这些结果突出了混合查询的潜力和挑战。我们认为,我们的工作将激发进一步的研究,以创建更有效,更准确的数据系统,这些数据系统无缝整合关系数据库和大型语言模型,以解决超越数据库问题。

从文本到多模式:探索大语模型在医学实践中的演变和影响

索引术语 - 规范语言模型,医学实践,多种模式,人工智能摘要 - LARGE语言模型(LLMS)已从基于文本的系统到多模式平台迅速发展,并影响了包括医疗保健在内的各个部门。这项全面的审查探讨了LLM到多模式大语模型(MLLM)的发展及其在医学实践中的影响。我们检查了医疗保健中MLLM的当前格局,在临床决策支持,医学成像,患者参与和研究中分析其应用。评论强调了MLLM在整合各种数据类型(例如文本,图像和音频)中的独特功能,以提供对患者健康的更全面的见解。我们还解决了MLLM实施面临的挑战,包括数据限制,技术障碍和道德考虑。通过确定关键的研究差距,本文旨在指导数据集开发,模态对准方法和建立道德准则等领域的未来调查。随着MLLM继续塑造医疗保健的未来,了解它们的潜力和局限性对于他们负责和有效地融入医学实践至关重要。索引术语 - 多种语言模型(MLLM),医学成像,临床决策支持,患者参与,数据整合

使用大语言模型的静态代码气味分析

即使是功能良好的代码也经常包含隐藏的代码气味 - 可能阻碍软件质量的可能问题的指标。未发现的代码气味导致维护问题,从而增加了技术债务。这项研究探讨了最先进的大语模型(LLM)在发现不同代码气味时的潜在用途。我们的发现表明,美洲驼3显示了竞争性能,尤其是在检测结构代码的气味时;但是,进一步的统计分析表明,LLM和其他静态分析仪之间的总体性能没有显着差异,即PMD,CheckStyle和Sonarqube。这些结果表明,Llama 3尚未准备好完全替换静态分析工具,但可以用作宝贵的补充工具,从而避免了大量程序员的时间。

大语言模型:经济学家的入门

大语言模型(LLM)是分析文本数据的强大工具,在经济和中央银行应用中具有巨大的潜力。大量文本档案,包括政策声明,财务报告和新闻,为分析提供了丰富的机会。此特殊功能为针对经济学家的LLM提供了可访问的介绍,并为应用研究人员提供了对其使用的实际演练。我们提供了涵盖数据组织,信号提取,定量分析和输出评估的LLMS使用的分步指南。作为例证,我们将框架应用于2021年至2023年之间的60,000篇新闻文章。尽管宏观经济和货币政策新闻很重要,但市场情绪也产生了重大影响。

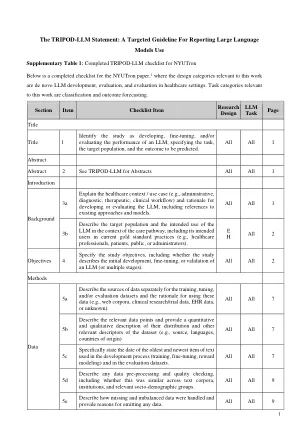

报告大语的目标指南...

llm =大语言模型; M = LLM方法; d = de novo llm开发; E = LLM评估; H =医疗保健设置中的LLM评估; C =分类; =结果预测; QA =长形式提问; ir =信息检索; DG =文档生成; SS =摘要和简化; MT =机器翻译; EHR =电子健康记录。

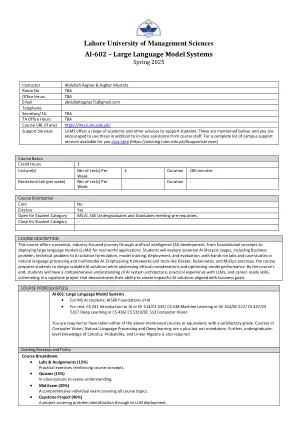

AI-602 - 大语言模型系统

课程描述本课程为人工智能(AI)开发提供了实用的,以行业为中心的旅程,从基础概念到为现实世界应用部署大型语言模型(LLM)。学生将通过自然语言处理和多模式AI进行动手实验室和案例研究,探索必不可少的AI生命周期阶段,包括业务问题,AI解决方案配方,模型培训,部署和评估。强调框架和工具,例如Docker,Kubernetes和MLOPS实践,该课程使学生准备设计可扩展的AI解决方案,同时解决道德考虑并优化模型性能。在课程结束时,学生将对AI系统体系结构,LLM的实践经验和职业准备技能有全面的了解,最终在一个顶峰项目中表明了他们创建与业务目标一致的影响力AI解决方案的能力。