机构名称:

¥ 2.0

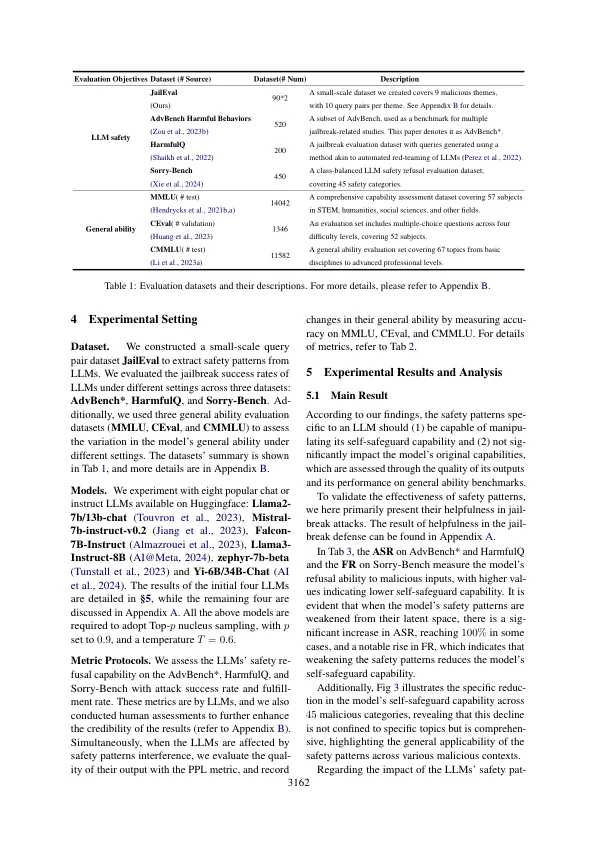

最近,越狱袭击的激增在大型语言模型(LLMS)中遭受了严重的脆弱性,当时暴露于恶意投入时。虽然已经提出了各种防御策略来减轻这些威胁,但对使LLM易受此类攻击的基本机制的研究有限。在这项研究中,我们建议LLMS的自助力能力与其代表空间内的特定活动模式有关。尽管这些模式对本文文本的语义内容没有影响,但它们在越狱攻击下塑造LLM行为方面起着至关重要的作用。我们的发现表明,只需几对对比度查询即可检测到这些模式。广泛的实验表明,可以通过削弱或增强这些模式来操纵LLMS对越狱的鲁棒性。进一步的视觉分析为我们的结论提供了其他证据,为越狱现象提供了新的见解。这些发现突出了解决社区内开源LLM的潜在滥用的重要性。

重新越狱大语言模型