机构名称:

¥ 1.0

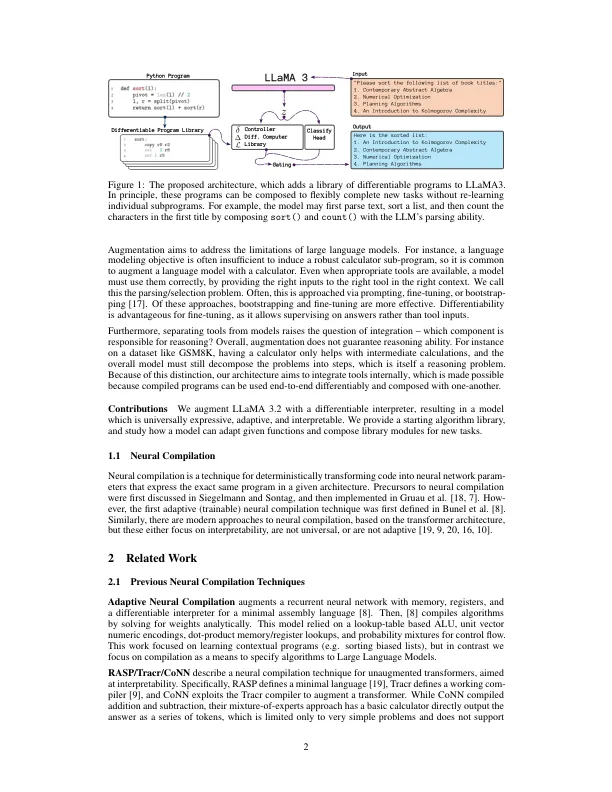

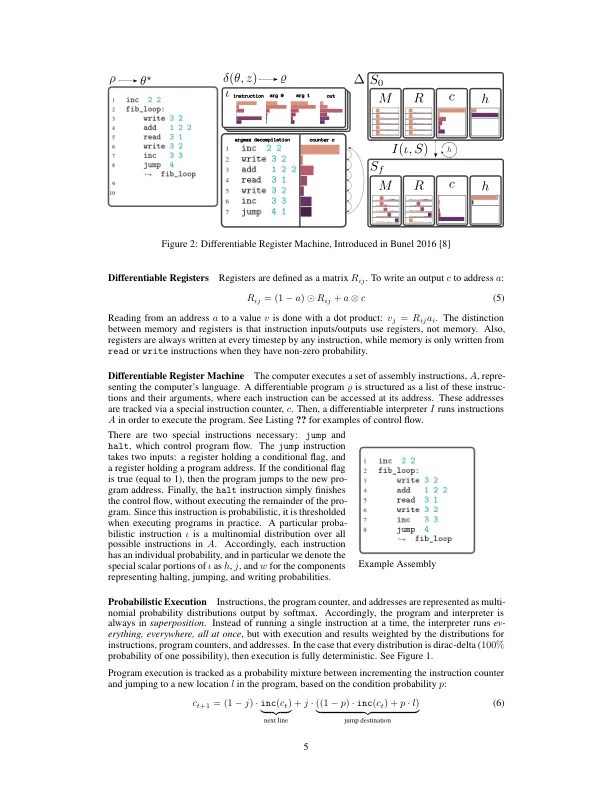

重要的推理任务(例如计划)从根本上是算法,这意味着解决这些任务需要牢固地诱导基本算法,而不是捷径。大语言模型由于神经网络优化算法,其优化数据和优化目标的局限性而缺乏真正的算法能力,但也由于变压器体系结构的不表现性。为了解决这种缺乏算法能力,我们的论文提出了使用内部推理模块增强LLMS。该模块包含一个基本操作和复杂的可区分程序的库,因此不需要从头开始学习通用算法。为了实现这一目标,我们将内存,寄存器,基本操作和自适应复发添加到基于Llama3.2的十亿参数变形金刚体系结构中。然后,我们定义了一种将算法直接编译为可区分的启动液体的方法,该算法本地使用并传播梯度以进行优化。在本文中,我们通过对具有可变计算深度的简单算法任务进行增强的Llama 3.2来研究这种增强的可行性,例如递归纤维纤维算法算法或插入。

与可合差的库增强语言模型

主要关键词