机构名称:

¥ 2.0

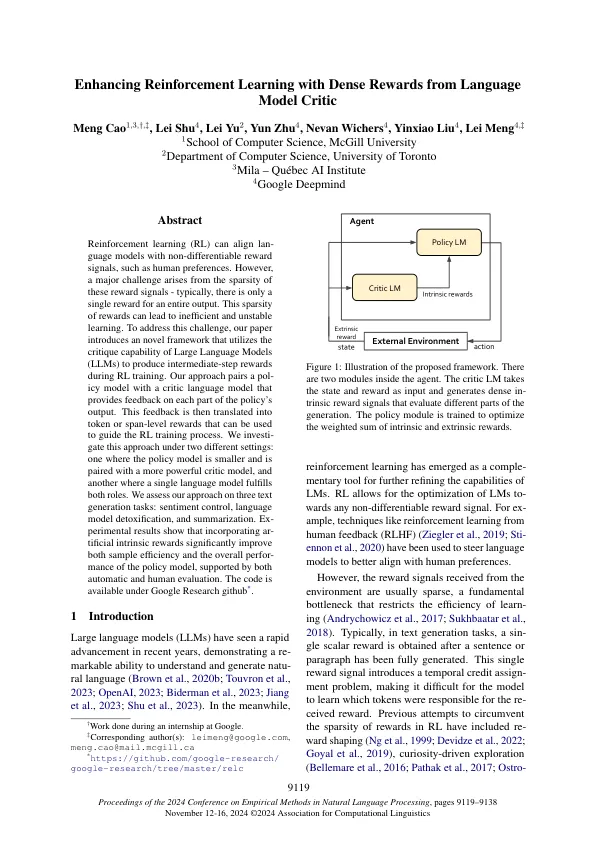

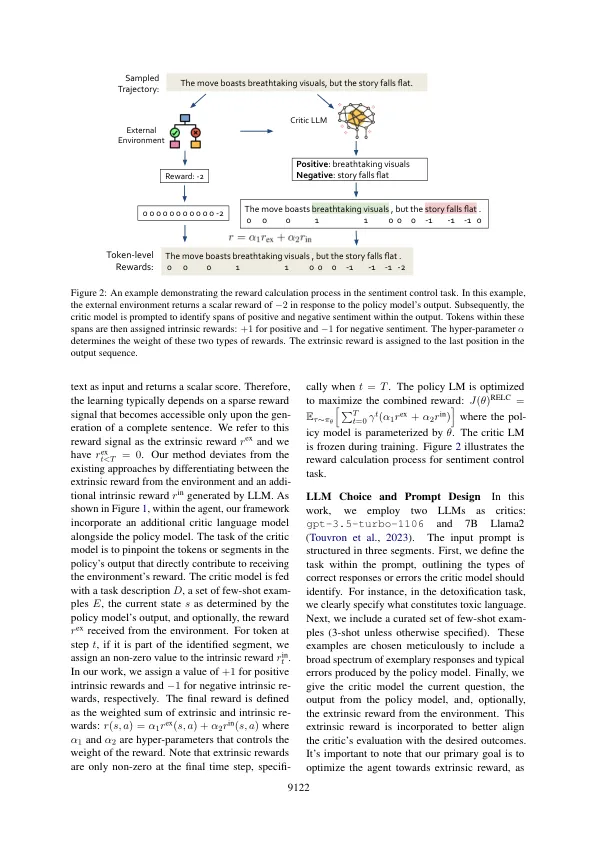

强化学习(RL)可以将语言模型与非不同的奖励信号(例如人类偏好)相结合。但是,这些奖励信号的稀疏性引起了一个重大挑战 - 通常,整个输出只有一个奖励。这种奖励的稀疏性会导致学习效率低下和不稳定的学习。为了应对这一挑战,我们的论文介绍了一个新颖的框架,该框架利用大型语言模型(LLM)的批评能力在RL培训期间产生中间步骤奖励。我们的方法将一个循环模型与批评语言模型配对,该模型可为策略输出的每个部分提供反馈。然后将此反馈转换为可用于指导RL训练过程的令牌或跨度奖励。我们在两个不同的设置下投资了这种方法:一种政策模型较小,并与更强大的评论家模型配对,而单一语言模型则履行两个角色的另一个。我们评估了三个文本生成任务的方法:情感控制,语言模型排毒和摘要。的结果表明,在自动评估和人类评估的支持下,纳入了人造的内在奖励可以显着提高样本效率和策略模型的整体绩效。该代码可在Google Research Github *下获得。

通过语言模型评论家浓厚的奖励增强增强学习