机构名称:

¥ 2.0

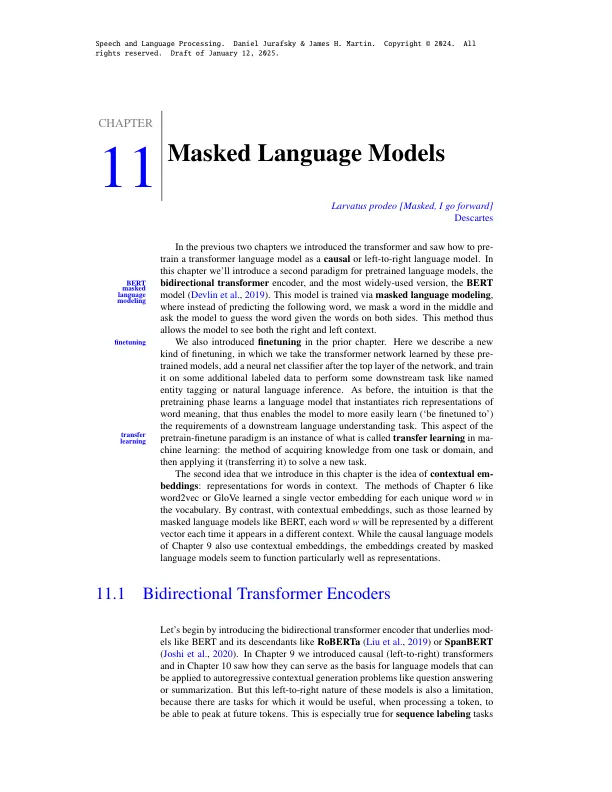

让我们首先讨论整体体系结构。基于双向变压器的语言模型在两种方式上与前几章中的因果变压器不同。首先是注意功能不是因果关系。我可以考虑以下令牌i + 1等。第二个是训练略有不同,因为我们在文本的中间预测了某些东西,而不是最后。我们将在此处讨论第一个和下一节中的第二个。图11.1 A,从第9章复制在此处,显示了第9章的左右方法中的信息流。每个令牌上的注意力计算基于上述(和当前)输入令牌,忽略了所考虑的令牌右侧的潜在有用信息。双向编码器通过允许注意机制在整个输入中进行范围来超越此限制,如图11.1 b。11.1 b。

11masked语言模型