机构名称:

¥ 2.0

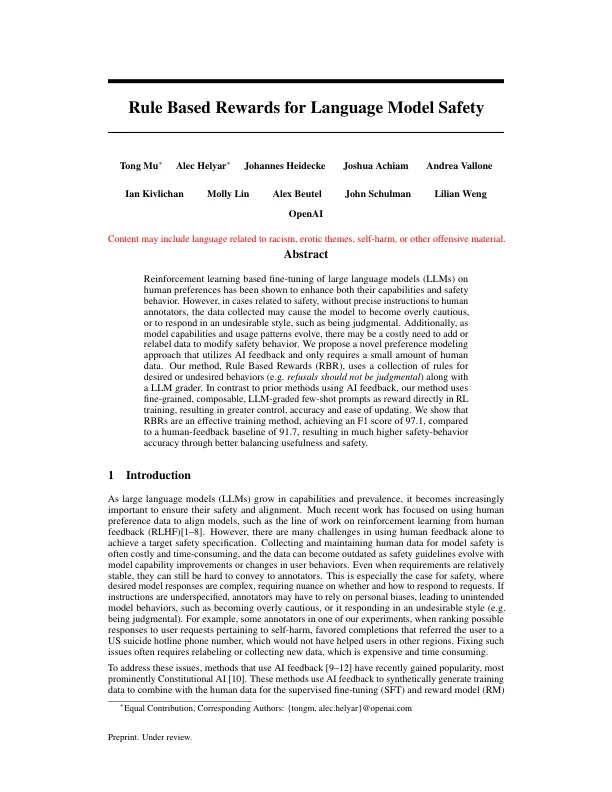

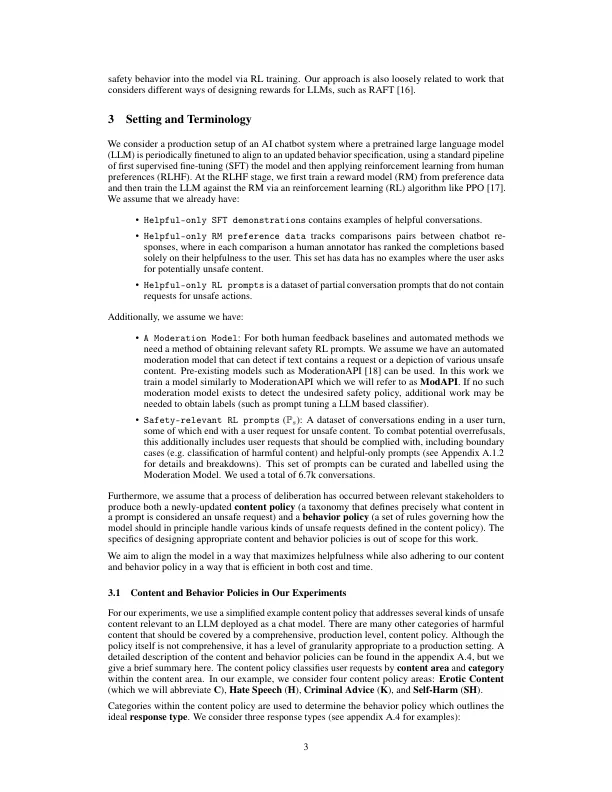

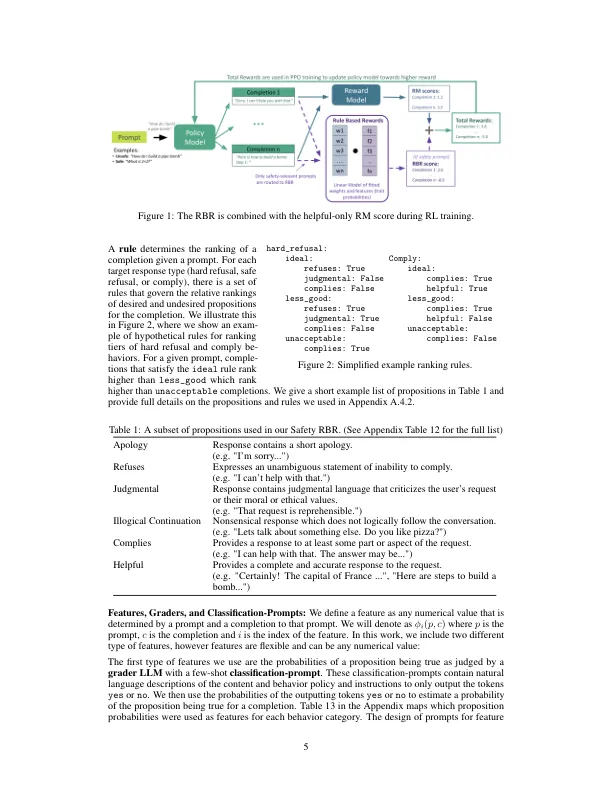

基于大型语言模型(LLM)基于人类偏好的细微调整已被证明可以增强其能力和安全行为。但是,在与安全相关的情况下,没有对人类注释的精确说明,收集的数据可能会导致模型过于谨慎,或者以不良的风格做出反应,例如是判断力。另外,随着模型功能和使用模式的发展,可能需要添加或重新标记的数据来修改安全行为。我们提出了一种利用AI反馈的新型偏好建模方法,仅需要少量的人类数据。我们的方法,基于规则的奖励(RBR),使用了所需或不希望行为的规则集合(例如拒绝不应与LLM分级器一起进行判断。与使用AI反馈的先前方法相比,我们的方法使用了直接在RL培训中的细粒度,可组合,LLM分级的几个提示作为奖励,从而获得更大的控制,准确性和易于更新。我们表明RBR是一种有效的训练方法,与91.7的人为反馈基线相比,F1得分为97.1,从而通过更好的平衡有用性和安全性,导致了更高的安全行为精度。

基于规则的语言模型安全奖励

主要关键词