XiaoMi-AI文件搜索系统

World File Search SystemMIA-能源法

系统可以将其交付给最终客户,但不包括电力供应; 10)天然气的分配是指气体通过本地或区域天然气管道系统的运输,以期向最终客户交付,其中不包括天然气供应; 11)热能的分布是指地区供暖和/或冷却的热能运输,或者通过分配系统的蒸汽,热水或冷却液的介质用于工业用途; 12)热能分销商是指进行热能分布活动的能量,以进行区域供暖和/或冷却; 13)分布式发电意味着与分配系统相关的电力设施中的发电; 14)在经济上合理的需求意味着需求不超过热能或冷却的需求,而根据市场规则,发电(不包括加油)的需求相比。15)经济优先级是指每个上升序列的出价排名的排名; 16)能源设施是指在该设施中发电,发电和/或气体的传播,油的分布,石油产品或汽油的储存以及热量的产生或发电或分布的设施; 17)原产地保证是指该电子文件,其专有功能是证明

《 AI框架法》及其...

此外,该法案还因优先考虑工业晋升而不是主动监管而受到批评,这导致没有针对高影响力AI的详细和有效的监管措施。与欧盟AI法案相比,该法对可能是不道德或社会有害的AI技术施加了更严格的制裁,该法案因缺乏同等保障措施而被犯错。也批评该法案未能为诸如AI应用程序引起的版权和数据隐私等问题提供足够的保护措施。在起草过程中,各种利益相关者引起了人们的关注。,例如,文化,体育和旅游部主任提出了一项宣言规定,要求披露与创意活动有关的AI学习数据。同样,包括韩国报纸协会在内的五个媒体组织敦促生成AI操作员透明地披露学习数据,并允许版权所有者适当访问它。但是,这些建议最终未包含在该法案的最终版本中。预计将来将通过下属法规或其他立法措施解决此类问题。

《气候变化法》,2020年

该集合中的立法已被复制,因为它最初是在《政府公报》上印刷的,并进行了改进的格式,并纠正了较小的印刷错误。所有修正案已直接应用于文本并注释。可以参考每一条立法的原始公报(包括修正案)。

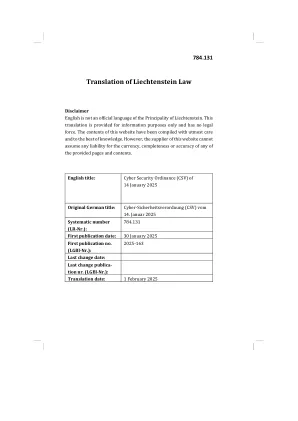

列支敦士登法的翻译

1指令(EU)2022/2555欧洲议会和2022年12月14日的理事会关于整个联盟的高公共网络安全措施,修改法规(EU)第910/2014号指令和指令(EU)2018/1972和2018/1972,以及2016/216/2116/2116/222.116/222.22.116/22222.22.116/222222222222.2222.116/2222222.2222222.116/2222222222222.22222.22222222222.116/2222222222222222222222222222222222EMS(OJ)(OJ)(OJ)(OJ)(OJ)(OJ)(OJ)(OJ) 27.12.2022,第80页)2法规(欧盟)2021/887欧洲议会和2021年5月20日的理事会建立了欧洲网络安全工业,技术和研究能力中心和国家协调中心网络关于ENISA(欧盟网络安全局)以及信息和通讯技术网络安全认证和废除法规(EU)2013年第526/2013号(Cybersecurity Act)(7.6.6.6.2019,第151页,第151页)

太空法评论

空间行业在2022年很忙。美国国家航空航天管理局的Artemis航天器终于到达了月球,为未来的月球勘探奠定了基础。Artemis 1将许多小型月球研究飞船(包括日本的Omotenashi Lunar Lander)作为次要有效载荷。韩国的第一个月球轨道丹努里(Danuri)是由猎鹰9火箭发射到太空中的,其中一枚还推出了日本公司Ispace的私人月球任务Hakuto-R Mission 1。2022年也一直在忙于太空旅游。Blue Origin的新Shepard在三个航班中乘坐下轨轨迹推出了六名乘客。SpaceX的船员龙太空胶囊发射是美国国际空间站的第一个美国太空旅游任务。船上的船员由公理空间操作的任务包括一名专业宇航员和三名游客。中国通过增加了奇尼亚和孟蒂安实验室模块,完成了天和空间站的建设。Wentian和Mengtian都成功发射并停靠到空间站。波音公司推出了其Starliner Space胶囊的第二次无人测试飞行。测试航班成功,将为Starliner在2023年的首次乘员测试飞行带来前进。我们还看到了该行业的预测合并,包括Viasat和Inmarsat之间的拟议合并以及OneWeb和Eutelsat之间的合并。这在2021年的联合国气候变化会议上达到了公共议程,更常见于COP26,也称为2022年的COP27。对我特别突出的是,近年来,尤其是在2022年,人们对我们在地球上生命的价值的价值以及空间是我们陆地生态系统的一部分的观点。清楚地证明了甲烷和碳测量值,监测和验证的空间应用值。是对保护地球和太空环境的迫切需求的日益认识。商业活动和轨道种群的增长对长期空间活动的可持续性产生了很大的影响。一些公司正在积极寻找符合空间碎片缓解标准和可持续性目标的清晰程序和流程的许可制度和监管机构。确认环境,社会和治理(ESG)目标的许可制度可以帮助公司提高融资,提供更好的保险风险,并可以允许其他司法管辖区的市场获得市场。实际上,联合国环境计划财务计划最近表示,将ESG问题整合到其投资分析中是公司信托义务的一部分。

太空法杂志

我们开始了一个新时代《太空法》杂志的新时代,该时代致力于空间资源利用的法律方面。密西西比大学法学院新转换的空中和太空法中心的重点是开发适当的国际协议和准则,这些协议和准则将促进和维持 - 而不是扼杀 - 新兴的太空经济,并缓解人类从独立地面陆地的过渡到空间。我们希望利用空间的资源来改善地球上的人类体验;我们还希望继续对空间的探索,包括在地球上建立人类社区,扩大我们对自己和宇宙的理解。随着我们超越地球轨道的飙升,在需要解决的法律问题中,主要问题是与“全人类省”中“ property”的特征有关的问题。这个问题提供了独特的观点,以供考虑和审议。包括在学术奖学金中,我们很高兴欢迎Hague国际太空资源治理小组的机构观点,该组织试图通过散布国际评估和审查的基础草案来推进讨论。此外,我们首次亮相了一项新功能:一本关于与太空相关的小说作品的轻松书评。我们选择从安迪·威尔(Andy Weir)的阿尔emis(Artemis)开始,并希望您能为威尔(Weir)的月亮愿景(Moon Vision)分析法律基础。最终,我希望这个问题以及我们将来的所有问题(随着我们返回一年一度的出版物),为可持续和成功的空间探索和使用做出了实质性的贡献。Michelle L.D.Michelle L.D.我希望引起辩论,并欢迎与太空法有关的所有顶级问题以及由太空中的人类活动引起的法律问题。一如既往地感谢我们所有勇敢的学生编辑,特别是高级编辑查尔斯·埃尔泽(Charles Ellzey),杰里米·格鲁纳特(Jeremy Grunert)和亨特·威廉姆斯(Hunter Williams)。Hanlon主编牛津,密西西比州2019年10月