XiaoMi-AI文件搜索系统

World File Search System4K全景摄像机,带自动跟踪技术

视野是指通过摄像头镜头可以看到的区域。它直接反映出远程加入的参与者可以看到多少会议空间。180 度的视野让桌子上的每个人都清晰可见,即使是靠近摄像头或坐在房间边缘的人。

显微镜的掩盖自动编码器是细胞生物学的可扩展学习者

为生物搜索中使用的显微镜图像仍然是一个重要的挑战,尤其是对于跨越数百万图像的大规模实验。这项工作探讨了经过越来越较大的模型骨架和显微镜数据集训练时,弱监督的clasifirers和自我监管的蒙版自动编码器(MAE)的缩放属性。我们的结果表明,基于VIT的MAE在一系列任务上的表现优于弱监督的分类器,在召回从公共数据库中策划的已知生物学关系时,相对实现的相对效果高达11.5%。此外,我们开发了一种新的通道敏捷的MAE架构(CA-MAE),该体系结构允许在推理时输入不同数字和通道的图像。我们证明,在不同的实验条件下,在不同的实验条件下,CA-MAE通过推断和评估在显微镜图像数据集(Jump-CP)上有效地概括了,与我们的训练数据(RPI-93M)相比,通道结构不同。我们的发现促使人们继续研究对显微镜数据进行自我监督学习,以创建强大的细胞生物学基础模型,这些模型有可能促进药物发现及其他方面的进步。与此工作发布的相关代码和选择模型可以在以下网址找到:https://github.com/ recursionpharma/maes_microscopy。

自动驾驶汽车可访问性法

残疾人经常面临独特的挑战,即获得现有的运输方式和基础设施方式。自动驾驶汽车(AVS)具有巨大的潜力,可以满足美国人未满足的流动需求。对于残疾人,AVS将提供新的出行选择和独立性,这尤其如此。但是,AVS并不整齐地适合驾驶员和乘客的传统法律结构,并且要求社区开始以不同的方式思考基础设施。《自动驾驶汽车可访问性法》将帮助残疾人更好地获得骑行骑行的行动性和独立性好处。

caspase-4二聚体和D289自动加工引起白介素-1β-转化酶更新乳腺癌中电流和新的潜在免疫疗法,从长凳到床边

在癌症免疫疗法中已经看到了令人印象深刻的进步。尽管乳腺癌(BC)长期以来一直被认为是非免疫原性的,但治疗BC治疗的免疫疗法现在已成为一种新的有希望的治疗方法,具有巨大的潜力。这得到了各种免疫疗法的大量完整和正在进行的临床前和临床研究的支持。然而,临床肿瘤学和基本癌症研究之间的显着差异会损害对癌症免疫学和免疫疗法的理解,从而阻碍了癌症治疗研究和发育。要以最佳的方式利用累积的可用数据,必须整合在卑诗省免疫疗法及其临床陷阱中发挥作用的两种基本机制。然后,临床试验必须经过精心设计,以适当的常规和免疫治疗策略组合。尽管有重大改进的空间,但此更新的评论详细介绍了迄今为止从长凳到床边可用的免疫治疗工具,希望这将导致重新思考和优化卑诗省患者的护理标准。

比较两个卷积神经网络模型用于脑癌类型的自动分类

国际医学与生物系统物理学学院6-8 2020年11月8日结论:Alexnet和Googlenet体系结构的比较,以对树类型进行分类

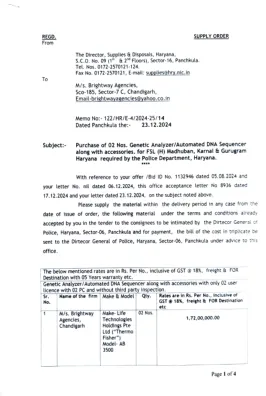

购买02号遗传分析仪/自动化DNA Sequencer以及配件。对于FSL(H)Madhuban,Karnal&Gurugram Haryana,需要P केंदीयलयलय 从教科书中学习任何三首诗。 •做5 ... 一个基于证据的排名,2024 全印度高等教育调查2021-22 KVDRDO生物学节日家庭作业2024年12月 3.0 Ojee的教学大纲 - 2025 b''

1。电气要求:220 V,AC 50Hz。2。基于聚合物的8个具有升级性的毛细血管,具有自动采样板系统的自动DNA分析仪/测序仪,具有6个基于染料或更好的化学。3。CCD或带有固态长寿命激光探测器的最新高级技术摄像头。4。应具有最新版本的设备操作和数据收集软件。供应商/供应商应免费提供所有随后的设备操作和数据收集软件升级,从供应之日起五年。制造商证书/承诺应附有技术规范提供文件。5。应具有最新版本的经过验证的软件,用于碎片尺寸(法医str,简短的串联重复,基于人类的标识),并提供其他两个用户许可证,以及每个LICERNSE的必要硬件,包括网络和连接性。该软件应具有具有广泛安全性的功能,并审核功能支持最新发表的研究论文。6。遗传分析仪应在国际准则(例如DNA分析方法(SWGDAM))等国际准则上进行法医DNA分析验证。7。仪器应为支持所有市售的STR套件的开放平台。供应商/供应商应在这方面提交合格证书。8。y-STR(100个反应)。9。10。对最终用户实验室科学家的现场培训。11。0q&PQ文档。应提供基质标准,聚合物容器,毛细管阵列(36厘米),阳极和阴极缓冲液,去离子甲酰胺,试剂和消耗品和塑料软件等以及Str套件,即常染色体 - STR(200反应)。供应商还应提供交钥匙解决方案,以功能化仪器,但不限于:合适的反振动工作台,微型固定,微型,涡流,合适的可变容量移液,96个井板板板微型中心,合适的容量存储设备,适用于具有4'C温度和-20*C温度范围的PCR套件的合适能力,可用于保持4'C和-20*C温度范围的适用量设备及其最佳性能。完整的智商完成现场验证研究。12。兼容Ontine UPS与一个小时的备份(7 kVa)。13。应提供合适的高质量彩色打印机。

迈向自动动力电池检测:新挑战基准数据集和基线

我们对一项名为动力电池检测(PBD)的新任务进行了全面的研究,该任务旨在从 X 射线图像中定位密集的阴极和阳极板端点,以评估动力电池的质量。现有制造商通常依靠人眼观察来完成 PBD,这使得很难平衡检测的准确性和效率。为了解决这个问题并让更多人关注这个有意义的任务,我们首先精心收集了一个称为 X 射线 PBD 的数据集,该数据集包含从 5 家制造商的数千个动力电池中选择的 1,500 张不同的 X 射线图像,具有 7 种不同的视觉干扰。然后,我们提出了一种基于分割的新型 PBD 解决方案,称为多维协作网络(MDCNet)。借助线和计数预测器,可以在语义和细节方面改进点分割分支的表示。此外,我们设计了一种有效的距离自适应掩模生成策略,可以缓解由板分布密度不一致引起的视觉挑战,从而为 MDCNet 提供稳定的监督。无需任何花哨的修饰,我们基于分割的 MDCNet 始终优于其他各种角点检测、人群计数和基于一般/微小物体检测的解决方案,使其成为有助于促进 PBD 未来研究的强大基础。最后,我们分享了一些潜在的困难和未来研究的工作。源代码和数据集将在 X-ray PBD 上公开提供。

数据、IoT+、AI 和自动化白皮书.pptx - Procept

● 让您的专业员工从单调乏味且耗时的任务中解放出来:将智能技术融入工作场所可消除单调乏味、重复且耗时的任务。您的专业团队可以专注于充分利用他们的技能和专业知识。这大大提高了工作满意度,因为他们可以腾出时间进行更高层次的问题解决、批判性思考和决策。

根据批发定价实现电动汽车自动充电

● 客户主要喜欢“设置后就忘”的体验,即充电时自动找到最佳充电时间,主要关注的是尽量降低成本,而环境考虑是次要的。● 人们强烈希望更清楚地了解电动汽车充电成本,尤其是占家庭能源总支出的比例。● 虽然控制系统受到高度评价,但如果客户对技术有信心并认为它可靠有效,那么控制系统就变得不那么重要了。● 大多数人都喜欢尽可能地利用自己的太阳能进行充电。

Merlin Entertainments的自动报告-Finfo

突出显示碳足迹跟踪Merlin Entertainment没有适当的系统来跟踪商业服务所产生的碳足迹,从而阻碍了他们评估和减轻环境影响的能力。增加员工敬业度员工对IT团队的满意度较低,因为与商业服务相关的成本和环境注意事项的参与度不足和沟通。创建清晰的成本知名度有限的与商务手机,印刷和硬件资产相关的成本可见性,阻碍了员工识别改进和节省成本的领域的能力。促进了更大的环境责任感,而没有对碳足迹的准确见解,培养与Merlin Entertainment价值观相符的环境责任文化是一项挑战。