机构名称:

¥ 1.0

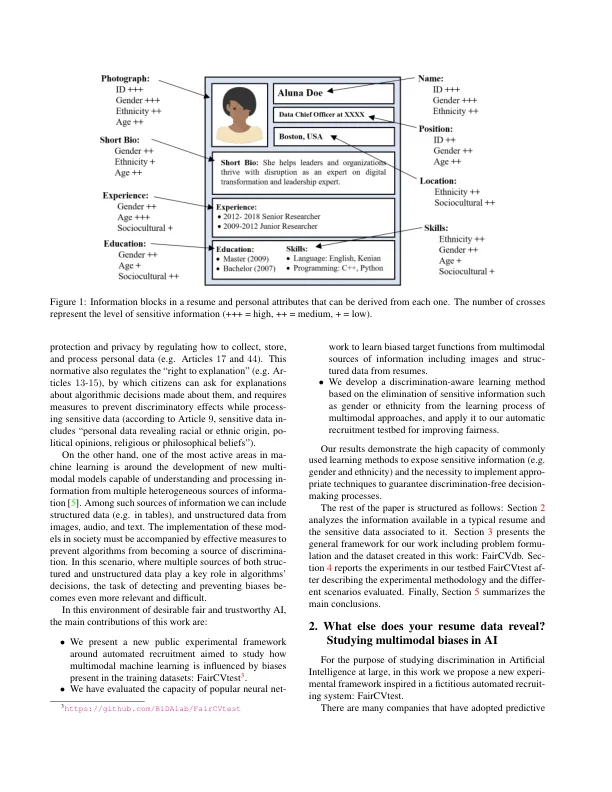

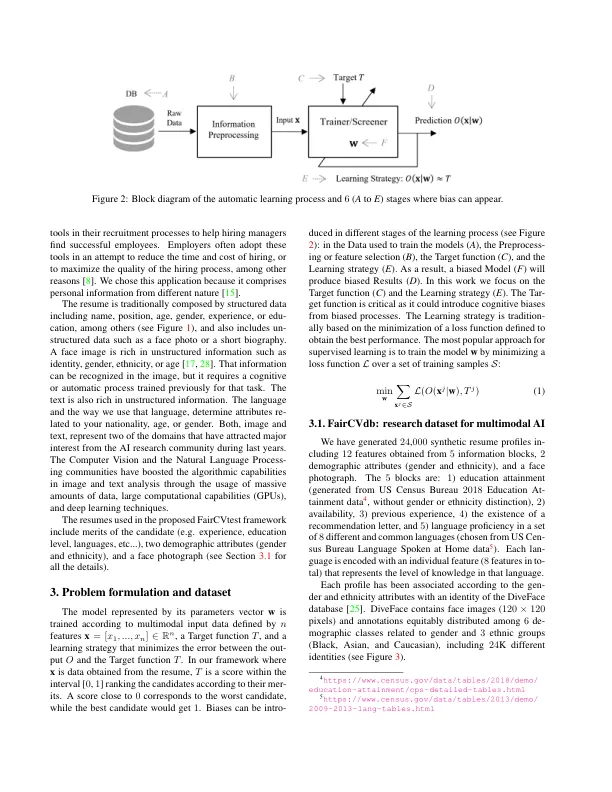

决策算法在社会中的存在感如今正在迅速增加,同时人们也开始担心其透明度以及这些算法可能成为新的歧视来源。事实上,许多相关的自动化系统已被证明会根据敏感信息做出决策或歧视某些社会群体(例如,某些用于人员识别的生物特征识别系统)。为了研究当前基于异构信息源的多模态算法如何受到数据中的敏感元素和内部偏见的影响,我们提出了一个虚构的自动招聘测试平台:FairCVtest。我们使用一组有意识地以性别和种族偏见进行评分的多模态合成档案来训练自动招聘算法。FairCVtest 展示了此类招聘工具背后的人工智能(AI)从非结构化数据中提取敏感信息并以不良(不公平)的方式将其与数据偏见结合起来的能力。最后,我们列出了最近开发能够从深度学习架构的决策过程中删除敏感信息的技术的列表。我们使用其中一种算法(SensitiveNets)来实验歧视感知学习,以消除我们多模态 AI 框架中的敏感信息。我们的方法和结果展示了如何生成更公平的基于 AI 的工具,特别是更公平的自动招聘系统。

多模态人工智能中的偏见:公平自动招聘的试验台

主要关键词