机构名称:

¥ 1.0

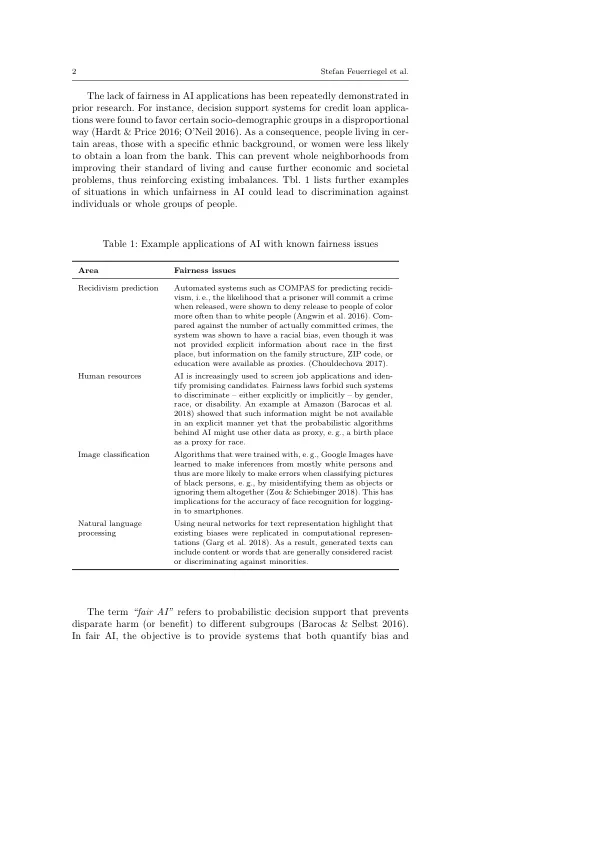

减轻对亚群体的歧视。1 人们可能倾向于认为,只需从决策支持系统中省略敏感属性也能解决公平问题。然而,这是一个常见的误解:一些非敏感属性充当了代理(例如,工资是性别的代理,邮政编码是民族的代理,家庭结构是种族或宗教的代理),因此,即使不了解敏感属性的决策支持系统也被认为是不公平的。本文的目的是向信息系统从业者和研究人员介绍“公平的人工智能”。如上所述,信息系统内有多个领域容易出现不公平现象。事实上,信息系统维持甚至强化了人工智能中现有的不公平现象,而不是减轻它。在依赖这样的信息系统时,企业和组织面临着巨大的法律风险。在这方面,世界各地的立法机构都在实施法律,禁止在算法决策中进行差别对待(White & Case 2017);例如,在美国,公平贷款法对风险评分中的算法偏见进行惩罚,而在欧盟,人工智能的责任由通用数据保护条例(GDPR)强制执行。因此,实现公平的人工智能对于歧视的潜在受害者和依赖人工智能进行决策支持系统的机构都至关重要。最近的报告指出,企业、组织和政府对公平人工智能的采用已经落后(AI Now Institute 2018)。正如我们稍后讨论的,这种进展缓慢的潜在原因在于信息系统的所有维度,即人(例如信任)、技术(例如设计原则、经济影响)和组织(例如治理)。在以下章节中,本文将回顾公平的理论概念,将它们与人工智能的公平性联系起来,并为信息系统研究提出建议。

公平的人工智能

主要关键词