XiaoMi-AI文件搜索系统

World File Search System在 7T 人类神经影像数据预测中对各种人工视觉模型进行大规模基准测试

机器视觉和认知神经成像技术的快速同步发展为(重新)评估人类视觉系统人工模型的现状提供了无与伦比的机会。在这里,我们对 85 种现代深度神经网络模型(例如 CLIP、BarlowTwins、Mask-RCNN)进行了大规模基准分析,以强大的统计能力表征架构和训练任务的差异如何影响对人类视觉系统 16 个不同区域的 fMRI 活动的预测。我们发现:第一,即使是鲜明的架构差异(例如 Transformers 和 MLP-mixer 中没有卷积)对大脑数据的紧急拟合也影响很小;第二,任务的差异有明显的影响——分类和自监督模型显示出相对更强的大脑预测能力;第三,特征重新加权可显着提高大脑预测能力,而不会过度拟合——产生模型到大脑的回归权重,这些权重在数千张新图像中对大脑反应的预测能力达到相同的水平。广义上,这项工作展示了现代深度神经网络模型的特征空间与人类视觉系统固有的表征结构之间出现的对应关系的概况。

利用自然文本监督的视觉模型进行MRI检索,字幕,分类和视觉问题回答

摘要 - 大型多模型现在已在全球范围内广泛使用,最强大的模型在大规模的通用数据集中受过训练。尽管它们迅速部署,但仍关注培训数据的质量和领域相关性,尤其是在放射学,医学研究和神经科学方面。此外,当查询接受医疗数据训练的模型时,医疗保健数据隐私至关重要,有关服务托管和数据存储的透明度也是如此。到目前为止,放射学研究中的大多数深度学习算法旨在执行特定任务(例如诊断分类),并且不能提示使用自然语言执行多个任务。在这项工作中,我们引入了一个基于矢量检索和对比度学习的框架,以通过自然语言监督有效地学习视觉脑MRI概念。我们展示了该方法如何通过联合嵌入和自然语言监督来识别影响阿尔茨海默氏病(AD)的大脑的因素。首先,我们使用自我监督的学习预处理文本和图像编码器,并共同微调这些编码器以开发共享的嵌入空间。我们训练模型执行多个任务,包括MRI检索,MRI字幕和MRI分类。我们通过开发检索和重新排列的机制以及用于视觉问题回答的变压器解码器来显示其多功能性。

查看,比较,决定:通过多视图的多路推理减轻大型视觉模型中的幻觉

最近,大型视觉模型(LVLM)在多模式上下文理解中表现出了令人印象深刻的能力。但是,他们仍然遭受幻觉问题,即与图像内容产生不一致的输出。为了减轻幻觉,先前的研究主要集中于使用自定义数据集对LVLM进行重新培训。al-尽管有效,但它们本质上带有额外的计算成本。在本文中,我们提出了一个无培训的框架MVP,旨在通过通过Multimi-v iew Multi-p ath的理由来减少LVLMS的天生能力来减少幻觉。具体来说,我们首先设计了一种多视图信息寻求信息的策略,以彻底了解IMEAM中的全面信息,该信息丰富了原始愿景编码器在LVLMS中捕获的一般全球信息。此外,在答案解码期间,我们为每种信息视图提出了多路推理,以量化和集结多个解码路径中每个电位的确定性得分,并效法确定输出答案。通过完全掌握图像中的信息,并在解码时仔细考虑了潜在的范围的确定性,我们的MVP可以有效地减少LVLM中的幻觉。广泛的实验证明了我们提出的MVP可以显着减轻四个众所周知的LVLM的幻觉概率。更重要的是,MVP是插件,可以与其他解码方法集成,以进行更多的增强。源代码可在以下网址提供:https://github.com/gasolsun36/mvp。

通过鼓励一致的基于梯度的解释来改善视觉接地

我们提出了一种基于保证金的损失,用于调整联合视觉语言模型,以便其基于梯度的解释与人类为相对较小的接地数据集提供的区域级注释一致。我们将这一目标作为注意掩盖一致性(AMC),并证明它比以前依靠使用视觉模型来评分对象检测器的输出的方法产生了较高的视觉接地结果。尤其是,在标准视觉模型目标之上训练AMC的模型获得了86的最新精度。在Flickr30k视觉接地基准中49%,绝对改进为5。38%与在相同水平的监督下训练的最佳先前型号时。我们的方法在既定的基准中都表现出色,可以在易于测试中获得80.34%的准确性,而在较难分裂中获得了80.34%的准确性,而在易于测试中的精度为64.55%。AMC有效,易于实现,并且是一般的,因为任何视觉模型都可以采用,并且可以使用任何类型的区域注释。

使用前瞻性代表性数据

目的:本研究使用来自印度南部的前瞻性代表性数据集来开发和评估多模式机器学习模型,以区分细菌和真菌性角膜炎。设计:机器学习分类器培训和验证研究。参与者:印度马杜赖(Madurai)的Aravind Eye Hospital诊断出患有急性感染性角膜炎的五百九十九名受试者。方法:我们使用了前瞻性的,连续收集的,代表性的数据集(Madurai数据集)收集的前瞻性,连续收集的代表性数据集,并比较了3种预测模型,以区分细菌和真菌角膜炎。这些模型包括一个临床数据模型,使用效率网状结构的计算机视觉模型以及将成像和临床数据都结合在一起的多模式模型。我们将Madurai数据集分为70%的火车/验证和30%的测试集。进行了模型训练,并进行了五重交叉验证。我们还比较了由Madurai训练的计算机视觉模型的性能与具有相同架构的模型,但对从多个先前的细菌和真菌性角膜炎随机临床试验(RCT)(RCT训练的计算机视觉模型)进行了培训。主要结果指标:主要评估度量是Precision-Recall曲线(AUPRC)下的面积。二级指标包括接收器操作特征曲线(AUROC),准确性和F1分数下的区域。与计算机视觉模型相比,多模式模型并不能显着提高性能。眼科科学2025; 5:100665ª2024,美国眼科学会。结果:由Madurai训练的计算机视觉模型优于临床数据模型和持有测试集的RCT训练的计算机视觉模型,其AUPRC 0.94(95%的置信间隔:0.92 E 0.96),AUROC 0.81(0.76 E 0.85)(0.76 E 0.85)(0.76 E 0.85),精度为77%和F1 0.85。结论:传染性角膜炎的表现最佳的机器学习分类是使用Madurai数据集训练的计算机视觉模型。这些发现表明,基于图像的深度学习可以显着增强感染性角膜炎的诊断能力,并强调使用前瞻性,连续收集的,代表性的机器学习模型培训和评估的重要性。财务披露:本文末尾的脚注和透视性可以在脚注和验证中找到。这是CC BY-NC-ND许可证(http://creativecommons.org/licenses/by-nc-nd/4.0/)下的开放访问文章。

控制...

视觉语言模型(例如剪辑)对零拍或无标签预测的各种下流任务显示出很大的影响。但是,当涉及到低级视觉时,例如图像恢复其性能会由于输入损坏而急剧下降。在本文中,我们提出了一种退化感知的视觉模型(DA-CLIP),以更好地将预验证的视觉模型转移到低级视觉任务中,作为用于图像恢复的多任务框架。更具体地说,DA-CLIP训练一个额外的控制器,该控制器适应固定的剪辑图像编码器以预测高质量的特征嵌入。通过通过交叉注意将床上用品集成到图像恢复网络中,我们能够试行该模型以学习高保真图像重建。控制器本身还将输出与输入的真实损坏相匹配的降级功能,从而为不同的降解类型产生天然分类器。此外,我们将混合降解数据集与合成字幕结构为DA-CLIP训练。我们的方法在特定于降解和统一的图像恢复任务上提高了最先进的性能,显示出具有大规模预处理视觉模型促使图像恢复的有希望的方向。我们的代码可在https://github.com/algolzw/daclip-uir上找到。

视觉和语言模型是否共享概念?向量空间对齐研究

另一些人则认为,语言模型具有推理语义,但没有指称语义(Rapaport,2002;Sahlgren 和 Carlsson,2021;Piantadosi 和 Hill,2022),3 而一些人则认为,至少对于直接对话的聊天机器人来说,一种外部指称语义是可能的(Cappelen 和 Dever,2021;Butlin,2021;Mollo 和 Milli`ere,2023;Mandelkern 和 Linzen,2023)。然而,大多数研究人员都认为,语言模型“缺乏将话语与世界联系起来的能力”(Bender 和 Koller,2020),因为它们没有“世界的心理模型”(Mitchell 和 Krakauer,2023)。这项研究提供了相反的证据:语言模型和计算机视觉模型 (VM) 是在独立的数据源上进行训练的(至少对于无监督的计算机视觉模型而言)。唯一的共同偏见来源是世界。如果 LM 和 VM 表现出相似性,那一定是因为它们都对世界进行了建模。我们通过测量不同 LM 和 VM 的几何形状的相似性来检查它们学习到的表示。我们始终发现,LM 越好,它们诱导的表示就越类似于计算机视觉模型诱导的表示。这两个空间之间的相似性使得我们能够从一组非常小的并行示例中将 VM 表示线性投影到语言空间并检索高度准确的字幕,如图 1 中的示例所示。

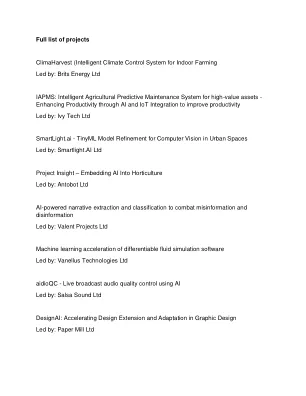

Brits Energy Ltd IAPMS

便携式Aifibres-使用先进的深度学习,计算机视觉模型,多光谱传感器和自动化机器人技术来开发便携式,易于使用的扫描和排序系统,用于垃圾服装和面料

2025 WY/Co-TWS会议研讨会描述

描述:本研讨会的主要目的是向参与者介绍开源计算机视觉模型用于分析相机陷阱图像的应用。该研讨会旨在提供动手经验,以获取免费的云计算资源来部署和解释这些模型,以增强野生动植物监测和研究。虽然相机陷阱可以进行全面的野生动植物监测,但尽管此任务的耗时,许多研究人员仍会手动查看相机陷阱图像。存在几种开源模型来自动化这些任务,但是很难实施这些模型并验证其性能。Western Ecosystems,Inc。(West)的机器学习团队擅长开发和部署来自相机陷阱图像,无人机镜头和声学数据的动物和栖息地检测的计算机视觉模型。我们期待有机会分享我们的专业知识,并通过使用尖端的计算机视觉技术来帮助推进野生动植物监测的领域。一些编程经验将有所帮助。参与者应尽可能带上笔记本电脑。