XiaoMi-AI文件搜索系统

World File Search System什么时候我们不需要更大的视觉模型?

摘要。扩大视觉模型的规模已成为获得更强大的视觉表示形式的事实上的标准。在这项工作中,我们讨论了不需要更大的视力模型的观点。首先,我们演示了S镇定的S平原的力量(S 2),从而预先训练和冷冻较小的视力模型(例如,,vit-b或vit-l),在多个图像尺度上运行,可以胜过较大的模型(例如,VIT-H或VIT-G)在分类,分割,深度估计,多模式LLM(MLLM)基准和机器人操作中进行分类,分割,深度估计。值得注意的是,S 2在V ∗基准上的MLLM详细了解中实现了最先进的性能,超过了诸如GPT-4V之类的模型。我们检查了S 2是与模型尺寸的缩放相比,S 2是首选缩放方法。虽然较大的模型在硬性示例上具有更好的概括,但我们表明,多尺度较小模型的模型可以很好地近似较大的视觉模型。这表明当前大型预训练模型所学的大多数(如果不是全部)也可以从多尺度较小的模型中获得。我们的结果表明,多尺度较小的模型具有与较大模型的可比学习能力,并且具有S 2的预训练较小模型可以匹配甚至超过较大模型的优势。我们发布了一个可以在任何视觉模型上应用一条代码的python软件包:https://github.com/bfshi/scaling_on_scales。

评估双向图像上的视觉模型

Bistable图像,也称为模棱两可的图像或可逆图像,显示了视觉刺激,尽管观察者并非同时,但可以在两个不同的解释中看到。在这项研究中,我们使用可动的图像对视觉模型进行了最广泛的检查。我们手动收集了一个数据集,其中包括29张Bissable图像以及它们的相关标签,并在亮度,色彩,旋转和分辨率方面进行了121种不同的操作。我们评估了六个模型体系结构的分类和属性任务中的十二个不同模型。我们的发现表明,除了来自Idefics家族和llava1.5-13b的模型外,在模型之间,一个相对于另一个相对于另一个相对于另一个相对于图像操作的差异的明显偏爱,对图像旋转的例外很少。另外,我们将模型的偏好与人类进行了比较,并指出这些模型并没有与人类相同的连续性偏见,并且通常与人类初始解释有所不同。我们还调查了提示中的变化和使用同义标签的影响,发现与图像训练数据相比,这些因素明显更多的是模型的解释,而不是图像较高的图像表现出对Bissable图像解释的影响更高。所有代码和数据都是开源的1。

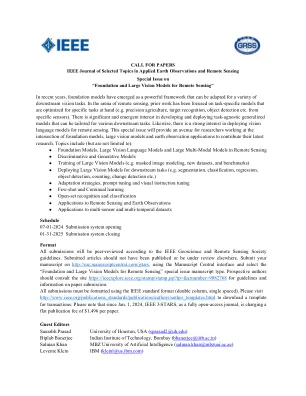

遥感的基础和大型视觉模型

近年来,基础模型已成为一个强大的框架,可以适应各种下游视觉任务。在遥感领域,先前的工作集中在特定于特定任务的特定任务模型上(例如,精确农业,目标识别,对象检测等来自特定的传感器)。在开发和部署任务不合时宜的通用模型中具有重大且新兴的兴趣,这些模型可以针对各种下游任务进行定制。同样,对部署视觉语言模型进行遥感也很感兴趣。本期特刊将为在基础模型,大型视觉模型和地球观察应用的交集中工作的研究人员提供途径,以贡献其最新研究。主题包括(但不限于):

基于以上为中心的视觉模型,基于便携式实时智能助手

图4。Egovideo-VL模型的概述。 eGovideo-VL是一种旨在实时自我中心的理解和援助的多模式视觉语言模型。 该模型包含五个关键组件:(1)遵循Egovideo [58]的设计模态编码器,并包括一个视频编码器和用于多模式特征提取的文本编码器; (2)存储模块,该模块存储历史上下文以实现时间基础,摘要和个性化互动; (3)大型语言模型(LLM),该模型执行多模式推理和响应生成; (4)生成模块,该模块综合了视觉动作预测,以指导用户完成任务; (5)检索模块,该模块检索第三人称专家演示以补充以自我为中心的理解。Egovideo-VL模型的概述。eGovideo-VL是一种旨在实时自我中心的理解和援助的多模式视觉语言模型。该模型包含五个关键组件:(1)遵循Egovideo [58]的设计模态编码器,并包括一个视频编码器和用于多模式特征提取的文本编码器; (2)存储模块,该模块存储历史上下文以实现时间基础,摘要和个性化互动; (3)大型语言模型(LLM),该模型执行多模式推理和响应生成; (4)生成模块,该模块综合了视觉动作预测,以指导用户完成任务; (5)检索模块,该模块检索第三人称专家演示以补充以自我为中心的理解。

将预训练的视觉模型适应相机原始图像

摘要。SRGB图像现在是计算机视觉研究中预训练视觉模型的主要选择,这是由于它们的易用性和效果存储。同时,原始图像的优点在于它们在可变的现实世界中的较丰富的物理信息。对于基于相机原始数据的计算机视觉任务,大多数现有研究采用了将图像信号处理器(ISP)与后端网络集成的方法,但经常忽略ISP阶段和后续网络之间的相互作用功能。从NLP和CV区域中正在进行的适配器研究中汲取灵感,我们介绍了Raw-Adapter,这是一种旨在将SRGB预先训练的模型调整为相机原始数据的新颖方法。RAW-ADAPTER包括输入级适配器,这些适配器采用可学习的ISP阶段来进行AD-RAW输入,以及模型级别的适配器,以在ISP阶段和随后的高级网络之间建立连接。此外,Raw-Adapter是一个可以在各种Compoter Vision Frameworks中使用的通用框架。在不同的照明条件下进行了丰富的实验,已经显示了我们算法的最先进(SOTA)绩效,证明了其在一系列现实世界和合成数据集中的有效性和效率。代码可在此URL上找到。

screenai:一个用于UI和信息图表的视觉模型

屏幕用户界面(UIS)和信息图表,分享类似的视觉语言和设计原则,在人类通信和人机互动中起重要作用。我们介绍了Screenai,这是一个专门研究UI和信息图表理解的视觉语言模型。我们的模型通过Pix2-Struct的浮雕修补策略改进了Pali体系结构,并通过数据集的独特混合物进行了培训。该混合物的核心是一项新颖的屏幕注释任务,模型必须在其中识别UI元素的类型和位置。我们使用这些文本注释将抄写屏幕屏幕截止到大型语言模型,并通过大规模生成问题索问题(QA),UI导航和摘要培训数据集。我们进行消融研究,以证明这些设计选择的影响。在仅5b个选项中,Screenai在基于UI的和信息图表的任务(乘法DOCVQA,WebSRC和Motif)以及与Simi-lar尺寸的模型相比,在其他基于UI-和信息图表的任务(乘法DOCVQA,WebSRC和Motif)方面取得了新的最先进的结果。最后,我们发布了三个新数据集:一个专注于屏幕注释任务,而两个专注于问题回答的others。

在视觉模型中测量和改善思想链推理

台式标记,以测量VLM的零射门原因和一致性。我们评估了最新的VLM,发现即使表现最佳的模型也无法证明强大的视觉推理能力和一致性,这表明需要进行基础努力以使VLMS能够系统地和始终如一地像人类一样执行视觉推理。作为早期一步,我们提出了一个两阶段的培训框架,旨在提高VLM的推理和一致性而没有人类注释。该框架由两个主要阶段组成:监督的微调和从反馈中学习,以指导VLMS生成既有一致性又扎根的推理链。我们的框架工作在推理性能和一致性方面表现出4%的相对改善。我们在https://github.com/ yangyi-chen/cotconsistency上发布数据集。

嵌入式系统的计算机视觉模型压缩技术:调查

摘要 - 深度神经网络在大多数计算机视觉问题中一直始终代表最新技术。在这些情况下,较大且更复杂的模型表现出优于较小架构的性能,尤其是在接受大量代表性数据培训时。随着视觉变压器(VIT)架构的最新采用和广告卷积神经网络(CNN),领先的主链体系结构的参数总数从2012年的6200万参数增加到ALEXNET的6200万参数,到2024年AIM-7B的2024年参数。因此,部署这样的深度体系结构在处理和运行时限制的环境中面临挑战,尤其是在嵌入式系统中。本文涵盖了用于计算机视觉任务的主要模型压缩技术,使现代模型可以用于嵌入式系统中。我们介绍了压缩亚地区的特征,比较不同的方法,并讨论如何在各种嵌入式设备上分析它时选择最佳技术和预期变化。我们还共享代码,以协助研究人员和新从业人员克服每个子区域的初始实施挑战,并为模型压缩带来现有趋势。压缩模型的案例研究可在https://github.com/venturusbr/cv-model-compression上获得。索引术语 - 安装系统,模型压缩,知识蒸馏,网络修剪,网络量化

有用的Doggybot:使用腿部机器人和视觉模型

摘要 - 基于学习的方法已经实现了四足动力的强大性能。然而,一些挑战阻止了四足动物学习需要与环境和人类互动的有用室内技能:缺乏操纵的最终效果,仅使用模拟数据使用有限的语义介绍,以及在室内环境中的较低的遍历性和可及性。我们提出了一个在室内环境中进行四足动物移动操作的系统。它使用前式握把进行对象操纵,这是一种低级控制器,在模拟中培训了以egile的深度进行训练,以攀登和全身倾斜等敏捷技能,以及预先训练的视觉语言模型(VLMS),并具有第三人称Fisheye和Egentric RGB摄像头,以探索fishereye和Egincentric RGB摄像头,以进行儿子理解和指挥生成。我们在两个看不见的环境中评估了我们的系统,而没有任何现实数据收集或培训。我们的系统可以零射对这些环境并完成任务,例如遵循用户的命令在攀登女王大小的床上,成功率为60%。

ee/cs/cns 148b-大语言和视觉模型

大型语言和视觉模型正在改变我们处理和生成文本和图像的方式。模型,例如GPT-3,对大量文本和图像数据进行了培训,已在各种语言任务上达到了类似人类的性能。这有可能改变许多人类活动,包括教学,工业和科学。了解这些模型的工作方式以及如何使用它们可以导致人工智能和自然语言处理的新突破。研究大语言模型还可以提供有关人类交流的见解,并有助于我们对语言,图片,思想和智慧之间复杂关系的理解。班级有三个目标:向Caltech学生提供深入的LLVMS介绍探索LLVMS在科学上的应用开发教学材料进行动手探索和学习