XiaoMi-AI文件搜索系统

World File Search System全动态视频 (FMV) 人工智能

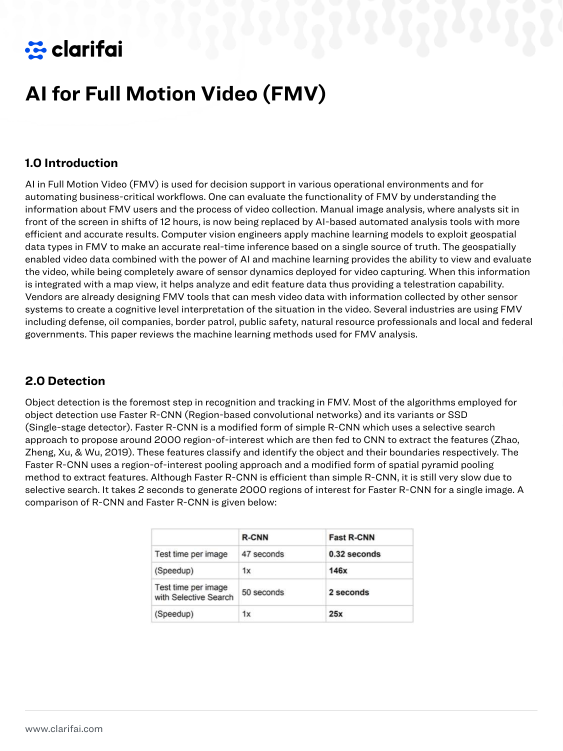

2021 年 12 月 31 日——全动态视频 (FMV) 中的人工智能用于各种运营环境中的决策支持和业务关键型工作流程的自动化。

具有扩散模型的生成文本视频检索

现有的文本视频检索解决方案本质上是侧重于最大程度地提高条件可能性的模型,即P(候选人|查询)。虽然很简单,但这种事实上的范式却忽略了基本的数据分布p(查询),这使得识别出分布数据的挑战。为了解决这一限制,我们从生成观点创造性地解决了此任务,并将文本和视频之间的相关性建模为其关节概率P(候选人,查询)。这是通过基于扩散的文本视频检索框架(扩散-RET)来完成的,该框架将检索任务建模为从噪声中产生关节分布的过程。在训练过程中,从发电和犯罪的角度优化了Diffusionret,其发电机通过生成损失优化,并且具有对比度损失的训练的特征提取器。以这种方式,diffusionret巧妙地杠杆化了生成和歧视方法的优势。在五个常用的文本检索基准测试中进行了广泛的实验,包括MSRVTT,LSMDC,MSVD,ActivityNet字幕和DIDEMO,并具有出色的性能,证明了我们方法的效果。更加谨慎,没有任何修改,diffusionret甚至在外域检索设置中表现良好。我们认为这项工作带来了对相关领域的基本见解。代码可从https://github.com/jpthu17/diffusionret获得。

开放式视频视频异常检测

当前的视频异常检测(VAD)方法本质上仅限于封闭设置的设置,并且可能在开放世界应用程序中遇到困难,在培训期间,测试数据中可能存在异常类别。最近的一些研究试图解决更现实的开放式VAD,该研究旨在解散视为异常和正常视频的看不见异常。但是,尽管这种能力对于构建更明智的视频监视系统至关重要,但这种设置着重于预测框架异常得分,没有识别异常类别的能力。本文进一步迈出了一步,并探讨了开放词汇视频异常检测(OVVAD),我们的目的是利用预训练的大型模型来检测和cate-可见和看不见的异常。为此,我们提出了一个模型,该模型将OVVAD分解为两个相互构成的任务 - 类不足的检测和特定于类的分类 - 并共同优化了这两个任务。特别是,我们设计了一个语义知识注入模块,以从大语言模型中引入语义知识以进行检测任务,并设计一种新型的异常合成模块,以在大型视觉生成模型的帮助下生成伪异常视频,以实现分类任务。这些语义知识和综合异常大大扩展了我们模型在检测和分类各种可见和看不见的异常方面的能力。对三个广泛使用的基准测试的实验实验实现了我们的模型在OVVAD任务上实现了最新的性能。

单眼视频的动态头部重建

我们提出了来自单眼RGB视频的动态3D头部重建的单眼神经参数头模型(Mono NPHM)。到此为止,我们提出了一个潜在的空间空间,该空间在神经参数模型的顶部参数化纹理场。我们限制了预测的颜色阀与基础几何形状相关,以便RGB的梯度有效地影响反向渲染过程中的潜在几何代码。为了提高表达空间的代表能力,我们使用超二维增强了向后变形场,从而在拓扑具有挑战性的表达式中显示出颜色和几何表示。使用Mono NPHM作为先验,我们使用基于符号距离字段的体积渲染来处理3D头重建的任务。通过nu毫无反转,我们使用面部锚点构成了具有里程碑意义的损失,这些损失与我们的规范几何表示紧密相关。为了评估单眼RGB视频的动态面部重建任务,我们在休闲条件下记录了20个具有挑战性的Kinect序列。单nphm超过 -

视频监控信息

根据 2016/679 号条例 (EU) 第 13 和 14 条规定的视频监控信息,Sicilbanca Credito Cooperativo Italiano - Società Cooperativa(注册办事处位于卡尔塔尼塞塔 Via Francesco Crispi 25,CF 01438930859 PI 02529020220,卡尔塔尼塞塔公司注册号为 70559)(以下简称“公司”或“所有者”)希望通过本文件(“信息”)向您告知处理您的个人数据的目的和方法,以及 2016/679 号条例 (EU) 关于保护自然人、处理个人数据及其自由流通(“GDPR”)赋予您的权利。 1 与视频监控相关的处理目的 数据控制者可能会处理与场所内进行的视频录制相关的您的个人数据。通过视频监控手段获取的个人数据的处理旨在保护客户、公司人员和访问这些数据的个人的安全,以及保护公司资产免遭可能的侵犯、盗窃、抢劫或破坏行为。使用摄像机的法律基础是合法利益。摄像机的放置位置将拍摄范围限制在可能受到公司组织外部个人的非法或其他有害行为风险的区域。在某些情况下,所检测到的图像会被记录并存储一段时间,以达到上述目的,并且在任何情况下,存储时间不超过一周,除非担保人关于保护个人数据的适用规定允许更长的期限,或者可能需要满足司法机关或司法警察对正在进行的调查活动的具体要求。在预期的保留期结束时,记录的图像将从相关的电子、计算机或磁性媒体中删除。检测和记录是在不拦截通信或对话的情况下进行的,并且不会将图像与可以识别相关方的其他元素交织在一起。进入数据控制者的场所需要强制对相关方进行视频记录。反对执行拍摄将导致公司无法跟进您的合同前/合同中的要求。 2 视频录像传输的对象(接收者) 录制的图像存储在电子或磁性媒体上,只能由公司专门指定的人员和外部公司进行处理,作为数据控制者,他们合作维护系统并开展私人监视活动: - Zabut investigazioni di Gulotta Matteo,总部位于 Sambuca di Sicilia via Mulè c.le Salvato n.6。 - 2858 Security srl,注册办事处位于 Misterbianco (ct) via Carlo Marx 57。 - Secur Point srl,注册办事处位于 S. Cataldo (cl), via E. Tricomi 11。 - OSTI di Vincenzo Uricolo,注册办事处位于 S. Margherita di Belice (ag),partment 156 lot 8。根据司法机关或司法警察的命令,图像还会在数据控制者结构之外进行传达和传播。 3 利益相关方的权利 关于本通知中描述的处理,作为利益相关方,您可以

带有扩散模型的视频插值-CVF Open Access

我们提出了Vidim,这是一个视频间隔的生成模型,该模型在启动和最终框架下创建了简短的视频。为了实现高保真度并在输入数据中产生了看不见的信息,Vidim使用级联的分化模型首先以低分辨率生成目标视频,然后在低分辨率生成的视频上生成高分辨率视频。我们将视频插补的先前最新方法归纳为先前的最新方法,并在大多数设置中演示了这种作品如何在基础运动是复杂,非线性或模棱两可的情况下失败,而Vidim可以轻松处理此类情况。我们还展示了如何在开始和最终框架上进行无分类器指导,并在原始高分辨率框架上调节超级分辨率模型,而没有其他参数可以解锁高保真性结果。vidim可以从共同降低所有要生成的框架,每个扩散模型都需要少于十亿个pa-rameters来产生引人注目的结果,并且仍然可以在较大的参数计数下享有可扩展性和提高质量。请在vidim- Interpolation.github.io上查看我们的项目页面。

基于视频的情感并影响上下文数据集中的跟踪

人类情感识别一直是心理物理学和计算机视觉的重要主题。但是,经常发布的数据集有许多局限性。进行检查,大多数数据集都包含仅包含有关面部表情的信息的框架。由于以前的数据集的局限性,很难理解影响人类识别的机制,或者在这些数据集中训练的计算机视觉模型上对人类的识别良好。在这项工作中,我们介绍了一个全新的大型数据集,基于视频的情感并影响上下文数据集(VEATIC)中的跟踪,可以征服先前数据集的限制。Veatic在好莱坞电影,纪录片和家庭视频中有124个视频片段,并通过实时注释进行了连续的价和唤醒评级。与数据集一起,我们采用了一项新的计算机视觉任务,以通过每个视频框架中的上下文和字符信息来推断所选字符的影响。此外,我们提出了一个简单的模型来基准这项新的计算机视觉任务。我们还使用数据集与其他类似数据集进行了预处理模型的性能。实验显示了通过VEATIC验证的模型的竞争结果,表明VEATIC的普遍性。我们的数据集可从https://veatic.github.io获得。

3D多帧融合视频稳定

在本文中,我们提出了RSTAB,这是视频稳定框架的新型框架,该框架通过音量渲染整合了3D多帧融合。与传统方法背道而驰,我们引入了一个3D多框架透视图,以进行稳定的图像,从而解决了全框架生成的挑战,同时保存结构。我们的RSTAB框架的核心在于S Tabilized R Endering(SR),该卷渲染模块,在3D空间中融合了多帧信息。具体来说,SR涉及通过投影从多个帧中旋转的特征和颜色,将它们融合到描述符中以呈现稳定的图像。然而,扭曲的信息的精度取决于降低的准确性,这是受染色体区域显着影响的因素。为了响应,我们介绍了a daptive r ay r ange(arr)模块以整合深度先验,并自适应地定义了投影过程的采样范围。在方面上,我们提出了以光流的光流限制的限制,以进行精确的颜色,以实现精确的颜色。多亏了这三个模块,我们的rstab示例表现出了卓越的性能,与以前的视野(FOV),图像质量和视频稳定性相比,各种数据集的稳定器相比。

ma-lmm:长期视频理解的内存大型多模型

随着大型语言模型(LLM)的成功,将视觉模型融入了LLM,以建立视觉语言基础模型最近引起了人们的兴趣。但是,现有的基于LLM的大型多模式模型(例如,视频播放,视频聊天)只能摄入有限数量的框架以进行简短的视频理解。在这项研究中,我们主要专注于设计一个有效有效的模型,以进行长期视频理解。我们建议以在线方式处理视频并将过去的视频信息存储在存储库中,而不是像大多数现有作品一样尝试同时进行更多框架。这使我们的模型可以参考历史视频内容以进行长期分析,而不会超过LLM的上下文长度约束或GPU内存限制。我们的内存库可以以现成的方式被缝制到当前的多模式LLMS中。我们在各种视频理解任务上进行了广泛的实验,例如长期介绍,视频问题答案和视频字幕,我们的模型可以在多个数据集中实现最新的性能。

随机视频审查报告 - 芝加哥警察指令

官员是否观察到表现出屈尊的态度,指导任何人的贬义词,使用语言或采取旨在嘲笑或贬低个人的行动,包括使用种族主义或贬义语言?是的,没有观察到