XiaoMi-AI文件搜索系统

World File Search System人工智能有害言论的责任在哪里?

生成式人工智能,尤其是基于文本的“基础模型”(在包括互联网在内的大量信息上训练的大型模型),可以生成在各种责任制度下可能存在问题的言论。机器学习从业者定期对模型进行“红队”测试,以识别和缓解此类有问题的言论:从错误地指控他人严重不当行为的“幻觉”到制造原子弹的配方。一个关键问题是,这些红队行为是否真的会根据美国法律对模型创建者和部署者造成任何责任风险,从而激励对安全机制的投资。我们研究了三种责任制度,将它们与红队模型行为的常见例子联系起来:诽谤、与犯罪行为相关的言论和非正常死亡。我们发现,任何第 230 条豁免分析或下游责任分析都与算法设计的技术细节密切相关。而且,要真正找到对生成言论负责的模型(及其相关方),还存在许多障碍。我们认为人工智能不应该

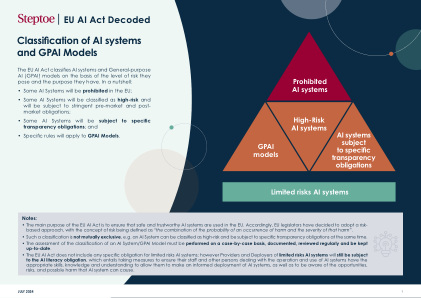

AI 系统和 GPAI 模型的分类

注: • 欧盟人工智能法案的主要目的是确保在欧盟使用安全可靠的人工智能系统。因此,欧盟立法者决定采取基于风险的方法,将风险的概念定义为“发生伤害的概率与伤害严重程度的组合”。 • 这种分类并不互相排斥,例如,一个人工智能系统可以被归类为高风险,同时又要承担特定的透明度义务。 • 对人工智能系统/GPAI模型的分类评估必须逐案进行,记录在案,定期审查并保持最新。 • 欧盟人工智能法案不包括对有限风险人工智能系统的任何具体义务;然而,有限风险人工智能系统的提供者和部署者仍将受人工智能素养义务的约束,该义务需要采取措施确保其员工和其他涉及人工智能系统操作和使用的人员具备适当的技能、知识和理解,使他们能够明智地部署人工智能系统,并意识到人工智能系统可能带来的机会、风险和可能的危害。

制定印度AI系统的责任制度

AI系统的责任问题集中在确定开发人员,部署者和用户应对AI技术造成的伤害负责的程度上。随着AI系统变得更加普遍,潜在的危害也是如此,例如工业机器人造成的深层危险或伤害。在减轻这些风险和促进经济机会之间取得平衡至关重要。责任通常受合同或侵权原则的约束。但是,关于制定针对AI系统的责任制度的争论。这些包括一个核心问题,即严格的责任(负责开发人员)还是基于故障的责任(证明过失)是更合适的。严格的责任支持者认为,通常对AI风险有更多了解的开发人员应承担责任,而Park(2024)等其他人则认为,广义责任规则可能不会说明AI的各种情况。此外,关于现有责任规则是否可以充分解决与AI相关的危害的辩论,其中一些主张量身定制的方法以避免“责任差距”。但是,一些学者认为,当前的伤害原则可以处理AI风险,而无需新规则。

Peter Henderson,Tatsunori Hashimoto,Mark Lemley

Peter Henderson,Tatsunori Hashimoto,Mark Lemley * Generative AI,特别是基于文本的“基础模型”(在包括Internet在内的大量信息中训练的大型模型)可能会在各种责任方面产生有问题的语音。机器学习从业人员定期“红色团队”模型来识别和减轻这种有问题的语音:从错误地指责人们严重不当行为的“幻觉”到建造原子弹的食谱。一个关键问题是,这些红色团队的行为是否实际上对根据美国法律规定的模型创建者和部署者构成了任何责任风险,从而激励对安全机制的投资。我们检查了三个责任制度,将它们与红色团队模型行为的常见例子联系在一起:诽谤,言语与犯罪行为不可或缺的言论和不法死亡。我们发现,任何第230节的免疫分析或下游责任分析都紧密包裹在算法设计的技术细节中。,还有许多障碍可以真正寻找模型(及其相关政党)的责任。我们认为,在这些情况下,AI不应明确免受责任,并且随着法院应对平台算法已经精细元素的复杂性,上面有索尼尔问题的生成AI织机的技术细节。法院和政策制定者应仔细考虑他们在评估这些问题时创造的技术设计激励措施。

美国:BSA 致弗吉尼亚州众议院拨款委员会关于 HB 2094 的信

2025 年 1 月 28 日 尊敬的 Luke E. Torian 弗吉尼亚州众议院拨款委员会 北 9 街 201 号,大会大楼 12 楼 弗吉尼亚州里士满 23219 尊敬的 Torian 主席和众议院拨款委员会成员, 商业软件联盟很高兴有机会分享企业软件部门对人工智能 (AI) 和《高风险人工智能开发者和部署者法案》(HB 2094) 的见解。BSA 是全球软件行业的领先倡导者。1 BSA 成员处于开发尖端服务的前沿,其产品被经济各个领域各种规模的企业使用。2 AI 正在改变我们的生活和工作方式,并带来现实世界的益处。要发挥 AI 的潜力,需要相信该技术是负责任地开发和部署的。制定促进负责任地使用人工智能并防止滥用的人工智能立法是当今最重要的技术问题之一,我们已经看到各国政府开始着手解决这个问题,包括欧盟和科罗拉多州。解决这个问题最有效的方法是通过一项单一的国家法律。然而,正如各州率先采用消费者隐私法一样,我们认识到各州再次在人工智能立法方面处于领先地位。当您考虑如何通过 HB 2094 来规范人工智能时,我们希望强调确保任何人工智能立法都为公司创建周到、明确的护栏并保护消费者的重要性。为了实现这一目标,我们强烈建议制定人工智能立法:

人工智能炒作的机制及其对地球和社会造成的成本

摘要 全球新兴技术格局日益受到人工智能 (AI) 炒作的影响,这一现象对当今正在创建的全球 AI 叙事具有重大的大规模影响。本文旨在根据其核心机制剖析 AI 炒作现象,将当前浪潮与历史 AI 炒作进行比较,得出结论:当前的炒作在量级、规模以及地球和社会成本方面是历史上无与伦比的。我们识别并讨论了助长 AI 炒作的社会技术机制,包括拟人化、自称 AI“专家”的人数激增、地缘政治和私营部门的“害怕错过”趋势以及新兴技术中“AI”一词的过度使用和误用。本文的第二部分试图强调当前 AI 炒作经常被忽视的成本。我们研究了它的地球成本,因为 AI 炒作对有限的资源和能源消耗施加了巨大压力。此外,我们还关注人工智能炒作与社会经济不公正之间的联系,包括通过巨大的财富再分配和人类智能成本来延续社会不平等。在结论中,我们提供了关于如何减轻未来人工智能炒作的影响的见解。我们提出了关于开发者、监管者、部署者和公众如何驾驭人工智能炒作、创新、投资和科学探索之间关系的建议,同时应对关键的社会和环境挑战。

人工智能风险管理标准概况(一般...

我们主要希望本简介文档供大型、最先进的 GPAIS 开发人员使用。对于 GPAIS 开发人员,本简介文档有助于遵守或使用领先的 AI 风险管理相关标准,并旨在促进遵守即将出台的《欧盟 AI 法案》等相关法规,特别是与 GPAIS 相关的方面。(但是,本简介并未提供特定行业或应用中的 GPAIS 应用程序可能需要的所有指导。)其他可以从本指南中受益的人包括:基于 GPAIS 平台构建的最终用途应用程序的下游开发人员; GPAIS 的评估者;以及监管界。本文档可以为 GPAIS 部署者、评估者和监管者提供有用的信息,以评估此类 AI 系统的开发人员在多大程度上遵循了相关的最佳实践。使用本简介中最佳实践的广泛规范有助于确保 GPAIS 开发人员能够保持竞争力,同时又不损害人工智能安全、保障、问责制和相关问题的实践。最终,本简介旨在帮助日益通用的人工智能系统价值链中的关键参与者实现最大化利益和最小化负面影响的结果,对个人、社区、组织、社会和地球都是如此。这包括保护人权、最大限度地减少负面环境影响以及预防在社会范围内造成系统性或灾难性后果的不利事件。

人工智能与共享繁荣的机遇 2024.1.31

人工智能 (AI) 的最新进展标志着人类历史上的一个转折点。它为机器学习、适应和执行任务提供了机会,这些任务有可能帮助人们完成日常活动以及最具创造性和雄心勃勃的项目。它还可能帮助企业和组织利用知识、提高生产力、创新、转型和推动共同繁荣。这一巨大潜力引发了两个基本问题:(1) 人工智能是否真的会推动国家和全球经济转型和增长,从而造福整个社会?(2) 我们必须解决哪些问题才能充分实现人工智能的经济价值、扩大繁荣并改善世界各地的生活?我们通过考虑近期技术和创新的历史来探讨这些问题,以此作为人工智能可能产生的影响的指导,以及我们必须做些什么才能实现其造福社会的经济潜力。虽然我们并不认为未来会完全像过去一样——原因我们将在下文讨论——但我们确实相信,以往的技术变革经验可以提供许多有用的教训。我们得出的结论是,尽管人工智能的发展为我们的经济繁荣和未来福祉提供了历史性机遇,但其经济效益不会自动产生,除非我们齐心协力、有目的地采取行动,发挥人工智能的潜力并应对其挑战,否则人工智能可能会加剧现有的经济挑战。我们建议制定一项集体政策议程,让人工智能的开发者、部署者和用户、基础设施提供商、政策制定者和参与劳动力培训的人参与其中,这可能有助于实现和利用人工智能的经济潜力,并应对其对我们共同繁荣的风险。

附件 – 完善监管清单

• 根据《人工智能法》 27 ,需要制定几项指导方针。其中一些指导方针还有望明确可能在未来六个月内开始适用的条款(即关于定义的条款和关于禁止实践的条款)。还需要在提供高风险人工智能系统具体示例的指导方针方面开展重要工作。如果人工智能的提供者和部署者事先不知道他们必须遵守哪些义务,他们可能会不愿意投资人工智能和其他技术。这确实有可能阻碍单一市场的创新和竞争。尽管如此,在指导方针出台之前,委员会在致候任委员 Roxana Mînzatu 的信函 28 中宣布了一项关于工作场所算法管理的倡议。这意味着在制定具体示例之前,存在一个法律空白,而《人工智能法》或《GDPR》并未涵盖该空白。 • 《森林砍伐条例》、《建筑产品和网络弹性法》忽视了经济运营商之间合理且相称的责任划分。 29 如果分销部门无法控制其分销产品的生产、设计或标准,并且没有首先将其投放到市场上,那么让分销部门承担责任就超出了该部门的影响范围。应根据《欧盟产品法》中《一般产品安全规则》中规定的生产者、制造商和进口商之间普遍适用和普遍接受的划分来分配责任。当将监管供应链的责任交给分销商时,这同样适用,因为这应该是执法机构的职责。

BSA 关于弗吉尼亚州 HB 2094 的信

2025 年 1 月 24 日 尊敬的米歇尔·洛佩斯·马尔多纳多 弗吉尼亚州众议院 议会大厦 北 9 街 201 号 弗吉尼亚州里士满 23219 尊敬的马尔多纳多代表: 商业软件联盟很高兴有机会分享企业软件部门对人工智能 (AI) 和《高风险人工智能开发者和部署者法案》(HB 2094)的见解。BSA 是全球软件行业的主要倡导者。1BSA 成员处于开发尖端服务的前沿,其产品被经济各个领域各种规模的企业使用。2人工智能正在改变我们的生活和工作方式,并具有现实世界的好处。要发挥人工智能的潜力,需要相信该技术是负责任地开发和部署的。制定促进负责任地使用人工智能并防止滥用的人工智能立法是当今最重要的技术问题之一,我们已经看到各国政府开始着手解决这一问题,包括欧盟和科罗拉多州的政府。解决这个问题最有效的方法是通过一项单一的国家法律。然而,正如各州率先通过消费者隐私法一样,我们认识到各州再次在人工智能立法方面处于领先地位。当您考虑如何通过 HB 2094 来监管人工智能时,我们希望强调确保任何人工智能立法都为公司创造周到、明确的护栏并保护消费者的重要性。为实现这一目标,我们强烈建议制定人工智能立法: