XiaoMi-AI文件搜索系统

World File Search System使用人工智能和机器学习进行遗产图像分类

“使用人工智能和机器学习对遗产图像进行分类”项目的目标是创建一种自动分类旧图像的方法。目标是使用机器学习和人工智能根据照片的历史和文化相关性对其进行准确分析。通过自动化图像分类过程,该计划旨在加快历史照片的保存和可访问性。使用深度学习技术,将研究照片的特征,以便将它们分类为相关类别,例如建筑、文物、绘画、雕塑或历史古迹。由此产生的自动分类系统将通过实现高效的检索和查询,帮助保存和推广我们的文化历史。该项目的目标是通过整合尖端技术彻底改变环境的管理和保护。关键词:遗产图像、自动分类、人工智能、机器学习、深度学习算法、图像特征、分类、建筑、文物、绘画、雕塑、历史地标、可搜索数据库、保存、可访问性、文化遗产、保护、文化文物和历史。

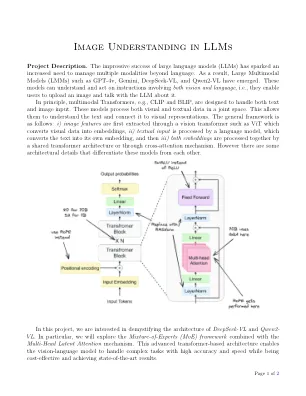

LLMS中的图像理解

项目描述。大型语言模型(LLMS)的令人印象深刻的成功引发了管理多种方式以外的多种方式的需求。结果,已经出现了大型多模型(LMM),例如GPT-4V,GEMINI,DEEPSEEK-VL和QWEN2-VL。这些模型可以理解涉及视觉和语言的说明并采取行动,即,它们使用户能够上传图像并与LLM讨论。原则上,多模式变压器(例如剪辑和碎片)旨在处理文本和图像输入。这些模型在关节空间中处理视觉和文本数据。这使他们可以理解文本并将其连接到视觉表示。一般框架如下:i)图像特征首先是通过视觉变压器(例如VIT)提取的,该vit将视觉数据转换为嵌入,ii)文本输入由语言模型处理,该模型将文本模型转换为自己的嵌入,然后iiii iii)通过共享的变压器结构或通过交叉说明机构将两个嵌入式处理在一起。但是,有一些架构细节将这些模型彼此区分。

针对儿童脑白质研究的可分析且质量可控的资源

我们创建了一套资源,用于基于健康脑网络 (HBN) 研究的公开扩散 MRI (dMRI) 数据开展研究。首先,我们将 HBN dMRI 数据 (N = 2747) 整理到脑成像数据结构中,并根据最佳实践对其进行预处理,包括去噪和校正运动效应、与磁化率相关的失真和涡流。预处理后可供分析的数据已公开。数据质量在 dMRI 分析中起着关键作用。为了优化 QC 并将其扩展到这个大型数据集,我们通过专家评分的小型数据子集和社区科学家评分的大型数据集的组合来训练神经网络。该网络在保留集 (ROC-AUC = 0.947) 上执行的 QC 与专家的 QC 高度一致。对神经网络的进一步分析表明,它依赖于与 QC 相关的图像特征。总而言之,这项工作既为推动大脑连接和儿童心理健康的跨诊断研究提供了资源,也为大型数据集的自动化质量控制建立了新的范式。

基于空间转录组数据的预处理的超图模型的组织病理学图像的生存分析

摘要。生存分析对于乳腺癌治疗中的临床决策和预后至关重要。最近的多模式方法利用组织病理学图像和大量RNA-Seq来提高生存预测性能,但是这些方法无法在细胞水平上探索空间分离。在这项工作中,我们提出了一个多模式超图神经网络,用于生存分析(MHNN-SURV),该神经网络涉及空间转录组预测的预训练模型。该方法的特征是完全使用组织病理学图像来揭示形态学和遗传信息,从而改善了异质性的解释。具体来说,MHNN-SURV首先将全片成像(WSI)切成斑块图像,然后分别提取图像特征并分别预测空间转录组。sub-sub-因此,基于图像的超图是基于三维最近的邻于关系构建的,而基于基因的超图是基于基因表达相似性而形成的。通过融合双重超图,MHNN-SURV使用COX比例危害模型对乳腺癌进行了深入的生存分析。实验结果表明,在生存分析中,MHNN-SURV优于最先进的多模式模型。

D3mciAD:利用句法图像生成和神经网络进行数据驱动的轻度认知障碍诊断

摘要。阿尔茨海默病是一种无法治愈的慢性神经系统疾病 (NLD),会影响人类记忆力,并随着大脑区域的萎缩而丧失认知思维能力。早期发现阿尔茨海默病 (AD) 是延缓其影响的唯一希望。本研究设计了一种计算机辅助自动检测方法,可以从磁共振图像扫描中检测出 AD 的轻度认知障碍。数据驱动的解决方案需要大量带注释的图像才能进行诊断。然而,获取大量带注释的数据用于医疗应用是一项艰巨的任务。我们利用深度卷积生成对抗网络 (DCGAN) 来合成高质量图像以增加数据集大小。微调的 CNN(VGG16 架构)模型对图像进行处理,以提取直观的特征以进行早期诊断。VGG16 提取的图像特征输入到支持向量机进行分类。本研究进行了大量实验来验证所提出的方法在公共数据集上的表现优于相对基线。

使用CNN和LSTM

抽象提供的脚本使用图像数据集实现了图像字幕模型。该体系结构结合了用于图像特征提取的RESNET50卷积神经网络(CNN)和用于处理单词序列的长期短期内存网络(LSTM)。阅读和清洁字幕后,脚本预处理数据,使用Resnet50提取图像功能,并准备培训和测试数据集。该模型旨在预测给定图像的字幕,并结合了手套中的单词嵌入。脚本还涉及创建单词到索引和索引到字映射,定义模型体系结构,并使用用于数据加载的生成器训练模型。训练利用图像特征和单词序列的组合,并使用测试图像上的BLEU分数评估模型。总体方法反映了图像字幕的深度学习范式,利用视觉和语言信息来产生描述性字幕。RESNET50 CNN充当强大的功能提取器,LSTM捕获了语言的顺序依赖性,从而产生了全面的图像字幕模型。

IH-ViT:基于视觉变压器的集成电路问世

摘要:针对传统检测方法在IC外观缺陷检测中存在的识别率不高、识别速度慢的问题,提出一种IC外观缺陷检测算法IH-ViT。提出的模型利用CNN和ViT各自的优势,从局部和全局两个角度获取图像特征,最终将两种特征融合进行决策判断缺陷类别,从而获得更高的IC缺陷识别准确率。针对IC外观缺陷主要体现在细节上的差异,传统算法难以识别的问题,对传统ViT进行了改进,在batch内部进行了额外的卷积操作。针对数据集来源多样导致的样本信息不平衡问题,采用双通道图像分割技术,进一步提高IC外观缺陷的识别准确率。最后经过测试,提出的混合IH-ViT模型取得了72.51%的准确率,比单独的ResNet50和ViT模型分别提高了2.8%和6.06%。所提算法可以快速准确地检测出IC外观缺陷状况,有效提高IC封测企业的生产效率。

通过混合特征提取进行脑肿瘤识别...

脑肿瘤的识别是一个关键步骤,依赖于医生的专业知识和能力。为了让放射科医生能够发现脑肿瘤,自动肿瘤排列非常重要。本文提出了一种 MR 脑图像分割和分类技术,以识别图像的正常和异常。所提出的技术是一种混合特征提取,旨在增强分类结果,基本上包括三个阶段。第一阶段使用 3 级离散小波变换 (DWT) 提取图像特征。在第二阶段,应用主成分分析 (PCA) 来减小特征的大小。最后,使用随机森林分类器 (RF) 和特征选择进行识别。收集了 181 张 MR 脑图像(81 张正常和 100 张异常),在区分正常和异常组织方面,实验结果获得了 98% 的准确率,灵敏度达到 99.2%,特异性达到 97.8%,并与多种文献进行了比较,证明了所提出的技术的有效性。结果表明3L-DWT+PCA+RF仍然取得了最好的分类效果,该模型可以应用于脑MRI球体分类,在一定程度上可以帮助医生判断肿瘤是正常还是异常。

arxiv:2407.21654v1 [cs.cv] 2024年7月31日

摘要。最近的方法表明,诸如剪辑之类的大规模视觉模型可以改善语义分割性能。这些方法通常是针对像素级视觉语言对准的,但通常依赖于剪辑中的低分辨率图像特征,从而导致沿边界的类歧义。此外,剪辑文本嵌入中的全局场景代表与本地和详细的像素级特征直接相关,从而使有意义的对齐变得更加困难。为了解决这些局限性,我们介绍了MTA-CLIP,这是一个采用面具级别视觉语言对准的新型框架。具体来说,我们首先提出了掩码文本解码器,该解码器使用夹夹语言模型使用丰富的文本数据来增强掩码代表。接下来,它使用掩码到文本对比度学习将蒙版表示与文本嵌入一致。此外,我们介绍了蒙版 - 文本提示学习,利用多个上下文特定的提示文本嵌入来捕获跨口罩的各种班级表示。总体而言,MTA-CLIP可以实现最先进的工作,在标准基准数据集,ADE20K和CityScapes上平均超过2.8%和1.3%。

sparsedff:稀疏视图特征蒸馏

人类表现出非常出色的技能,可以在不同形状,姿势和外观的对象中传递操纵能力,这是一种植根于他们对不同实例之间语义对应关系的理解的能力。为了为机器人提供类似的高级理解,我们提出了Sparsedff,这是一种新颖的DFF,用于3D场景,利用大型2D视觉模型从稀疏的RGBD图像中提取语义特征,该域与固定设置的许多任务相关,尽管它与许多任务相关。sparsedff生成视图一致的3D DFF s,通过将图像特征映射到3D点云,从而有效地对灵活性操作进行了有效的灵感操作学习。Sparsedff的中心是一个特征改进网络,通过视图和特征连续性的点式缩写机制之间的对比损失进行了优化。这有助于最小化特征差异W.R.T.最终效应参数,桥接演示和目标操作。在现实世界中用灵巧的手验证,Sparsedff证明有效地有效地操纵刚性和可变形的对象,表明对象和场景变化之间具有显着的概括能力。

![arxiv:2407.21654v1 [cs.cv] 2024年7月31日](/simg/e\eea76ff78a5e1b25306a95443ed7ef0f1c6b852c.webp)