XiaoMi-AI文件搜索系统

World File Search System评论文章 - 机器学习中的对抗攻击

由于对抗性攻击,诸如机器学习之类的流派存在着相当大的威胁,其中包括故意用会改变决策区域的数据为系统提供。这些攻击致力于以模型在分类或预测中是错误的方式向机器学习模型展示不同的数据。研究领域仍然相对年轻,必须发展强大的科学研究身体,以消除当前知识的差距。本文根据Scopus数据库中发表的高度引用的文章和会议提供了对抗性攻击和防御措施的文献综述。通过对128个系统文章的分类和评估:80篇原始论文和48篇评论论文,直到2024年5月15日,本研究对不同领域的文献进行了分类和审查,例如图形神经网络,Iot系统的深度学习模型等。该评论对确定的指标,引文分析和这些研究的贡献提出了发现,同时暗示了该地区对对抗性鲁棒性和保护机制的进一步研究和发展。这项工作的确定目标是介绍对抗性攻击和防御的基本背景,并需要维持机器学习平台的适应性。在这种情况下,目标是为在各个行业的AI应用中建立高效和可持续的保护机制做出贡献

人工智能辅助决策中的战略对抗攻击会降低人类的信任和依赖

随着人工智能技术与人类决策过程的融合日益紧密,对人工智能模型的对抗性攻击成为比以往任何时候都更令人担忧的问题,因为它们可能会严重损害人类对人工智能模型的信任,降低人机协作的有效性。虽然已经提出了许多对抗性攻击方法来降低人工智能模型的性能,但人们很少关注这些攻击将如何影响与模型交互的人类决策者,以及如何战略性地部署对抗性攻击以最大限度地减少人类的信任和依赖。在本文中,通过一项以人为对象的实验,我们首先表明,在人工智能辅助决策中,攻击的时机在很大程度上影响了人类对人工智能的信任和依赖的降低程度——当攻击发生在人类高度自信的决策任务上时,这种降低尤为明显。基于这些见解,我们接下来提出了一个算法框架来推断人类决策者对人工智能模型的隐藏信任,并动态决定攻击者何时应该对模型发起攻击。我们的评估表明,按照所提出的方法,攻击者可以部署更有效的攻击,并获得比采用其他基线策略更高的效用。

dedim:使用扩散模型去识别

摘要:作为对面部识别系统中恶意身份验证的对策,使用了从SNS或类似的面部图像或基于对抗性示例的De-nisteriation方法获得的面部图像。然而,由于对抗示例直接使用面部识别模型的梯度信息,因此它高度依赖于该模型,并且对于未知识别模型而言,很难实现识别效果和图像质量。在这项研究中,我们提出了一种基于扩散模型的新型去识别方法,该方法通过对面部形状进行微小变化来对未知识别模型具有很高的概括性。使用LFW的实验表明,与使用对抗性示例的常规方法相比,该方法对未知模型具有更高的识别效果,并且图像质量更好。

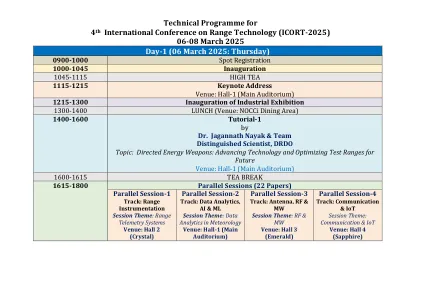

第1天(2025年3月6日

纸张ID:1571093441通过残留生成的对抗网络对异常Wi-Fi活动进行前进的对抗性检测:一种可靠的无线网络安全性1415-1430纸张ID的新方法

在机器学习中检测和减轻数据中毒攻击:加权平均方法

对抗性攻击,特别是数据中毒,可以通过将故意设计的数据插入训练集中来影响机器学习模型的行为。本研究提出了一种识别对机器学习模型的数据中毒攻击的方法,即加权平均分析(VWA)算法。该算法评估了输入特征的加权平均值,以检测任何可能是中毒努力迹象的违规行为。该方法发现可以通过添加所有加权平均值并将其与预测值进行比较来指示操纵的偏差。此外,它可以区分二进制和多类分类实例,从而修改其分析。实验结果表明,VWA算法可以准确地检测和减轻数据中毒攻击,并提高机器学习系统针对对抗性威胁的鲁棒性和安全性。

通过控制流证明确保联合学习

摘要 - 联邦学习(FL)作为一个分离的机器学习范式的出现,引入了新的Cybercurity挑战,尤其是威胁模型完整性和参与者隐私的对抗性攻击。本研究提出了一个受控制流(CFA)机制启发的创新安全框架,传统上用于网络安全,以确保软件执行完整性。通过在FL框架内集成数字签名和加密散布,我们对整个网络跨网络的模型更新的完整性进行了验证,从而有效地减轻了与模型中毒和对抗性干扰相关的风险。我们的方法是将CFA原理应用于FL的新颖性,可确保参与节点的贡献是真实且未受到损害的,从而在不损害计算效率或模型性能的情况下增强了系统的弹性。对基准数据集,MNIST和CIFAR-10的经验评估证明了我们的框架的有效性,在完整性验证和身份验证方面达到了100%的成功率,以及针对对抗性攻击的明显韧性。这些结果验证了提议的安全性增强和开放途径,以提供更安全,可靠和意识的分布式机器学习解决方案。我们的工作弥合了网络安全与分布式机器学习之间的关键差距,为Secure FL中的未来进步奠定了基础。索引术语 - 填充学习,网络安全,控制流证明,数字签名,哈希

迈向构建安全可信的人工智能代理和道路......

– 对抗性稳健性 – 分布外稳健性 • 幻觉 • 公平性 • 毒性 • 刻板印象 • 机器伦理 • 越狱护栏和安全/安保政策 • 协调目标:乐于助人、无害、诚实

备用:使用ZKPS的机密模型进行操作说明

解释被视为通过使其透明的方式来增强对机器学习(ML)模型的信任的一种方式。尽管最初是一种调试工具,但现在也被广泛提议证明基于ML的社会应用预测公平和敏感性(Langer等人)(Langer等人,2021; Smuha,2019年; K a astner等。,2021;冯·埃辛巴赫(Von Eschenbach),2021年;勒本,2023年; Karimi等。,2020年; Wachter等。,2017年; Liao&Varshney,2021年)和法规(解释权(Wikipedia con-trigutors,2025))。但是,如(Bordt等人,2022年),其中许多用例都在对抗性中是对抗性的,在这种情况下,参与方的利益不一致,并受到激励以操纵解释以实现其目的。例如,一家基于ML模型的预测拒绝向申请人贷款的银行有一个令人讨厌的人将无可争议的解释退还给申请人

通过对抗攻击和培训进行强大的深入强化学习:调查

深度加固学习(DRL)是一种在各种复杂环境中训练自主代理的方法。尽管在众所周知的环境中表现出色,但它仍然容易受到较小条件的变化,这引起了人们对其在现实世界应用中的可靠性的担忧。为了改善Usabil的影响,DRL必须表现出可信赖和稳健性。通过对环境动力学的良好适合对抗性攻击进行训练,通过训练代理人来训练代理商,将DRL鲁尔的鲁棒性转化为未知变化的鲁棒性。解决这个关键问题时,我们的工作对当代对抗攻击方法进行了深入分析,系统地对其进行了分类并比较其目标和操作机制。此分类提供了一个详细的见解,以了解对抗性攻击如何有效地评估DRL代理的弹性,从而为增强其稳健性铺平了道路。