机构名称:

¥ 2.0

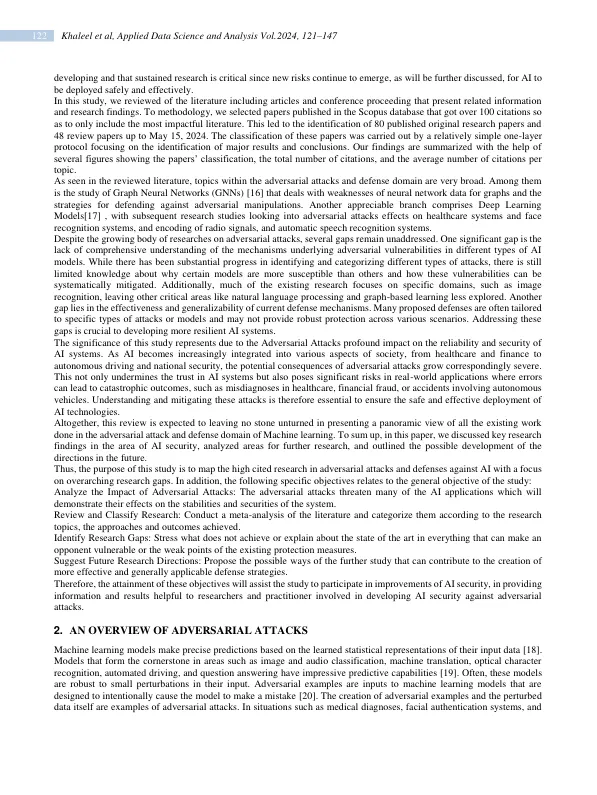

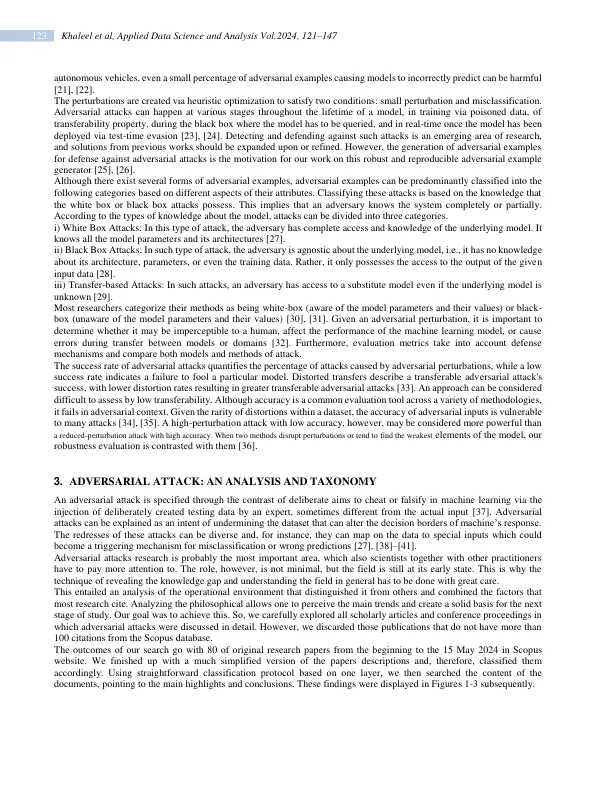

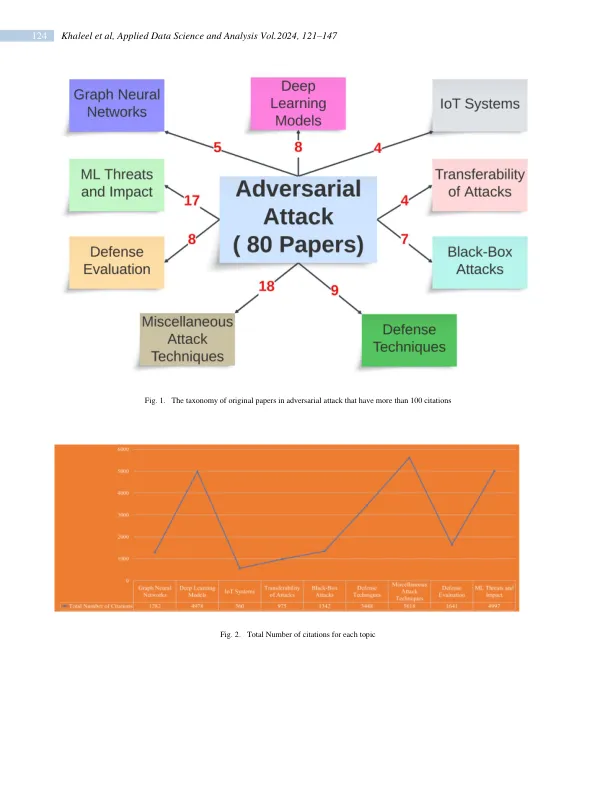

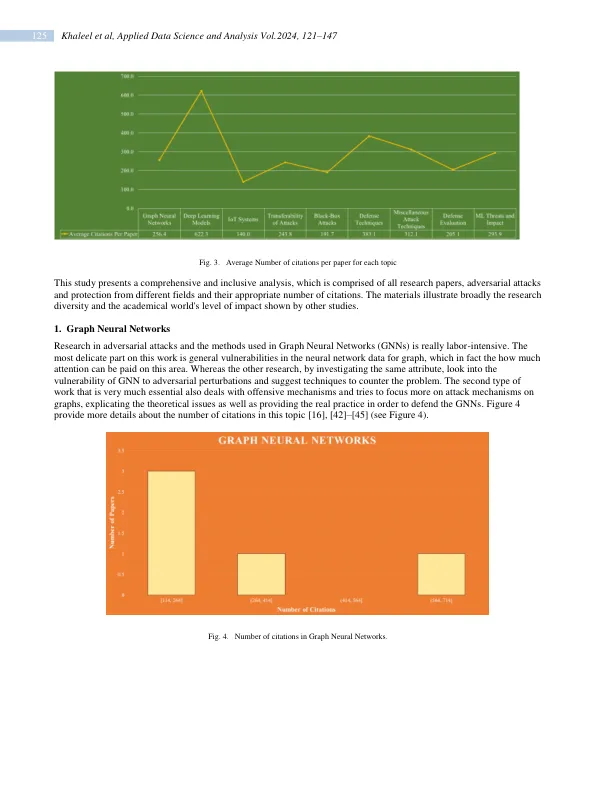

由于对抗性攻击,诸如机器学习之类的流派存在着相当大的威胁,其中包括故意用会改变决策区域的数据为系统提供。这些攻击致力于以模型在分类或预测中是错误的方式向机器学习模型展示不同的数据。研究领域仍然相对年轻,必须发展强大的科学研究身体,以消除当前知识的差距。本文根据Scopus数据库中发表的高度引用的文章和会议提供了对抗性攻击和防御措施的文献综述。通过对128个系统文章的分类和评估:80篇原始论文和48篇评论论文,直到2024年5月15日,本研究对不同领域的文献进行了分类和审查,例如图形神经网络,Iot系统的深度学习模型等。该评论对确定的指标,引文分析和这些研究的贡献提出了发现,同时暗示了该地区对对抗性鲁棒性和保护机制的进一步研究和发展。这项工作的确定目标是介绍对抗性攻击和防御的基本背景,并需要维持机器学习平台的适应性。在这种情况下,目标是为在各个行业的AI应用中建立高效和可持续的保护机制做出贡献

评论文章 - 机器学习中的对抗攻击

主要关键词