机构名称:

¥ 4.0

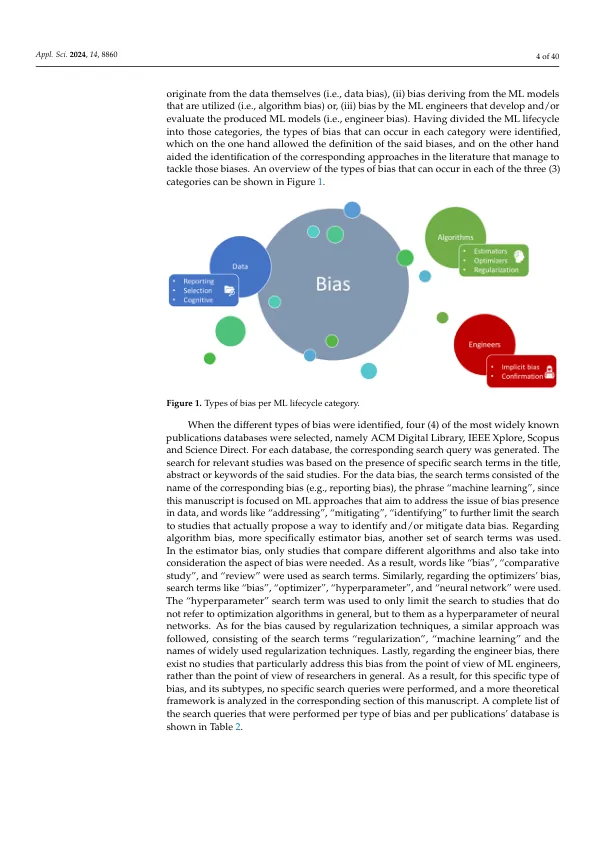

摘要:偏见可以定义为受到人或群体的倾向,从而促进不公平。在计算机科学中,偏见称为算法或人工智能(即AI),可以描述为在计算机系统中展示反复错误的趋势,从而导致“不公平”结果。“外部世界”和算法偏差的偏见是互连的,因为许多类型的算法偏见源自外部因素。在不同领域中识别出的各种不同类型的AI偏见突出了对上述AI偏见类型的分类的必要性,并提供了识别和减轻它们的方法的详细概述。存在的不同类型的算法偏差可以根据偏差的起源分为类别,因为偏见可以在机器学习(即ML)生命周期的不同阶段发生。本手稿是一项文献研究,提供了有关偏见的不同类别的详细调查以及已提出识别和减轻它们的相应方法的详细调查。这项研究不仅提供了可用的算法来识别和减轻偏见,而且还提高了ML工程师的经验知识,以基于其用例对本手稿中介绍的其他方法的相似性来识别偏见。根据这项研究的发现,可以观察到,在鉴定和缓解方面,文献中更好地涵盖了某些类型的AI偏见,而其他AI偏差则需要更多地研究。这项研究工作的总体贡献是为ML工程师以及有兴趣开发,评估和/或使用ML模型感兴趣的每个人都可以利用偏见的识别和缓解偏差的有用指南。

机器学习中的偏见:文学评论

主要关键词