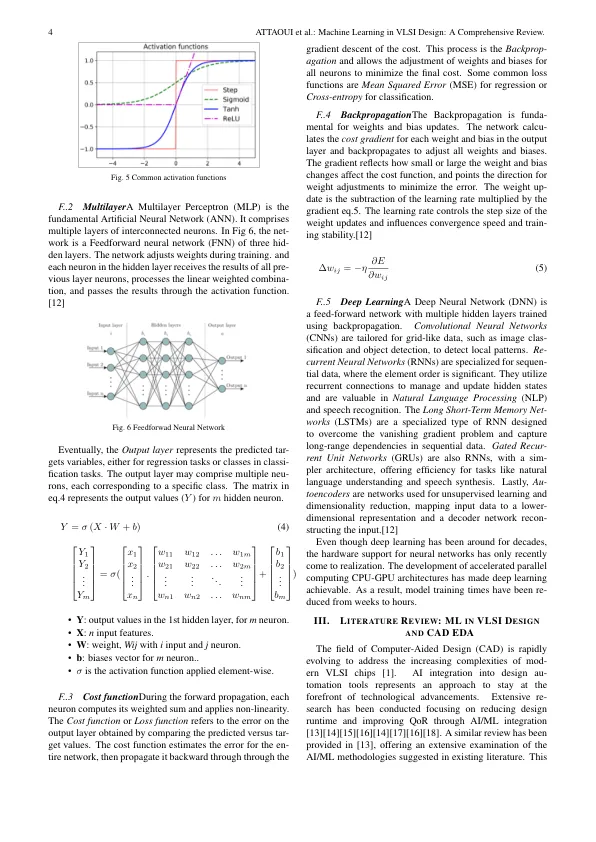

监督的学习算法从标记的数据集中学习,重点是调整模型的参数并创建一个推断功能,该功能将输入映射到具有最小化预测错误的输出。监督模型从一对输入向量和相应的目标值中学习。存在两种主要类型的监督学习,分类和回归。分类算法将输入向量分配给预定义的类别或类。分类是二进制分类(两个目标类别)或多类分类(多个类别)。重新研究算法的重点是预测连续数值。存在各种回归算法,每个回归算法都满足了不同的需求。线性回归(LR)推测特征与目标之间的线性关联。多项式恢复(PR)通过多个数字函数捕获非线性关系。决策树(DT)基于最重要的属性将数据集递归将数据集分为子集中,从而创建了导致平均预测的树结构。随机森林(RF)是一种合奏方法,它可以组合多个决策树以提高预测准确性。超树或极为随机的树是另一种合奏方法,它构建了具有随机特征分裂的决策树。支持向量回归器(SVR)旨在找到一个超平面,该超平面使预测误差最小化,同时允许公差范围。k-nearest邻居(KNN)是一种非参数算法,通过平均其k-nearealt邻居的值来预测tar-获取值。幼稚的贝叶斯回归剂(NBR)依赖于概率原则。梯度提升(GB)通过组合多个弱决策树模型并通过将每个树拟合到先前树的残余误差来构建模型来构建模型。列表仍然很广泛,存在尚未包括在内的其他方法和神经网络算法。[7] [8] [9] [3] [10] [6]一个模型在为看不见的数据提供准确的预测时表现出良好的概括能力。如果Inferred模型过于简单,并且预测训练集的价值不准确,则可能会涉及培训数据的拟合。另一方面,当培训数据不足时,我们有可能在模型对训练集产生良好的预先指示的情况下,但在面对新数据时会失败,然后该模型具有较低的概括能力。作为一种态度,至关重要的是要达到模型复杂性的平衡,并在图3中所示的拟合和过度合适之间找到一个平衡的位置。

VLSI设计中的机器学习:全面评论

主要关键词