机构名称:

¥ 3.0

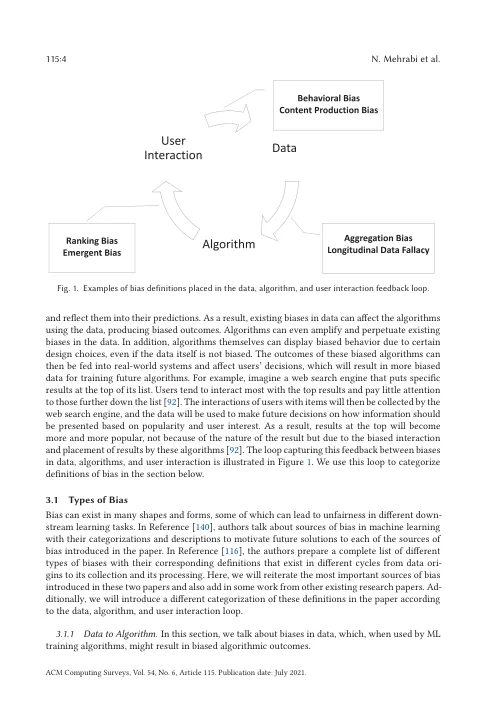

随着我们日常生活中人工智能(AI)系统和应用的广泛使用,对公平性的解释在设计和工程中的公平性上已经获得了重要的重要性。AI系统可在许多敏感环境中使用,以做出重要且改变生活的决定;因此,至关重要的是要确保这些决定不会反映对某些群体或人群的歧视行为。最近在传统的机器学习和深度学习中开发了一些工作,这些工作解决了不同子域中的此类挑战。随着这些系统的商业化,研究人员更加意识到这些应用程序可以包含并试图解决这些应用程序的偏见。在这项调查中,我们研究了以各种方式显示偏见的不同现实世界应用程序,并列出了可能影响AI应用程序的不同来源。然后,我们为机器学习研究人员所定义的公平性划分创建了一个分类法,以避免AI系统中的现有偏见。除此之外,我们还检查了AI中的不同领域和子域,展示了研究人员对最先进方法中不公平结果的观察到了什么以及他们试图解决这些问题的方式。仍然可以采取许多未来的方向和解决方案来减轻AI系统中的偏见问题。我们希望这项调查能够通过观察各自领域的现有工作来激励研究人员在不久的将来解决这些问题。

关于机器学习中偏见和公平性的调查

主要关键词