机构名称:

¥ 1.0

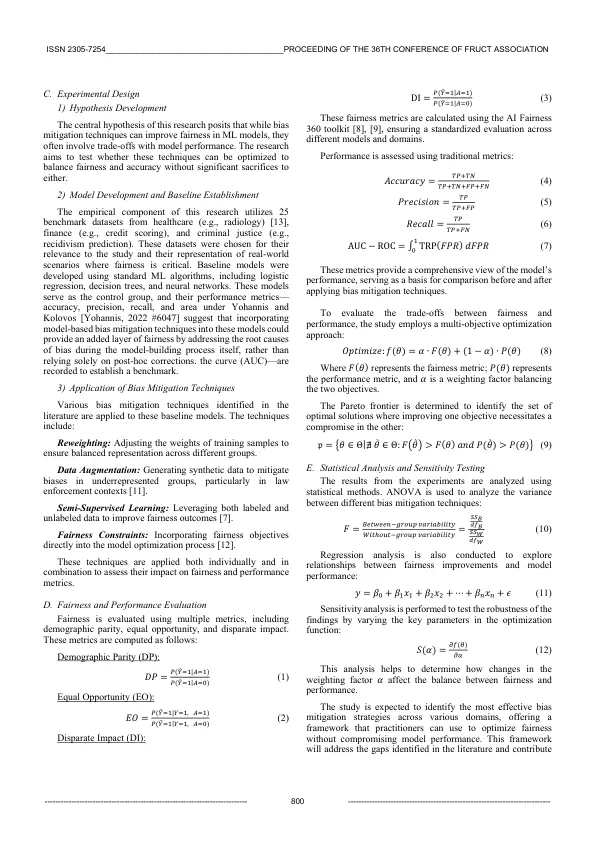

摘要 - 将人工智能(AI)的快速整合到诸如医疗保健,金融和刑事司法等关键领域已引起了重大的道德问题,尤其是围绕机器学习模型中的偏见和公平性。尽管它们有可能改善决策过程,但这些模型仍可以使现有的社会偏见永存甚至加剧。本研究旨在调查AI系统中缓解偏置的方法,重点是平衡公平和性能。对2018年至2023年之间发表的150篇研究文章进行了系统评价,并在25个基准数据集上进行了实验,以评估各种机器学习算法和缓解偏差的技术。结果表明,在模型培训期间,偏差降低了23%,九个公平度指标的平均提高了17%,尽管总体准确性最高为9%。该研究强调了公平与绩效之间的权衡,这表明创建既公平又有效的AI系统仍然是一个持续的挑战。这些发现强调了对解决偏差的自适应框架的需求,而不会显着损害模型性能。未来的研究应探讨特定于领域的适应和可扩展的解决方案,以在整个AI开发过程中整合公平性,以确保更公平的结果。

道德AI具有平衡偏见缓解和公平性的机器学习模型

主要关键词