机构名称:

¥ 1.0

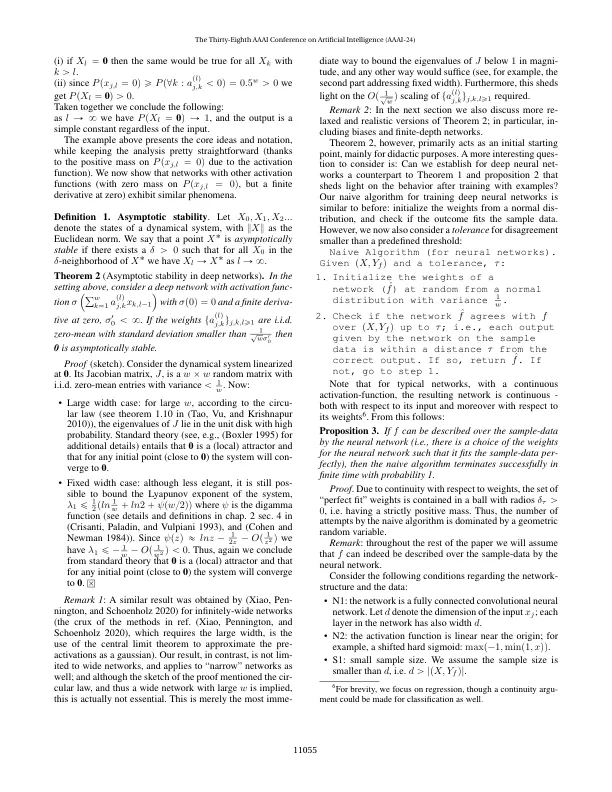

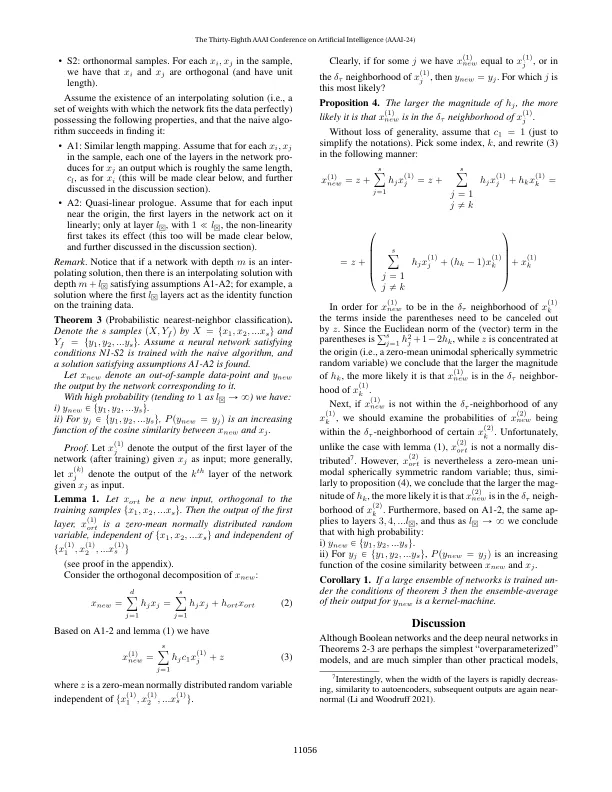

仍然缺乏对深网(和其他过度参数模型)令人惊讶的发生能力的彻底理论理解。在这里,我们证明了模拟性偏差是在过度参数化机器学习中不可忽视的主要现象。除了解释简单性偏见的结果外,我们还研究了它的来源:遵循具体的严格示例,我们认为(i)模拟偏见可以解释在过度参数化学习模型(例如神经网络)中的概括; (ii)正如我们的示例所示,简单性偏差和出色的概括是与优化器无关的,尽管优化器会影响培训,但它并不是简单性偏见的动力; (iii)在训练模型中的模拟偏差和随后的后代是普遍的,并且源于一个微妙的事实,即统一的随机构造的先验不是统一的统一性; (iv)在神经网络模型中,宽(和浅)网络中的偏见机器与深(和狭窄)网络中的偏置机制不同。

过度参数化机器学习中的简单偏见