XiaoMi-AI文件搜索系统

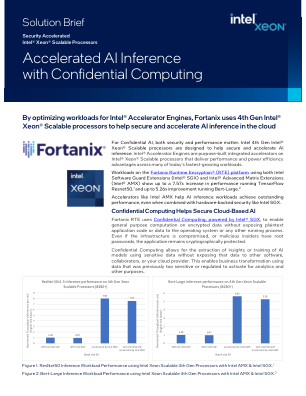

World File Search System通过机密计算加速 AI 推理

声明和免责声明 1. 在搭载英特尔 SGX 和英特尔 AMX 的第四代至强可扩展处理器上运行 TensorFlow ResNet50 推理工作负载时,性能提升高达 7.57 倍。请参阅下面的配置详细信息。 2. 在搭载英特尔 SGX 和英特尔 AMX 的第四代至强可扩展处理器上运行 Bert-Large 推理工作负载时,性能提升高达 5.26 倍。请参阅下面的配置详细信息。 3. 与上一代相比,在搭载英特尔 SGX 和英特尔 AMX 的第四代英特尔至强可扩展处理器上以 INT8 精度运行 Bert-Large 推理工作负载时,性能提升高达 4.61 倍。请参阅下面的配置详细信息。 4. 在配备英特尔 SGX 和英特尔 AMX 而非 FP32 的第四代英特尔至强可扩展处理器上运行 TensorFlow ResNet50 推理工作负载时,INT8 精度下的性能提升高达 8.02 倍,BF16 精度下的性能提升高达 4.30 倍。请参阅下面的配置详细信息。5. 在配备英特尔 SGX 和英特尔 AMX 而非 FP32 的第四代英特尔至强可扩展处理器上运行 Bert-Large 推理工作负载时,INT8 精度下的性能提升高达 5.46 倍,BF16 精度下的性能提升高达 4.17 倍。请参阅下面的配置详细信息。配置详细信息测试 1:截至 2022 年 11 月 21 日,英特尔进行测试。1 节点、2x 英特尔® 至强® 铂金 8380 CPU @ 2.30GHz、40 个内核、超线程关闭、睿频开启、总内存 512 GB(16x32GB DDR4 3200 MT/s [运行速度为 3200 MT/s])、BIOS 版本 SE5C6200.86B.0022.D64.2105220049、ucode 版本 0xd000375、操作系统版本 Ubuntu 22.04.1 LTS、内核版本 6.0.6-060006-generic、工作负载/基准使用 Fortanix 在安全区域内进行深度学习推理、框架版本 TensorFlow 2.11、模型名称和版本ResNet50v1.5/Bert-Large TEST-2:截至 2022 年 11 月 21 日,英特尔进行测试。1 节点、2x 英特尔® 至强® 铂金 8480+ CPU @ 2.0GHz、56 核、超线程关闭、睿频开启、总内存 512 GB(16x32GB DDR5 4800 MT/s [运行于 4800 MT/s])、BIOS 版本 3A05、ucode 版本 0x2b000070、操作系统版本 Ubuntu 22.04.1 LTS、内核版本 6.0.6-060006-generic、工作负载/基准使用 Fortanix 在安全区域中进行深度学习推理、框架版本 TensorFlow 2.11、模型名称和版本 ResNet50v1.5/Bert-Large 性能因使用情况、配置和其他因素而异。欲了解更多信息,请访问性能指数网站。性能结果基于截至配置中所示日期的测试,可能无法反映所有公开可用的更新。有关配置详细信息,请参阅备份。没有任何产品或组件能够绝对安全。您的成本和结果可能会有所不同。英特尔技术可能需要启用硬件、软件或激活服务。© 英特尔公司。英特尔、英特尔徽标和其他英特尔标志是英特尔公司或其子公司的商标。其他名称和品牌可能是其他财产。

样本书-Intel®Trust域扩展(Intel®TDX)

VMware ESXI*的英特尔®数据中心驱动程序是SR-IOV驱动程序,它可以通过与许多同时运行的虚拟机共享其资源来使用Intel®DataCenter GPU Flex系列用于虚拟台式机,AI或其他工作负载。主要工作负载是数据中心和企业环境中VMware Horizon VDI解决方案的媒体加速度。由于此类解决方案的可扩展性,系统管理员需要仔细调整和监视GPU,以最大程度地为尽可能多的用户提供处理功能,同时保持可接受的用户体验。尽管可以在ESXI主机级别进行调试目的完成,但还需要在部署级别上支持它。现在,对于VMware Vcenter Server插件的Intel Device Manager,这是可能的。

利用AI数据中心的需求

该博士学位项目旨在探讨如何管理AI数据中心和LLM工作负载,以增强电力网格的功能,支持需求响应计划并促进可持续的基础设施发展。AI数据中心传统上被视为能源消费者,而不是引起电网稳定性的贡献者。但是,LLM工作负载调度的固有灵活性(特定于非紧急和计算密集的任务)为响应实时网格条件而移动这些负载的机会。正确整合了这些中心,这些中心不仅可以在高峰需求期间减少网格应力,而且还可以在低需求期间吸收过量的可再生能源,从而最大程度地利用了绿色能源的使用,同时还减少了自己的能源费用。

打造人工智能芯片的挑战和行业前景

• 第 1 部分:背景 - AI 应用、工作负载和系统 • 第 2 部分:构建数据中心 AI 芯片的挑战 • 第 3 部分:行业视角 - 软件 • 第 4 部分:行业视角 - 架构和硬件

利用英特尔® AMX 和英特尔® TME 解决方案设计简介加速 AI 推理工作负载并提高 Azure Stack HCI 上的安全性

处理器 QS 预生产版(40 核,2.0 GHz)、1 个英特尔® 服务器主板(QuantaGrid D54Q-2U)、总内存:512 GB(16x 32 GB 4800 MHz DDR5 DIMM)、英特尔® 超线程技术 = 开启、英特尔® 睿频加速技术 = 开启、BIOS = SE5C741.86B.01.01.0002.2212220608、微码 = 0x2b0001b0 存储(启动):1 个 Solidigm DC S4610(960 GB)、存储:6 个 Solidigm D7-P5510 系列(3.84 TB)、网络设备:1 个 25 GbE 英特尔® 以太网网络适配器 E810-XXV-4 @ 25 GbE、1 个 10 GbE 英特尔® 以太网融合网络适配器 X550-T2 @ 1 GbE、操作系统/软件:带有 Ubuntu Server 2022 的 Microsoft Azure Stack HCI 版本 20385。

奇点:人工智能工作负载的行星级、抢占式和弹性调度

通过提高深度学习工作负载的利用率来降低成本是云提供商的关键杠杆。我们推出了 Singularity,这是微软的全球分布式调度服务,可高效可靠地执行深度学习训练和推理工作负载。Singularity 的核心是一种新颖的工作负载感知调度程序,它可以透明地抢占和弹性扩展深度学习工作负载,以提高利用率,而不会影响它们在全球 AI 加速器(如 GPU、FPGA)中的正确性或性能。默认情况下,Singularity 中的所有作业都是可抢占、可迁移和动态调整大小(弹性)的:实时作业可以动态且透明地 (a) 被抢占并迁移到不同的节点、集群、数据中心或区域集,并从抢占点准确恢复执行,以及 (b) 在给定类型的不同加速器集上调整大小(即弹性地扩大/缩小)。我们的机制是透明的,因为它们不需要用户对其代码进行任何更改,也不需要使用任何可能限制灵活性的自定义库。此外,我们的方法显著提高了深度学习工作负载的可靠性。我们表明,使用 Singularity 可以获得效率和可靠性的提升,而对稳态性能的影响可以忽略不计。最后,我们的设计方法与 DNN 架构无关,并且可以处理各种并行策略(例如数据/管道/模型并行)。

网络性能分析的正式方法

对网络性能的抽象准确和彻底的分析具有挑战性。网络仿真和仿真只能涵盖网络可以体验到的连续发展的工作负载集的子集,为未探索的角案例和错误留出空间,这些案例和错误可能会导致实时流量的次优性能。排队理论和网络计算的技术可以在性能指标上提供严格的界限,但通常需要网络组件的行为,而流量的到达模式则可以通过简洁且行为良好的数学功能近似。因此,它们不立即适用于新兴工作负载以及用于处理它们的新算法和协议。我们探讨了一种不同的方法:使用正式方法来分析网络性能。我们表明,可以准确地对网络组件及其逻辑上的队列进行建模,并使用程序合成中的技术来自动生成简洁的可解释的工作负载,作为有关性能指标的查询的答案。我们的方法在分析网络性能的现有工具的空间中提供了一个新的观点:它比模拟和典范更详尽,并且可以轻松地应用于一阶逻辑中可表达的算法和协议。我们通过分析数据包调度算法和小叶子网络并产生可能导致吞吐量,公平性,饥饿和延迟问题来证明方法的有效性。

XAA:加速作为使生产高的服务...

HPC和Cloud已独立发展,专门将其创新成绩效或生产力。加速作为服务(XAAS)是一种配方,可以通过共享的执行平台授权这两个字段,该平台可提供对计算资源的透明访问,而不论基础云或HPC服务提供商如何。Bridg-HPC和云的进步,XAA提出了建立在可履行容器的容器上的统一档案。我们的融合模型集中在低空,高性能的通知和计算上,针对从气候模拟到机器学习的资源密集型工作负载。XAA提升功能-AS-A-Service(FAAS)的重新分配模型,使用户可以从无服务器的灵活性和有效的资源利用中受益,同时支持HPC的长期运行和性能敏感的工作负载。