XiaoMi-AI文件搜索系统

World File Search System测量自我中心定位

摘要 个体对直线前进的感知 (即自我中心定位) 可能会在患有获得性脑损伤 (ABI) 的患者中发生转变。利用独特的光学系统,我们设计了一种小型便携式设备,供临床使用。数据来自 14 名视力正常的成年人,年龄从 23 岁到 53 岁不等,以及 10 名年龄从 37 岁到 82 岁不等的获得性脑损伤成年人。组平均值以及个体受试者的平均二维自我中心定位值与使用更大、更复杂的实验室设备建立的规范数据一致。关于 10 名获得性脑损伤成年人的初步数据显示了它的临床诊断和治疗应用。事实证明,这种新设备与文献中描述的较大外壳一样精确、准确、有效和可靠。此外,该设备的紧凑性有助于我们诊所对后天性脑损伤患者进行持续测试。

基于能量的自我中心视频中的无监督凝视预测

摘要:随着沉浸式计算设备的出现,自我中心感知迅速发展。人类注视预测是分析自我中心视频的一个重要问题,主要通过基于显着性的建模或高度监督的学习来解决。我们定量分析了监督深度学习模型在看不见的域外数据的自我中心注视预测任务中的泛化能力。我们发现它们的性能高度依赖于训练数据,并且仅限于训练注释中指定的域。在这项工作中,我们解决了在不使用任何训练数据的情况下联合预测人类注视点和自我中心视频时间分割的问题。我们引入了一个无监督的计算模型,该模型汲取了事件感知的认知心理学模型的灵感。我们使用 Grenander 的模式理论形式来表示时空特征,并将惊讶建模为预测注视点的机制。对两个公开数据集(GTEA 和 GTEA+ 数据集)的广泛评估表明,所提出的模型可以显著超越所有无监督基线和一些监督凝视预测基线。最后,我们表明该模型还可以对以自我为中心的视频进行时间分割,其性能可与更复杂、完全监督的深度学习基线相媲美。

开放世界3D段用于自我中心感知

摘要。在本文中,我们提出了Egolifter,这是一个新型的系统,可以自动将自我中心传感器捕获的场景分为单个3D对象的完整分解。该系统是针对以自然的(非扫描)运动捕获的数百个obs的现场设计的特定设计的。eGolifter采用3D高斯人作为3D场景和对象的基本表示形式,并使用段中的任何模型(SAM)的细分掩码作为薄弱的监督,以学习对对象实例的灵活定义,对对象实例的定义,没有任何特定的对象分类法。为了处理以自我为中心的视频中动态对象的挑战,我们设计了一个瞬态预测模块,该模块学会过滤3D重新构造中的动态对象。结果是一条全自动管道,能够将3D对象实例重建为3D高斯人的集合,共同构建了整个场景。我们在ARIA Digital Twin数据集上创建了一个新的基准测试,该基准在自然egipentric输入中定量地证明了其在开放世界3D分割中的最先进。我们在各种以自我为中心的活动数据集上运行Egolifter,该数据集显示了该方法在大规模上以3D为中心感知的希望。请访问https://egolifter.github.io/的项目页面。

用于免提机器人轮椅导航的自我中心计算机视觉

摘要 在本文中,我们介绍了一种导航机器人轮椅的方法,该方法为用户提供了多层次的自主性和导航能力,以满足他们的个人需求和偏好。我们主要关注三个方面:(i)以自我为中心的基于计算机视觉的运动控制,为手部使用受损的轮椅使用者提供自然的人机界面;(ii)使用户无需使用手即可启动到某个位置、物体或人的自主导航的技术;(iii)一个框架,该框架根据用户通常是主观的标准和偏好来学习导航轮椅。这些贡献在用户研究中进行了定性和定量评估,几名受试者证明了它们的有效性。这些研究都是针对健康受试者进行的,但它们仍然表明可以启动对所提出技术的临床试验。

实时3D语义场景感知具有双眼视觉的自我中心机器人

摘要 - 在室内移动的同时,感知具有多个对象的三维(3D)场景对于基于视觉的移动配件至关重要,尤其是对于增强其操纵任务的尤其是。在这项工作中,我们为具有双眼视觉的自我中心机器人提供了实例分割,特征匹配和点集注册的端到端管道,并通过拟议的管道展示了机器人的抓地力。首先,我们为单视图3D语义场景分割设计了一个基于RGB图像的分割方法,并利用2D数据集中的常见对象类将3D点封装在对象实例的点云中,通过相应的深度映射。接下来,根据先前步骤中匹配的RGB图像中感兴趣的对象之间的匹配关键,提取了两个连续的点云的3D对应关系。此外,要意识到3D特征分布的空间变化,我们还根据使用内核密度估计(KDE)的估计分布(KDE)来称量每个3D点对,随后可以使稳健性具有较小的中心范围,同时求解点云之间的刚性转换。最后,我们在7-DOF双臂Baxter机器人上测试了我们提出的管道,并使用安装的Intel Realsense D435i RGB-D相机测试了我们的管道。结果表明我们的机器人可以在移动时分割感兴趣的对象,注册多个视图,并掌握目标对象。源代码可在https://github.com/mkhangg/semantic Scene感知上获得。

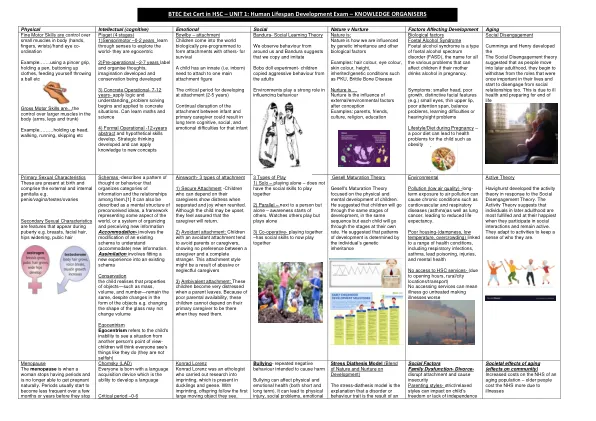

第一单元:人类生命周期发展考试

图式 - 描述一种思维或行为模式,用于组织信息类别及其之间的关系。[1] 它也可以被描述为先入为主的观念的心理结构、代表世界某些方面的框架或组织和感知新信息的系统 适应 - 涉及修改现有图式以理解(适应)新信息。 同化涉及将新体验融入现有图式 保存 孩子意识到物体的属性 - 例如质量、体积和数量 - 保持不变,尽管物体的形式发生了变化,例如改变玻璃的形状可能不会改变体积 自我中心主义 自我中心主义是指孩子无法从别人的角度看待情况 - 孩子会认为每个人的看法都和他们一样(他们并不自私)

启发,但不模仿:人工智能与人类智能之间的对话

顾:我认为智能不只是拥有尽可能多的知识,而是从知识中学习普遍的规则,并运用到新任务中去。在神经科学中,有一个很好的例子,就是爱德华·托尔曼在1948年提出的“认知地图”。这个概念最早是在观察老鼠在迷宫中漫游时的行为时提出的。在这种空间导航任务中,老鼠首先将一系列空间和时间事件作为自我中心坐标存储起来,形成“情景记忆”,然后以认知地图的形式进一步转化为更抽象的“语义记忆”。基于自我中心地图,老鼠和其他动物可以利用结构化知识在新环境中导航,或者在迷宫中某些路径被阻塞时规划新路线。现在,我们知道认知地图不仅是空间导航的地图,也是抽象导航的地图,例如通过社交或价值空间。在最近的一篇《细胞》文章中,科学家发现猴子使用相同的大脑区域(包括海马体)来穿越空间,无论是物理空间还是抽象空间。这些大脑区域负责抽象一般规律并形成可以转移以解决不同问题的真实知识。这就是人类和其他动物拥有元学习或学会学习的能力的方式,这实际上是智力的关键,特别是使我们能够掌握多任务处理的一般智力。

思维和年龄相关的自我为中心的理论

加入他们:心理理论(汤姆)是一个出色的,狭窄的身体,几种认知au fbau t也是如此。它处于具有声称范式的实验室情况下。通常不再取决于其他原因。步行年龄相关的问题,例如HERZ-KREISLAU疾病,查看,听到并发展并发展特殊的Hirner病和Vask Lares以及新的Rodgeggenerative痴呆症(例如,与额叶por虫相关的变性),很难找到对困难的社交问题的合适答案。也定期训练,而退休年龄的“社会处置NG”通常是这种情况;为此,资助与年龄相关的自我中心(AAE)。

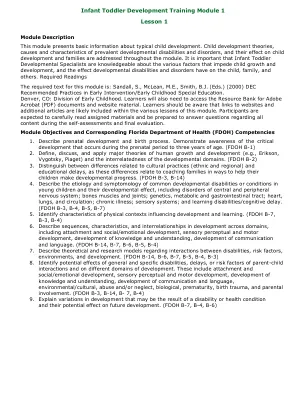

婴儿幼儿发展培训模块1第1课

•定义儿童发展。•定义非典型发展。•确定每个阶段中发生的胎儿发育的一个特征(头三个月,孕期,三个月)•描述儿童发育的每个主要领域:运动/身体,认知,社交/情感,沟通/语言以及自助/自适应。•描述儿童发育的典型(正常)序列与主要领域有关。•区分儿童发育的定性和定量差异。•解释自我中心主义及其对婴儿期社会关系的影响。•描述从出生到3岁的儿童身体发育的趋势。•描述从出生到3岁的思维如何变化。•解释为什么从文化相关的角度看儿童成长很重要。

年轻婴儿的视觉输入中的边缘模拟性偏差

哺乳动物视觉皮层中稀疏边缘编码的发展取决于早期的视觉体验。在人类中,有多种指标表明,早期视觉体验的统计数据具有可能支持这些发展的独特属性。但是,没有直接衡量婴儿日常生活实验的边缘统计数据。使用头部安装的摄像头捕获家庭中的年轻婴儿和成年人的自我中心图像,我们发现婴儿图像相对于成年人具有独特的边缘统计数据。对于婴儿,稀疏边缘图案的场景(速度边缘和少量方向)均为统治。这些发现暗示了在日常生活规模上的早期投入,这可能是出生后早期特定的,并提供了对人类视力基础发展期间视觉体验的质量,数量和时机的见解。