机构名称:

¥ 1.0

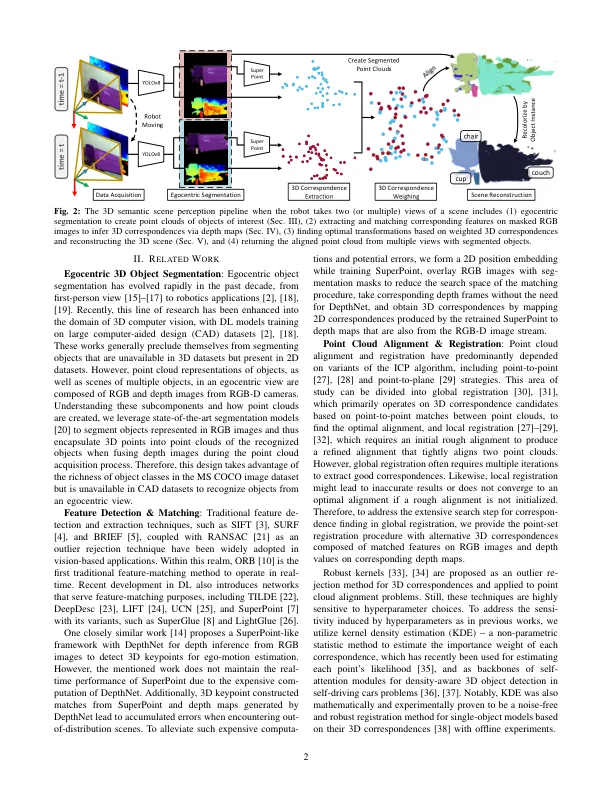

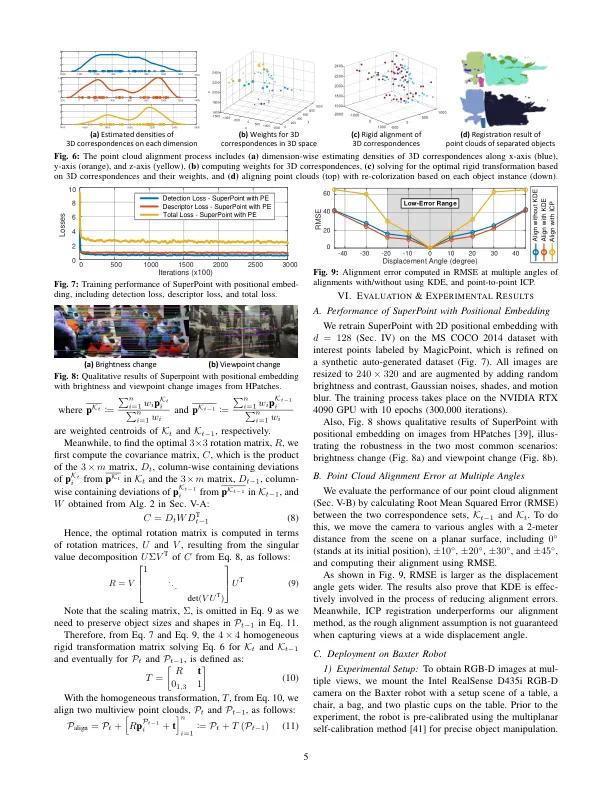

摘要 - 在室内移动的同时,感知具有多个对象的三维(3D)场景对于基于视觉的移动配件至关重要,尤其是对于增强其操纵任务的尤其是。在这项工作中,我们为具有双眼视觉的自我中心机器人提供了实例分割,特征匹配和点集注册的端到端管道,并通过拟议的管道展示了机器人的抓地力。首先,我们为单视图3D语义场景分割设计了一个基于RGB图像的分割方法,并利用2D数据集中的常见对象类将3D点封装在对象实例的点云中,通过相应的深度映射。接下来,根据先前步骤中匹配的RGB图像中感兴趣的对象之间的匹配关键,提取了两个连续的点云的3D对应关系。此外,要意识到3D特征分布的空间变化,我们还根据使用内核密度估计(KDE)的估计分布(KDE)来称量每个3D点对,随后可以使稳健性具有较小的中心范围,同时求解点云之间的刚性转换。最后,我们在7-DOF双臂Baxter机器人上测试了我们提出的管道,并使用安装的Intel Realsense D435i RGB-D相机测试了我们的管道。结果表明我们的机器人可以在移动时分割感兴趣的对象,注册多个视图,并掌握目标对象。源代码可在https://github.com/mkhangg/semantic Scene感知上获得。

实时3D语义场景感知具有双眼视觉的自我中心机器人

主要关键词

![自我维护[网络]系统:数据中心机器人技术的兴起!](/simg/a/a74ab1a85a20373b202d691350e9cb8b98180239.webp)