XiaoMi-AI文件搜索系统

World File Search System罗技负责任的人工智能原则

虽然罗技的 RAI 原则指导我们对 AI 的使用和部署,但我们的客户经常使用我们的软件硬件来访问第三方提供的 AI 工具和解决方案。在许多情况下,我们无法了解或控制客户使用或访问我们产品中的第三方工具的方式,并且在某些情况下,这种使用可能不符合罗技的原则。当我们与其他公司直接合作时,我们会努力以符合我们的 RAI 原则的方式整合我们的软件硬件。

负责任的人工智能:审议指南

在这一领域,还有很多工作要做。首先,我们应该反思如何实施普遍的道德原则,确保它们能够应用于每个具体活动领域(教育、科学、信息、健康等),并将反思得出的建议付诸实践。其次,必须让更多公民参与制定负责任地使用人工智能和海量数据的指导方针,并收集他们的知情意见。事实上,人工智能的部署影响到我们所有人,并引发了伦理和政治问题,这些问题应该成为公众审议的主题。最后,必须巩固公民的数字素养水平,这意味着要告知和帮助公民更好地了解人工智能发展中涉及的问责制问题,并参与有关人工智能部署原则和标准的公开审议。

负责任的人工智能的软件工程方法

为了确保负责任的人工智能 (AI) 应用工程,我们需要确保人工智能系统的开发考虑到对个人和社会的影响。通过预测设计选择的后果,通过让所有利益相关者参与并采取适当行动来反思要解决的问题,以确保开放性和系统的社会、法律和道德可接受性。本研究旨在开发一个工程过程模型,通过该模型可以在整个人工智能系统的软件开发生命周期中解决道德问题。本博士研究中设计的设计方法框架将通过提供明确的价值观分析和解释机制、道德价值观的正式表示、利益相关者参与处理道德审议的机制以及为治理和合规机制提供支持,支持将系统目标与关键道德价值观保持一致。

负责任的人工智能执行摘要

生命最后阶段的土著法律问题(即将于 2022 年出版) 欧洲和加拿大人工智能监管比较(2021 年 11 月) 生命最后阶段的法律问题(2021 年 10 月) 监管人工智能:关键问题和选择(2021 年 4 月) 美国刑事司法中人工智能和算法的兴衰:加拿大的经验教训(2020 年 10 月) 互联网时代的诽谤法(2020 年 3 月) 集体诉讼的目标、经验和改革(2019 年 7 月) 法律能力、决策和监护权(2017 年 3 月) 小型遗产的简化程序(2015 年 8 月) 联邦 RDSP 的能力和法律代表(2014 年 6 月) 林业工人工资留置权法案审查(2013 年 9 月) 增加获得家庭司法的机会(2013 年 2 月) 弱势工人和不稳定工作(2012 年 12 月) 残疾人法律框架(2012 年 9 月) 反对暴力侵害妇女的教学框架(2012 年 8 月) 老年人法律框架(2012 年 4 月) 省级违法行为法的现代化(2011 年 8 月) 安大略省商业公司法下的连带责任(2011 年 2 月) 婚姻破裂后的养老金分配(2008 年 12 月) 兑现政府支票的费用(2008 年 11 月)

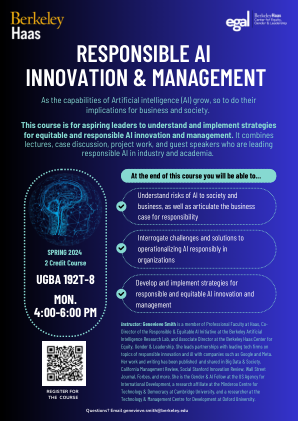

负责任的人工智能创新与管理

讲师:Genevieve Smith 是哈斯商学院专业教员、伯克利人工智能研究实验室负责任和公平人工智能计划联合主任以及伯克利哈斯公平、性别和领导力中心副主任。她领导与谷歌和 Meta 等公司就负责任创新和人工智能主题与领先科技公司建立合作伙伴关系。她的作品和文章已在《大数据与社会》、《加州管理评论》、《社会斯坦福创新评论》、《华尔街日报》、《福布斯》等杂志上发表和分享。她是美国国际开发署的性别与人工智能研究员、剑桥大学 Minderoo 技术与民主中心的研究员以及牛津大学技术与管理发展中心的研究员。

ACRO 负责任的 AI 原则

ACRO 是一个行业协会,代表临床研究组织和技术公司,他们有着共同的使命:推进临床研究,为有需要的患者提供新药。ACRO 成员公司采用 AI 技术,因为它们有潜力加速医学进步。同时,他们认识到,如果不负责任地开发和使用这些技术,可能会造成潜在危害。ACRO 认为,应遵循以下原则来指导可能部署在整个药物开发生命周期中的 AI 工具的开发和使用:

建立负责任的人工智能数据来源

数据出处是描述数据来源和处理的记录,它为基于人工智能 (AI) 的系统在指导人类决策方面发挥的日益重要的作用带来了新的希望。为了避免充满偏见的人工智能系统可能导致的灾难性后果,负责任的人工智能建立在四个重要特征之上:公平、可问责、透明和可解释性。为了促进对支持负责任人工智能的数据出处的进一步研究,本研究概述了现有的偏见,并讨论了可能的数据出处实施方法以减轻这些偏见。我们首先回顾了源于数据来源和预处理的偏见。然后,我们讨论了当前的实践状态、它所带来的挑战以及相应的解决建议。我们提出了一个总结,重点介绍了我们的建议如何帮助建立数据来源,从而减轻源于数据来源和预处理的偏见,以实现负责任的基于人工智能的系统。最后,我们提出了一个研究议程,建议进一步的研究途径。

思科负责任的人工智能框架

为了实施这些原则,我们制定了负责任的 AI 框架,该框架可应用于思科对 AI 的开发、部署和/或使用,无论是为我们的客户和合作伙伴开发产品或模型,集成和构建第三方模型以提供独特的产品,还是为我们自己的内部运营提供 AI 工具或服务。在实践中,我们努力将这些原则付诸实践,将安全设计、隐私设计和人权设计结合起来,以发现和降低风险,从而提供负责任且值得信赖的 AI。