XiaoMi-AI文件搜索系统

World File Search System一种新的基于马尔可夫决策过程的行为预测...

摘要 为保证飞机正常、稳定飞行,飞机上采用了多种传感器及相应的仪表系统来监测/控制当前的飞行状态,其得到的数据在保证飞行安全的同时也给飞行员带来了很大的负担。鉴于此,飞机座舱自动化辅助系统已成为当今的研究热点。本文基于自动化辅助系统启动后,通过飞行操作的不同阶段,可以预测飞行员未来的操作行为,从而根据飞行员的操作习惯为其提供辅助。通过对飞行员操作行为及飞行过程任务要求的分析与建模,建立了MDP(Markov Decision Process,马尔可夫决策过程)模型,并采用价值迭代算法寻找最优预测序列,最后通过飞行操作仿真实验验证了算法的可操作性。为飞行员操作的安全性和驾驶舱自适应自动化辅助系统的侵入性提供了新的解决方案。

确定解决马尔可夫决策过程的有效方法

我们在这里考虑马尔可夫决策过程(MDPS),总体知识是已知的过渡和奖励功能。主要有两种有效的方法,可以使用基于模型的方法来精确求解MDP:动态编程或线性程序,如[11]中所述。确定解决MDP问题的最有效方法一直是文献研究的主题。有关全面的审查,请参阅[1]以及[11,9]。根据[11],有人认为,基于价值的算法(例如价值迭代(VI)及其变体)并不像基于政策的方法那样实用,因此建议避免使用。另一方面,对基于策略的方法进行了比较下注政策迭代(PI)和政策迭代(PIM)尚不清楚,尽管后者似乎更有效[11]。早期的发现表明,线性编程方法不适合解决此类问题,这主要是由于求解器的速度慢[9]。尽管如此,文献中的比较研究有限,截至2007年,这个问题仍未解决[10]。随着线性编程求解器(例如Gurobi或cplex)的性能不断提高,以及并行化可能性的进步,对求解方法的定期重新评估变得相关。因此,在[1]的研究中,对线性编程和政策迭代的性能进行了比较分析,是对特定的马尔可夫决策过程(MDP)模型进行的,重点介绍了预期的总奖励标准。非零条目的1%。所考虑的MDP的特征是较大的状态空间(基数至少为2000),并且表现出各种动作选择(范围为2至500)。值得注意的是,所有过渡矩阵都高度稀疏,仅包含1%和0。先前的研究采用内点方法来解决线性程序。他们认为线性编程(LP)优于策略迭代(PI),并且对于特定模型而言,这显着。必须注意,[1]检查的模型类别在文献中很普遍,尤其是在给定状态下可能的转移数量的网络问题中。尽管如此,该研究仍具有一定的局限性。首先,即使这些方法可能会超过速度上的标准PI,但它并未考虑修改策略迭代及其变体。其次,研究中采用的LP解决方法仅提供政策而不是政策和价值观,就像动态编程一样。最后,其结论对更稀疏或其他操作标准的更广泛案例的概括性仍然不确定。这项工作的目的是找出线性编程在更一般的情况下是否仍然是一种有效的工具,并且在哪些条件(状态空间和行动空间维度,稀疏性)下找到使用动态编程仍然有效。

使用马尔可夫链对船网络安全进行建模

摘要信息在经济中的作用,尤其是在运输中,伴随着网络威胁的增长。国际海事组织已经开发并采用了许多基础网络安全文件,这些文件定义了船上网络安全管理的要求。这些文件迫使海上公司的管理,以确保正确考虑网络风险并在安全管理系统中应用保护方法。对于海事公司和船只而言,相关统一规则的制定和建立是一项紧迫的任务。确保信息安全的最有希望的方向当然是使用数学模型。这样的模型描述了违反网络空间和保护系统的相互作用的过程,该过程应考虑到船上可能的网络攻击,并确保尽可能多地保存和不可能。分析网络空间中发生的流程数学模型的研究领域的研究表明,首先,这是一个真正相关的研究方向,其次,目前有许多不同的理论构成了建模的基础。这项工作的作者为船上网络安全管理系统的数学建模提出了一种新方法,即马尔可夫链理论的使用,因为在船上的网络攻击可以在任何随机的时刻发生,而且此事件并不总是取决于发生在某个时候的网络攻击。因此,使用数学建模方法构建了船上网络安全管理系统作为企业安全管理系统子系统的模型。诸如船舶的网络安全状态,国家之间的概率关系,根据国家对行动的监管。网络安全管理系统的数学模型基于离散的马尔可夫进程的模型,其中马尔可夫链的挖掘物的顶点是船舶的网络安全状态。使用专家方法研究了船体网络安全系统状态之间的连接。根据船舶的网络安全状况的示例说明了开发的模型。在距离“船舶计算机系统和网络的网络安全”中,在Kherson海事学院的教育过程中实施了船体网络安全系统的考虑方法和技术。

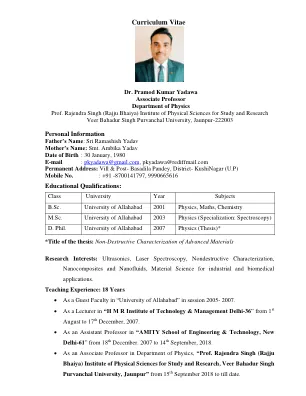

博士普拉莫德·库马尔·亚达夫

Veer Bahadur Singh Purvanchal 大学,Jaunpur-222003 个人信息 父亲姓名:Sri Ramashish Yadav 母亲姓名:Smt. Ambika Yadav 出生日期:1980 年 1 月 30 日 电子邮件:pkyadawa@gmail.com、pkyadawa@rediffmail.com 永久地址:Vill & Post- Basadila Pandey,District- KushiNagar(UP) 手机号码。电话:+91 -8700141797, 9990665616

一种基于马尔可夫决策过程的新型行为预测系统

摘要 为保证飞机的正常稳定飞行,飞机上采用了多种传感器及相应的仪表系统来监测/控制当前的飞行状态,而得到的数据在保证飞行安全的同时也给飞行员带来了很大的负担。因此,飞机座舱自动化辅助系统成为当今的研究热点。本文基于自动化辅助系统启动后,可以通过飞行操作的不同阶段预测飞行员未来的操作行为,从而根据飞行员的操作习惯为其提供辅助。通过对飞行员操作行为和飞行过程任务要求的分析与建模,建立了MDP(Markov Decision Process)模型,并利用价值迭代算法寻找最优预测序列,最后通过飞行操作仿真实验验证了算法的可操作性。为飞行员操作的安全性和座舱自适应自动化辅助系统的侵入性提供了一种新的解决方案。

一种基于马尔可夫决策过程的新型行为预测系统

摘要 为保证飞机的正常稳定飞行,飞机上采用了多种传感器及相应的仪表系统来监测/控制当前的飞行状态,而得到的数据在保证飞行安全的同时也给飞行员带来了很大的负担。因此,飞机座舱自动化辅助系统成为当今的研究热点。本文基于自动化辅助系统启动后,可以通过飞行操作的不同阶段预测飞行员未来的操作行为,从而根据飞行员的操作习惯为其提供辅助。通过对飞行员操作行为和飞行过程任务要求的分析与建模,建立了MDP(Markov Decision Process)模型,并利用价值迭代算法寻找最优预测序列,最后通过飞行操作仿真实验验证了算法的可操作性。为飞行员操作的安全性和座舱自适应自动化辅助系统的侵入性提供了一种新的解决方案。

马尔可夫链不变分布的定量近似。一种新方法

在本文中,我们在可测量的状态空间(x,x)上处理一个Markov链,该链具有一个过渡内核P,允许一些小型s∈X,也就是说,对于任何x∈X,a∈X,对于p(x,a)≥ν(x,a)≥ν(x,a)1 s(x)1 s(x)。在这种情况下,我们提出了在(x,x)上的p- invariant概率度量π的建设性表征,使得π(1 s)>0。当存在这样的π时,仅根据ν,p和s的有限线性组合,在加权或标准的总变化规范中近似。接下来,使用标准漂移型条件,我们提供近似的几何/子几何收敛界限。这些界限是完全明确的,并且尽可能简单。收敛速率是准确的,在原子情况下它们是最佳的。请注意,还讨论了在[HL20B]中引入的有限级分配子不能进行近似P的收敛速率。这是一种近似π的新方法,因为它不是基于p对π的迭代的收敛性。因此,我们不需要任何疗效条件。此外,证明是直接的。他们在非原子案例中既不使用分裂链,也不使用续签理论,耦合方法,也不使用光谱理论。从某种意义上说,这种具有小型马尔可夫链的方法是独立的。

一种基于马尔可夫决策过程的新型行为预测系统

摘要 为保证飞机的正常稳定飞行,飞机上采用了多种传感器及相应的仪表系统来监测/控制当前的飞行状态,而得到的数据在保证飞行安全的同时也给飞行员带来了很大的负担。因此,飞机座舱自动化辅助系统成为当今的研究热点。本文基于自动化辅助系统启动后,可以通过飞行操作的不同阶段预测飞行员未来的操作行为,从而根据飞行员的操作习惯为其提供辅助。通过对飞行员操作行为和飞行过程任务要求的分析与建模,建立了MDP(Markov Decision Process)模型,并利用价值迭代算法寻找最优预测序列,最后通过飞行操作仿真实验验证了算法的可操作性。为飞行员操作的安全性和座舱自适应自动化辅助系统的侵入性提供了一种新的解决方案。

量化开放量子动力学中的非马尔可夫性

非马尔可夫开放量子动力学的表征具有理论和实践意义。在一篇开创性的作品 [ Phys. Rev. Lett. 120, 040405 (2018) ] 中,提出了一个必要且充分的量子马尔可夫条件,具有清晰的操作解释和与经典极限的对应关系。在这里,我们为一般开放量子动力学提出了两个非马尔可夫性测度,它们与马尔可夫极限完全相一致,并且可以基于系统的多时间量子测量进行有效计算。提出了一种重建底层开放量子动力学的启发式算法,其复杂性与提出的非马尔可夫性测度直接相关。通过数值示例展示了非马尔可夫性测度和重建算法,并仔细重新审视了量子失相动力学中的非马尔可夫性。

一种基于马尔可夫决策过程的新型行为预测系统

摘要 为保证飞机的正常稳定飞行,飞机上采用了多种传感器及相应的仪表系统来监测/控制当前的飞行状态,而得到的数据在保证飞行安全的同时也给飞行员带来了很大的负担。因此,飞机座舱自动化辅助系统成为当今的研究热点。本文基于自动化辅助系统启动后,可以通过飞行操作的不同阶段预测飞行员未来的操作行为,从而根据飞行员的操作习惯为其提供辅助。通过对飞行员操作行为和飞行过程任务要求的分析与建模,建立了MDP(Markov Decision Process)模型,并利用价值迭代算法寻找最优预测序列,最后通过飞行操作仿真实验验证了算法的可操作性。为飞行员操作的安全性和座舱自适应自动化辅助系统的侵入性提供了一种新的解决方案。