机构名称:

¥ 1.0

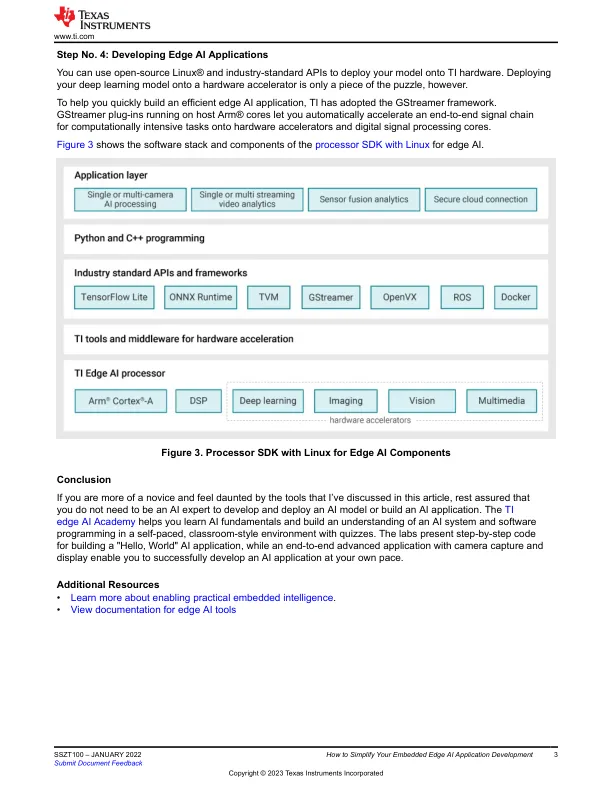

TI 灵活的软件架构和开发环境让您可以在任何地方训练模型,并使用您最喜欢的行业标准 Python 或 C++ 应用程序编程接口 (API)(来自 TensorFlow Lite、ONNX RunTime 或 TVM 和 SageMaker Neo with Neo AI DLR 运行时引擎)仅用几行代码即可将其编译并部署到 TI 硬件上。在这些行业标准运行时引擎的后端,我们的 TI 深度学习 (TIDL) 模型编译和运行时工具让您可以为 TI 硬件编译模型,将编译后的图形或子图部署到深度学习硬件加速器上,并从处理器获得最佳推理性能,而无需任何手动工具。

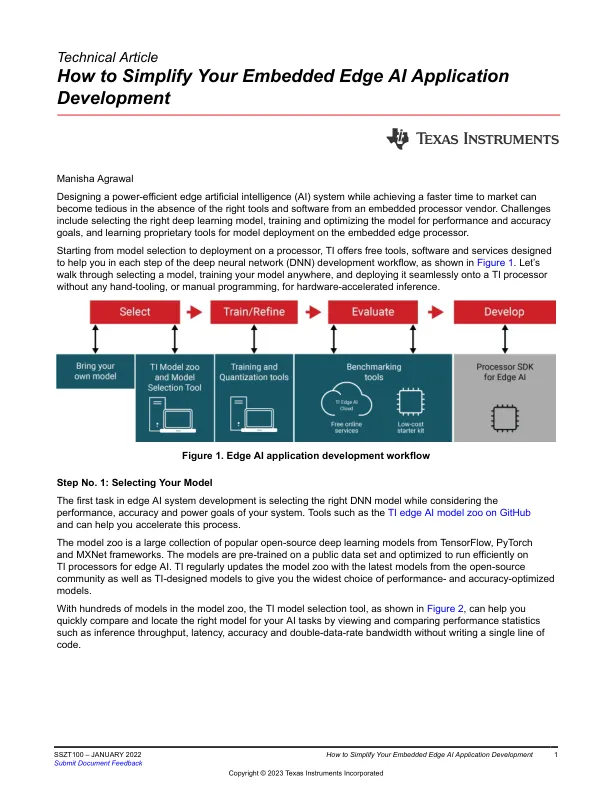

如何简化嵌入式边缘 AI 应用程序开发