机构名称:

¥ 1.0

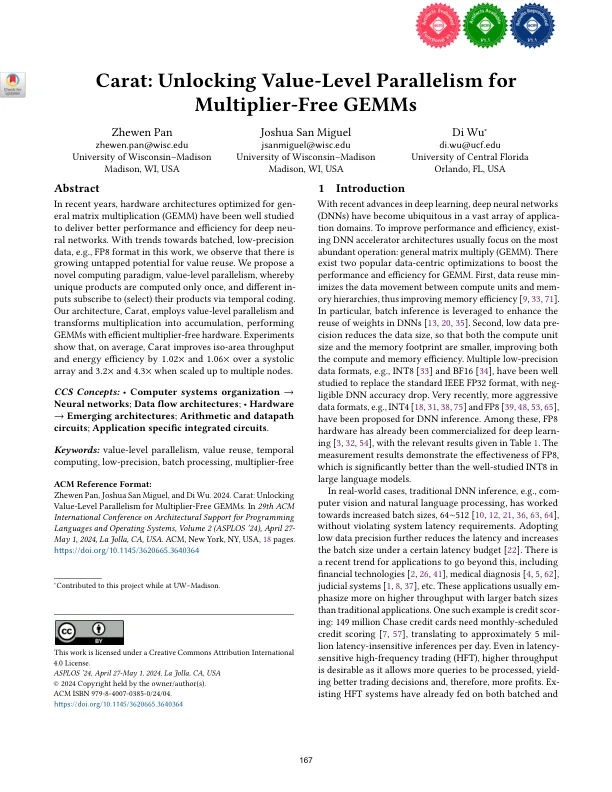

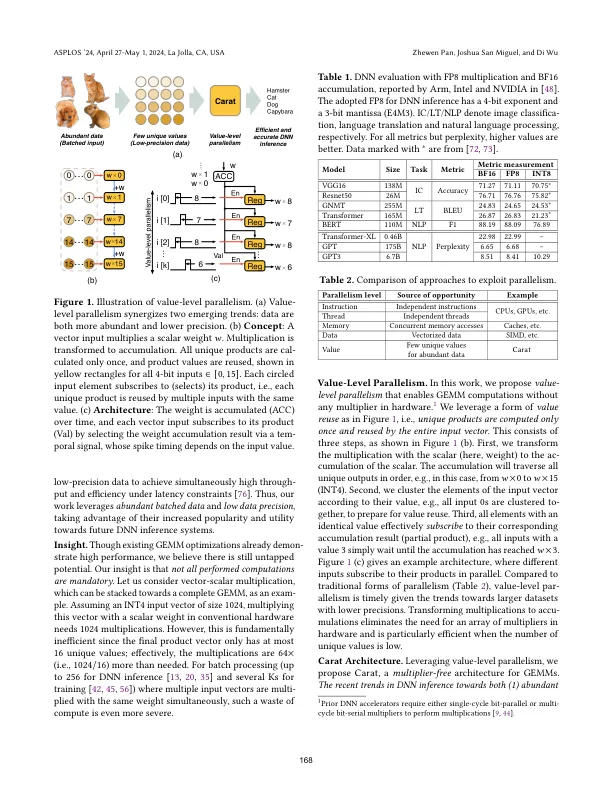

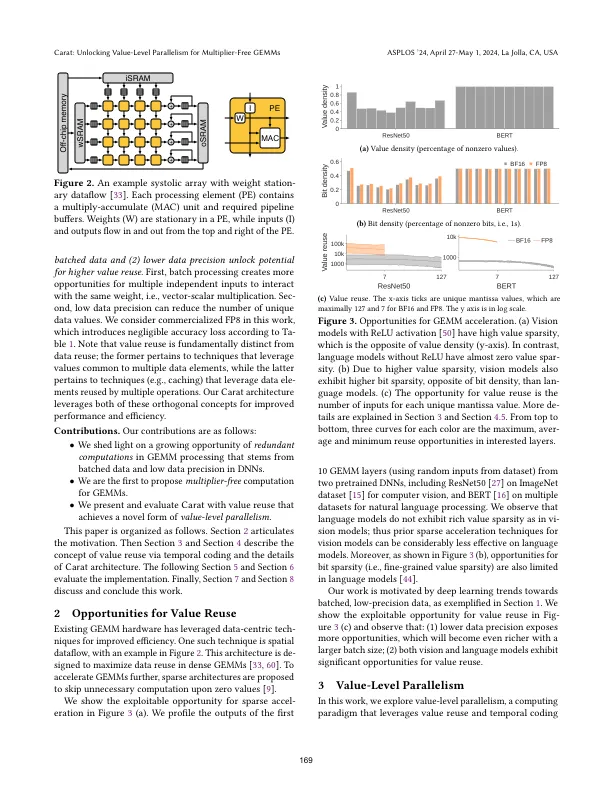

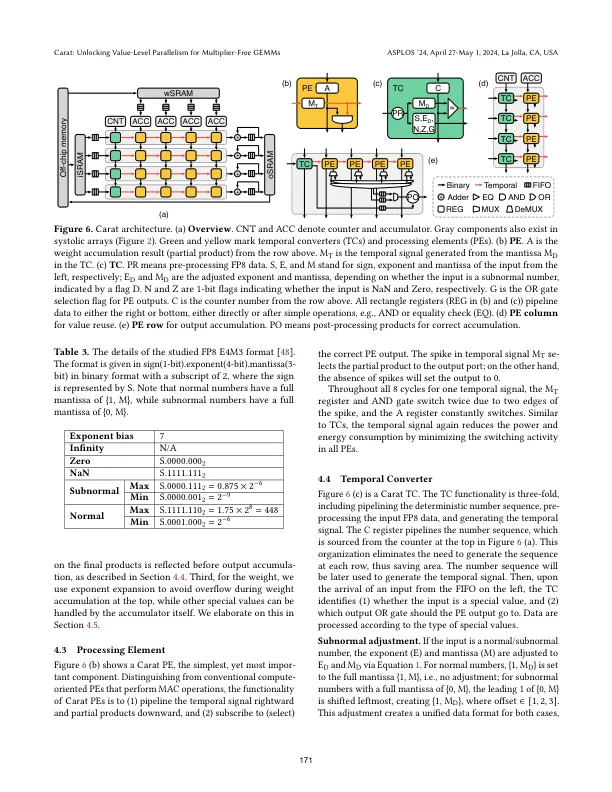

摘要 近年来,针对通用矩阵乘法 (GEMM) 优化的硬件架构已得到深入研究,以为深度神经网络提供更好的性能和效率。随着分批、低精度数据(例如本文中的 FP8 格式)的趋势,我们观察到值重用的未开发潜力越来越大。我们提出了一种新颖的计算范式,即值级并行,其中唯一的乘积只计算一次,不同的输入通过时间编码订阅(选择)它们的乘积。我们的架构 Carat 采用值级并行并将乘法转换为累积,使用高效的无乘法器硬件执行 GEMM。实验表明,平均而言,Carat 可将等面积吞吐量和能源效率提高 1.02 ⇥ 和 1.06 ⇥(相对于脉动阵列)以及 3.2 ⇥ 和 4 ⇥。 3⇥当扩展到多个节点时。

为无乘法器 GEMM 解锁价值级并行性

主要关键词

![用于人工智能和神经形态计算的硅光子学 Bhavin J. Shastri 1,2、Thomas Ferreira de Lima 2、Chaoran Huang 2、Bicky A. Marquez 1、Sudip Shekhar 3、Lukas Chrostowski 3 和 Paul R. Prucnal 2 1 加拿大安大略省金斯顿皇后大学物理、工程物理和天文学系,邮编 K7L 3N6 2 普林斯顿大学电气工程系,邮编 新泽西州普林斯顿 08544,美国 3 加拿大不列颠哥伦比亚大学电气与计算机工程系,邮编 BC 温哥华,邮编 V6T 1Z4 shastri@ieee.org 摘要:由神经网络驱动的人工智能和神经形态计算已经实现了许多应用。电子平台上神经网络的软件实现在速度和能效方面受到限制。神经形态光子学旨在构建处理器,其中光学硬件模拟大脑中的神经网络。 © 2021 作者 神经形态计算领域旨在弥合冯·诺依曼计算机与人脑之间的能源效率差距。神经形态计算的兴起可以归因于当前计算能力与当前计算需求之间的差距不断扩大 [1]、[2]。因此,这催生了对新型大脑启发算法和应用程序的研究,这些算法和应用程序特别适合神经形态处理器。这些算法试图实时解决人工智能 (AI) 任务,同时消耗更少的能量。我们假设 [3],我们可以利用光子学的高并行性和速度,将相同的神经形态算法带到需要多通道多千兆赫模拟信号的应用,而数字处理很难实时处理这些信号。通过将光子设备的高带宽和并行性与类似大脑中的方法所实现的适应性和复杂性相结合,光子神经网络有可能比最先进的电子处理器快至少一万倍,同时每次计算消耗的能量更少 [4]。一个例子是非线性反馈控制;这是一项非常具有挑战性的任务,涉及实时计算约束二次优化问题的解。神经形态光子学可以实现新的应用,因为没有通用硬件能够处理微秒级的环境变化 [5]。](/simg/d/d0b24e3de4e984953fcbe1080336ba472eefd4f9.png)