机构名称:

¥ 2.0

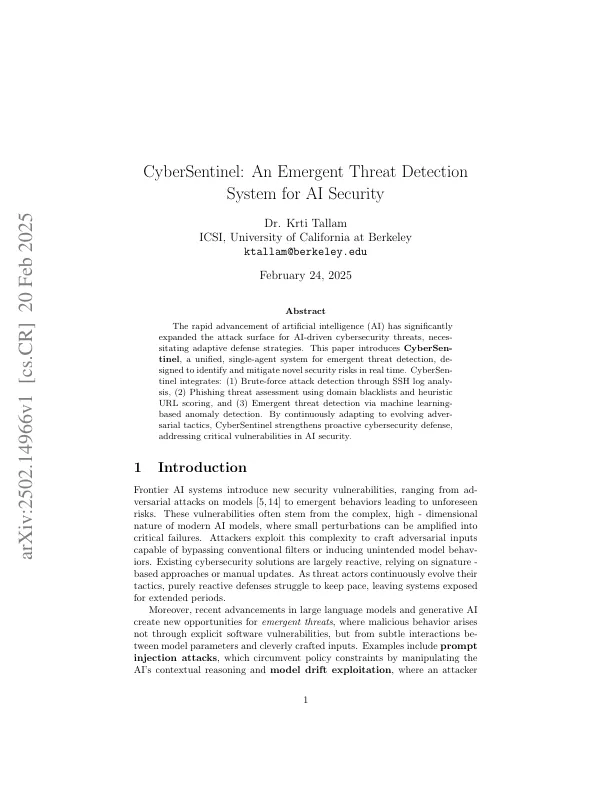

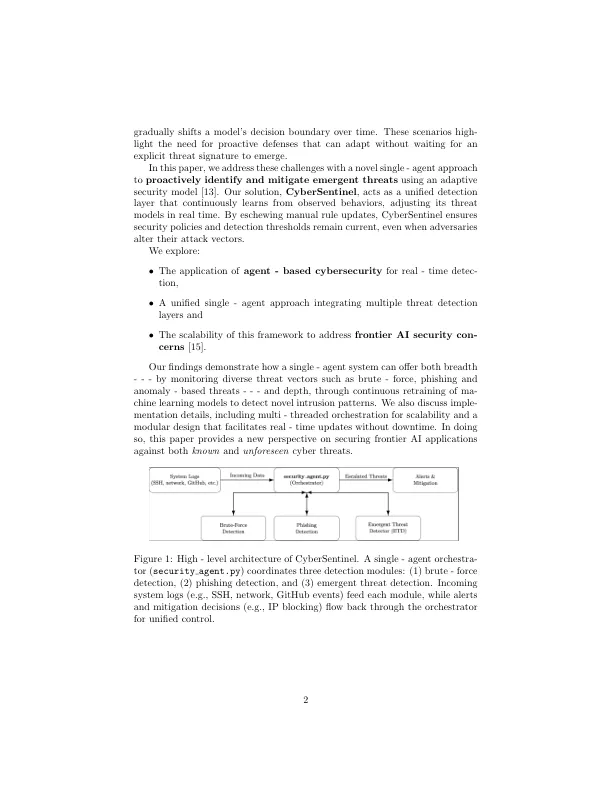

Frontier AI系统引入了新的安全漏洞,从对模型[5,14]的广泛攻击到新兴行为,导致不可预见的风险。这些漏洞通常源于现代AI模型的复杂,高维质,在这种情况下,可以将小的扰动扩大到关键故障中。攻击者利用这种复杂性来制作能够绕过常规过滤器或引起意外模型行为的对抗性输入。现有的网络安全解决方案在很大程度上取决于基于签名的方法或手动更新。作为威胁行为者不断发展他们的战术,纯粹的反应防御能力努力保持步伐,使系统长期暴露。此外,大型语言模型和生成AI的最新进展为新兴威胁创造了新的机会,在这种威胁中,恶意行为不是通过明确的软件漏洞而产生的,而是通过模型参数和精心制作的输入之间的微妙交互。示例包括提示注射攻击,通过操纵AI的上下文推理和模型漂移利用来规避策略的约束,其中攻击者

AI安全的新兴威胁检测系统