机构名称:

¥ 1.0

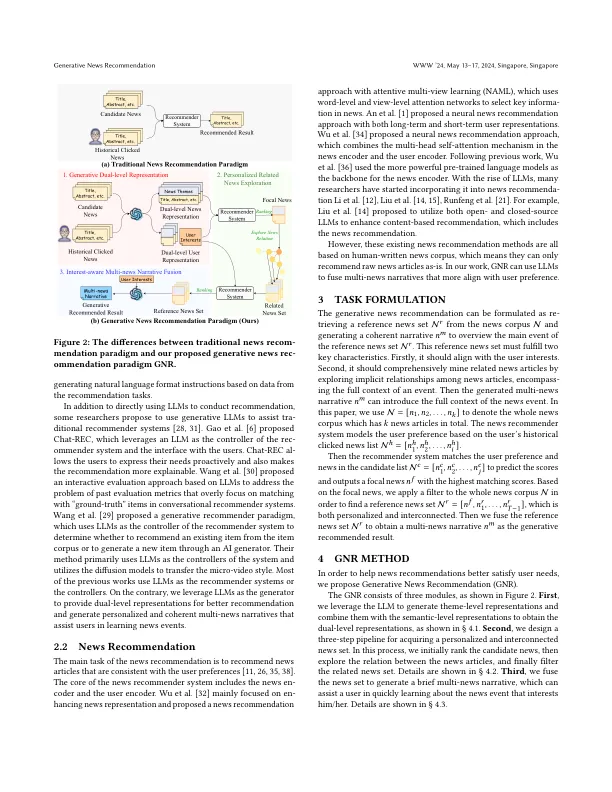

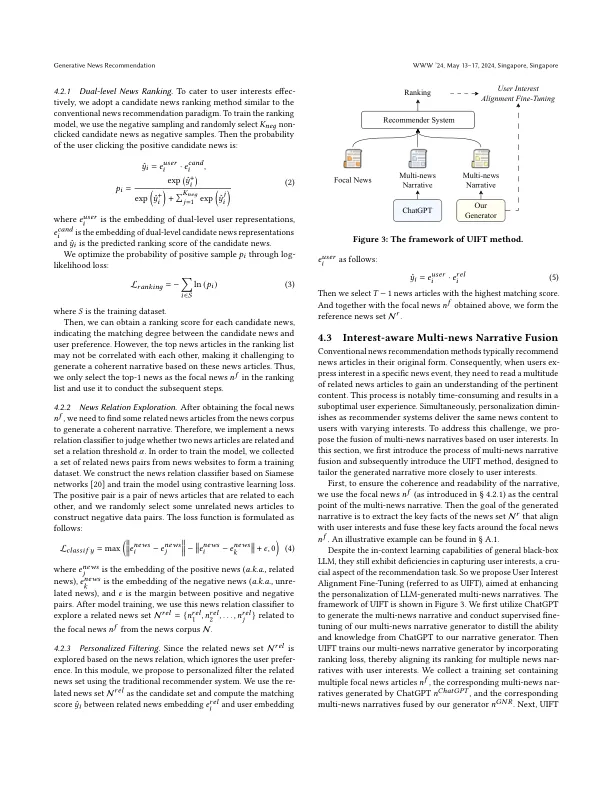

大多数现有的新闻推荐方法通过在历史点击新闻产生的候选新闻和用户表示之间进行语义匹配来解决此任务。但是,他们忽略了不同新闻文章之间的高级联系,也忽略了这些新闻界与用户之间的深刻关系。以及这些方法的定义表明,它们只能提供新闻文章。相反,将几篇相关的新闻文章纳入连贯的叙述将有助于用户获得对事件的更快,更全面的了解。在本文中,我们提出了一个新颖的新闻建议范式,其中包括两个步骤:(1)利用大语言模型(LLM)的内部知识和推理能力(LLM)在候选新闻和用户表示之间进行高级匹配; (2)基于相关新闻和用户兴趣之间的关联生成连贯且逻辑上结构化的叙述,从而使用户参与新闻的进一步阅读。具体来说,我们建议GNR实施生成新闻建议范式。首先,我们通过利用LLM生成主题级表示并通过语义级表示来构成新闻和用户的双重表示。接下来,为了生成连贯的叙述,我们将探索新闻关系并根据用户偏好过滤相关新闻。最后,我们提出了一种名为UIFT的新型培训方法,以训练LLM,以连贯的叙述融合多个新闻文章。广泛的例证表明,GNR可以提高建议准确性,并最终产生更个性化和实际上一致的叙述1。

生成新闻推荐