机构名称:

¥ 2.0

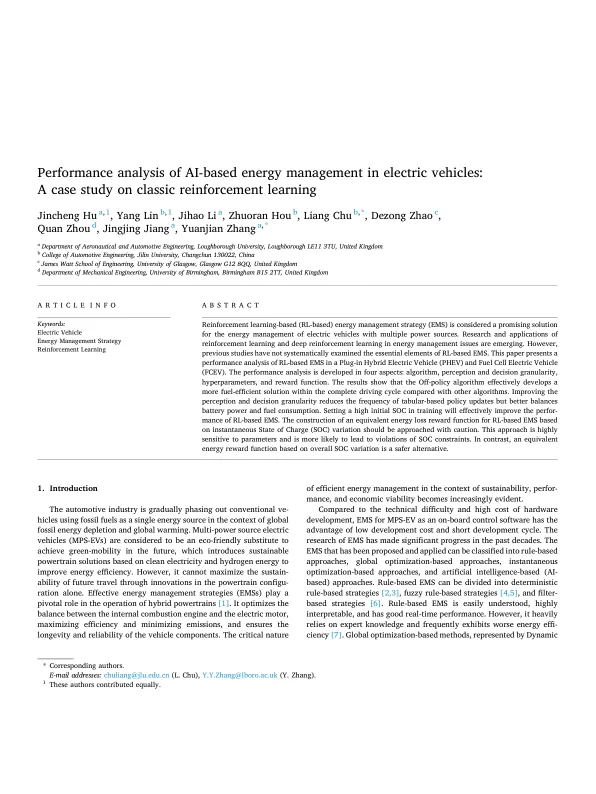

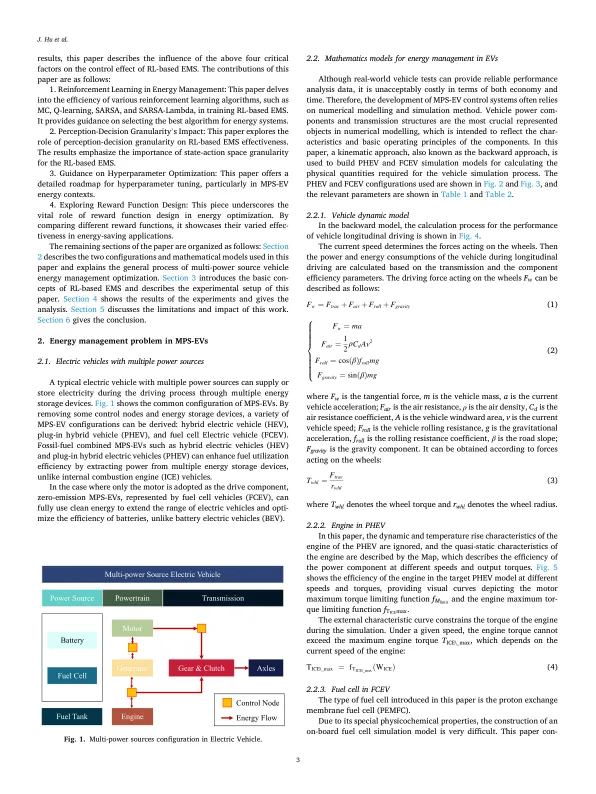

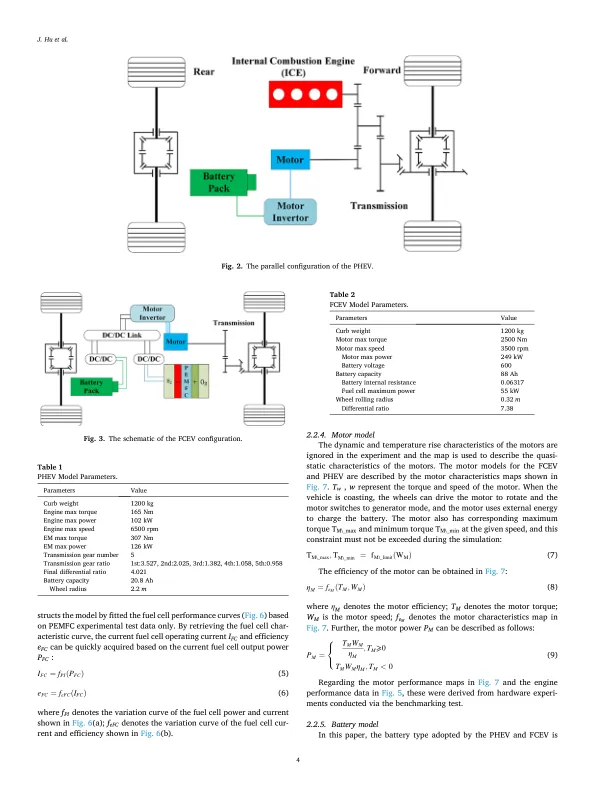

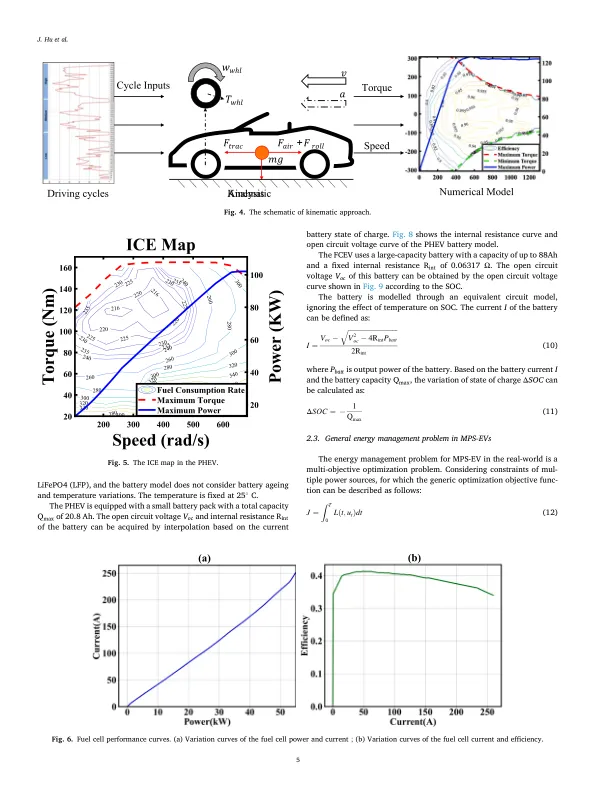

基于强化学习(基于RL)的能源管理策略(EMS)被认为是具有多种电源的电动汽车的能源管理的有前途的解决方案。正在出现强化学习和深度强化学习的研究和应用。但是,以前的研究尚未系统地检查基于RL的EMS的基本要素。本文介绍了插电式混合动力汽车(PHEV)和燃料电池电动汽车(FCEV)中基于RL的EMS的性能分析。绩效分析在四个方面开发:算法,感知和决策粒度,超参数和奖励功能。结果表明,与其他算法相比,在整个驾驶周期内有效地开发了更具燃油效率的解决方案。改善感知和决策粒度会降低基于表格的策略更新的频率,但可以更好地平衡电池功率和油耗。在训练中设置高初始SOC将有效地改善基于RL的EMS的绩效。应谨慎对待基于瞬时电荷状态(SOC)变化的基于RL的EMS的等效能量损失奖励函数。这种方法对参数高度敏感,更有可能导致违反SOC约束。相比之下,基于整体SOC变化的等效能量奖励函数是更安全的选择。

dapagliflozin和心力衰竭的死亡模式,并改善了射血分数,均事事后分析

主要关键词