机构名称:

¥ 5.0

摘要过去几十年见证了各种机器学习模型的惊人预测能力,但通常的假设是这些模型被部署在良性环境中。尽管取得了很多进展,但在攻击下许多机器学习模型的鲁棒性仍未得到探索。在这次演讲中,我将介绍有关数据中毒攻击的工作,旨在通过向培训集中注入恶意或误导性数据(即对对抗性样本)来操纵机器学习模型的行为。我将介绍我们开发的方法,以系统地创建对抗性样本,这些样本可能会使模型的原始目标偏向一系列机器学习任务,包括结果解释,公平的机器学习,Next-ISEM建议和知识图嵌入。对我们设计攻击的实验和理论分析为机器学习模型的脆弱性提供了宝贵的见解,并可以为更安全和可靠的机器学习系统的开发提供信息。

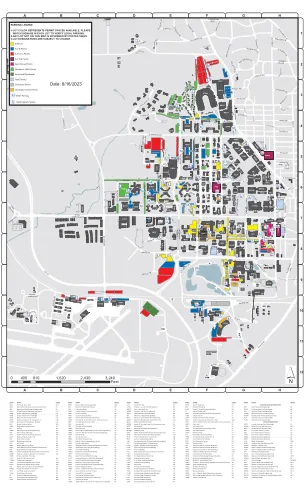

目录 - 谷物,普渡大学