机构名称:

¥ 1.0

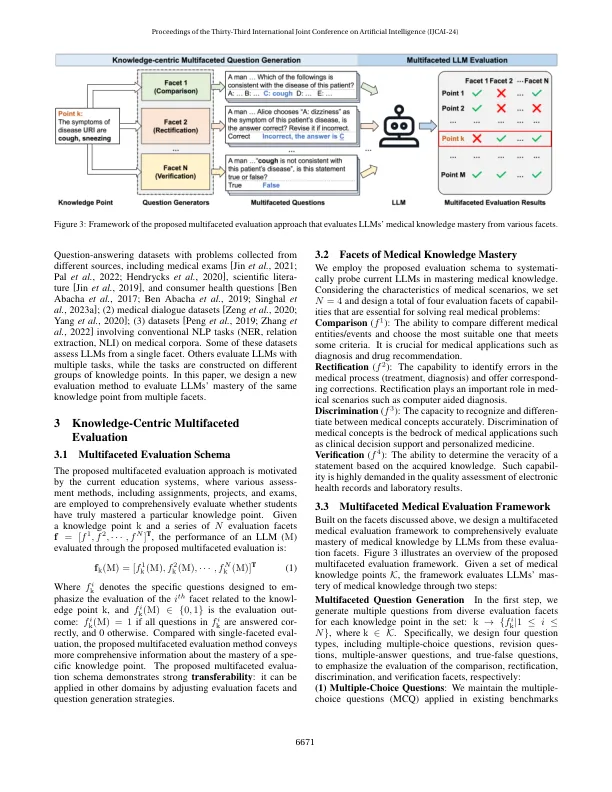

大型语言模型(LLM)在跨领域表现出色,在医学评估基准(例如MEDQA)上也提供了显着的表现。但是,在现实世界中医学场景中,报告的性能与实际有效性之间仍然存在显着差距。在本文中,我们旨在通过采用多方面的检查模式来系统地探索当前LLM的实际掌握医学知识的掌握,以探讨这一差距的原因。具体而言,我们开发了一种新颖的评估框架多叶序,以检查LLM在多个方面的编码和掌握医学知识中的范围和覆盖范围。基于多叶术框架,我们构建了两个多方面的评估数据集:Multidisek(通过从临床疾病知识库中产生问题)和MultiMEDQA(通过将Medical Benchmark MedQA从Medical Benchmark MedQa重新提出每个问题,以进行多方面的问题)。这些模拟数据集的实验结果表明,掌握医学知识的当前LLM的程度远低于其在现有医疗基准上的表现,这表明它们缺乏深度,预见和在掌握知识中的全面性。因此,当前的LLM尚未准备好在现实世界中的任务中应用。代码和数据集可在https://github.com/thumlp/multifaceteval上找到。

多范围:多方面的评估,以探测掌握医学知识的LLMS

主要关键词