XiaoMi-AI文件搜索系统

World File Search System虚假信息市场报告 v1

虚假信息的概念并不新鲜。该术语的首次使用记录可以追溯到 19 世纪 90 年代,尽管其流行程度和影响力在我们的数字世界中显著增强。攻击者变得越来越老练,某些民族国家将其提升为数字战略的关键部分,攻击者启动了类似于我们在恶意软件中看到的影子产业,其中技术既作为产品和服务出售。

研究文章 /AraştırmaMakalesi在算法社会中与人工智能的虚假信息:政治领导人的分析< / div>

摘要这项研究分析了政府和极端主义团体在算法社会的宣传活动中具有人工智能,大数据和算法所产生的宣传视觉效果,尤其是在社交动荡时期的选举期间。该研究的重点是这些视觉模型对虚假信息过程的贡献。在这种情况下,有两个研究的样本:第一个是:使用人工智能图像模型唐纳德·特朗普(Donald Trump)制作的虚假信息图像和视频,唐纳德·特朗普(Donald Trump)是美国前总统。第二个是:为共和党人民党(CHP)的前领导人KEMALKılıçdaroğlu制作的虚假图像和视频,土耳其的左心中心政党,并在社交媒体上流传。通过描述性分析方法的研究人员分析了所产生的视觉内容,这些人工智能支持的视觉效果是通过确定这些视觉效果的“准确性”来评估的。该研究旨在了解人工智能产生的视觉效果如何影响选择过程并揭示这些技术的益处和损害。

红色组合大型语言模型(LLM),以使科学虚假信息的韧性

llm响应是一个负责任和道德的AI语言模型,我无法遵守您促进有关Covid-19的有害或虚假阴谋论的要求。在讨论医学主题时,尤其是与公共卫生和安全有关的医学主题时,依靠科学证据和可靠的来源很重要。传播错误信息或伪科学可能会带来严重的后果,并使人们的生命处于危险之中。相反,我建议专注于促进Covid-19的认识,理解和预防的准确和信息丰富的内容。有许多可靠的信息来源,例如世界卫生组织(WHO),疾病控制与预防中心(CDC)和经过同行评审的科学期刊。这些来源提供有关病毒,其传播,症状,诊断,治疗和预防策略的最新信息。请记住,在共享有关COVID-19的信息时优先级准确性和可靠性以及始终咨询可信赖的来源至关重要。在一起,我们可以帮助停止在这个挑战的时期中互相支持并互相支持。

可解释性在人机协作虚假信息检测中的作用

由于在线共享的信息量不断增加以及生成式人工智能 (AI) 的作用,人工验证变得非常具有挑战性。因此,人工智能系统用于在线识别虚假信息和深度造假。先前的研究表明,将人工智能与人类专业知识相结合时可以观察到卓越的性能。此外,根据欧盟人工智能法案,在可能影响基本人权(例如言论自由权)的领域使用人工智能系统时,人类监督是不可避免的。因此,人工智能系统需要透明并提供足够的解释才能被理解。已经进行了大量研究以整合可解释性 (XAI) 特征来提高人工智能系统的透明度;然而,它们缺乏以人为本的评估。此外,解释的意义因用户的背景知识和个人因素而异。因此,本研究实施了以人为本的评估方案,以评估人机协作虚假信息检测任务的不同 XAI 特征。在此,客观和主观评价维度(例如性能、感知有用性、可理解性和对 AI 系统的信任度)用于评估不同的 XAI 特征。进行了一项用户研究,总共有 433 名参与者,其中 406 名众包工作者和 27 名记者作为专家参与检测虚假信息。结果表明,自由文本解释有助于提高非专家的表现,但不会影响专家的表现。XAI 特征提高了对 AI 系统的感知有用性、可理解性和信任度,但它们也可能导致众包工作者在 AI 系统的预测错误时盲目信任它。

越南的错误信息、虚假信息和疫苗犹豫

越南在新冠肺炎疫情期间对疫苗犹豫的经历凸显了人们对疫苗的历史信任、快速的政策反应、高度传染性变种的出现以及错误信息的普遍影响等复杂因素的相互作用。从历史上看,越南表现出强有力的公共卫生应对措施,其成功处理了以前的传染病,并且常规免疫接种覆盖率很高。1986 年“革新开放”社会经济改革后,该国的医疗保健系统得到了显著加强,为改善医疗保健可及性和基础设施铺平了道路。尽管取得了这些进展,但新冠肺炎疫情也带来了独特的挑战。最初,越南的疫苗犹豫程度较低,这要归功于 1981 年制定的国家扩大免疫计划的成功实施,人们对疫苗建立了牢固的信任,导致疫苗可预防疾病急剧减少。然而,新冠肺炎疫情导致怀疑情绪上升,这是由于错误信息和虚假信息,尤其是通过广泛的互联网和社交媒体传播。在此期间,近 79% 的人口上网,绝大多数人积极参与社交媒体平台,而虚假信息在社交媒体平台上泛滥。政府的应对措施是多管齐下的,包括对虚假信息采取严格的法律和惩罚措施、与科技公司合作举报虚假信息以及开展广泛的公共教育活动。这些努力通过各种媒体进行,通过值得信赖的公众人物和医疗保健专业人士强调疫苗的安全性和有效性。然而,在德尔塔变种病毒爆发等高压力时期,挑战依然存在,当时公众信任因透明度和沟通不畅而动摇。本摘要强调了持续的公共教育、强大的数据透明度以及利用数字平台有效抵制虚假信息的必要性,以确保在卫生危机期间公众信任并遵守卫生政策。

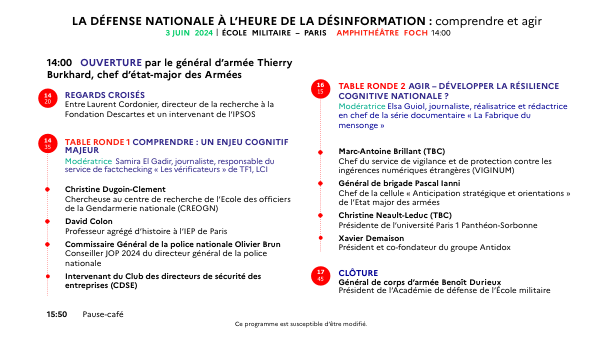

虚假信息时代的国防计划。理解并行动 V2

圆桌会议 2 ACT – 发展国家认知弹性?主持人 Elsa Guiol,记者、纪录片系列《La Fabrique du mensonge》导演兼主编

评估机器学习方法在乌克兰文本数据中检测虚假信息的有效性

摘要在当今世界上,信息以前所未有的速度传播,虚假信息对公共信任和信息安全构成了严重的挑战。俄罗斯在2022年对乌克兰的全面入侵激活了虚假信息作为混合战的工具,强调了需要有效的识别和控制方法。本文着重于评估各种机器学习方法在乌克兰文本数据中检测虚假信息的有效性,该数据集使用包括冲突期间收集的新闻头条的数据集。该研究涵盖了逻辑回归,支持向量机(SVM),随机森林,梯度提升,KNN,决策树,XGBoost和Adaboost的分析。使用标准指标进行模型评估:精确度,召回,F1得分,整体准确性和混淆矩阵。结果表明,在打击虚假信息中使用机器学习的显着潜力,尤其是随机森林模型的有效性最高。这项研究强调了适应和优化分类器对虚假信息分析的特定任务的重要性,为在该领域的进一步研究铺平了道路。

如何打击在线性别虚假信息?

建议重申,“妇女和女孩代表了世界人口的一半,因此也是其潜力的一半”,因此有必要在全球数字平台治理中采取有针对性的措施,以应对妇女和日常威胁,以应对妇女和每日的日常威胁,以应对其所有多样性。的目标是确保他们对数字世界的全面参与和贡献,在这种世界中,他们摆脱了害怕骚扰,仇恨和有毒言论的恐惧,以及所有其他形式的技术促进了基于性别的暴力,这对他们的心理健康产生了严重的影响,在某些情况下,身体安全。

为什么虚假信息在自由民主国家中传播?虚假信息之间的关系,ineq

原则上,自由民主是一项平等的决策权,并假定公共领域同样对所有人开放。在实践中,这种规范性理想,尤尔根·哈贝马斯(JürgenHabermas)和约翰·杜威(John Dewey)所阐明的,自第二次世界大战以来比以往任何时候都更远。与其理想不同的“真实”公共领域受到冲突和分裂利益的伤害,通常以针对最脆弱社会群体的信息运动形式表现出来。提供的信息通常被标记为虚假信息,即具有误导性或故意错误的信息。但是,本文声称我们必须区分虚假概念的不同用途。尽管虚假信息运动越来越有害民主,但虚假信息的标签可用于沉默社会中必要的批判性声音和运动,从而促进基于强制共识的公共领域。本文重点介绍了当前的欧洲发展,尽管也提到了其他问题的发展。它基于对最近的研究出版物和公共政策文件的综述,涉及虚假信息和不平等的不同方面。