XiaoMi-AI文件搜索系统

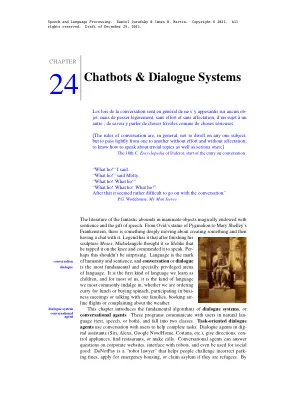

World File Search System聊天机器人与对话系统

然后我,依此类推)。图中有20圈24.1。转弯可以由一个句子组成(例如C 1),尽管它可能短于单个单词(C 13)或多个句子(A 10)。转弯结构对口语对话具有重要意义。一个系统必须知道何时停止说话;客户端中断(在16和C 17中),因此系统必须知道停止说话(并且用户可能正在进行更正)。一个系统还必须知道何时开始说话。例如,大多数时候在谈话中,演讲者几乎立即在其他演讲者完成后立即开始转弯,而没有长时间的停顿,因为人们(大多数时候)能够(大多数时候)检测到另一个人何时会说话。口语对话系统还必须检测到用户是否说话,以便他们可以处理话语并做出响应。此任务(称为端点或端点检测)可能非常具有挑战性,因为端点

作家参考 - Kelli•ninja

A 学术阅读、写作和口语 A1 批判性阅读和写作 A2 阅读和写作多模态文本 A3 阅读论据 A4 写作论据 A5 自信地演讲 A6 学科写作

Braintalker:使用WAV2VEC 2.0

摘要 - 从大脑中的神经活动中解码口语是一个快速的研究主题,因为它可以使在产生可听见的语音困难的人们中进行沟通。对于此任务,电皮质学(ECOG)是记录具有高时间分辨率和高空间精度的大脑活动的常见方法。但是,由于获得ECOG记录所需的风险外科手术程序,收集了相对较少的数据,并且该数量不足以训练基于神经网络的脑对语音(BTS)系统。为了解决这个问题,我们提出了Braintalker,这是一个新颖的BTS框架,它在极低的资源场景下从ECOG信号中产生可理解的口语演讲。我们使用预先训练的自我监督模型WAV2VEC 2.0采用转移学习方法。具体来说,我们训练一个编码器模块将ECOG信号映射到匹配相应口语语音的wav2Vec 2.0表示的潜在嵌入。然后,使用堆叠的卷积和基于变压器的层将这些嵌入转化为MEL光谱图,这些图形被送入神经声码器中以合成语音波形。实验结果表明,我们所提出的框架在主观和客观指标方面达到了出色的表现,包括生成的和地面真相光谱图之间的Pearson相关系数为0.9。我们共享公开可用的演示和代码1。

阅读教学的位置论文

因此,我们承认阅读简单观点的实用性(Gough&Tunmer,1986)提供了一个教育框架,以了解早期阅读的教学和评估。简单的观点描述了更广泛的阅读理解意义的阅读,并突出了在两个单独且独特的核心过程中提高水平的必要性:a)“解码(或识别)产生口语的印刷单词的能力”,b)“了解口语的含义”(Hoover&Tunmer,2018,2018)。因此,在这种情况下的理解是指语言理解,并认识到逻辑推理和听力理解是未来阅读成就的关键(Moats,2020)。让儿童在简单视图中确定的阅读理解的两个组成部分中发展熟练程度,需要获得一系列认知技能(Tunmer&Hoover,2019)。

解码非...中的想象和口头短语

语音生成是一种分层机制,涉及大脑和口腔发音器官的同步,其中语言概念的意图被转化为有意义的声音。闭锁综合征患者(完全瘫痪但有意识)完全失去了运动能力,包括发音甚至眼球运动。神经通路可能是恢复这些患者一定程度交流的唯一选择。当前的脑机接口 (BCI) 使用患者的视觉和注意力相关性来建立交流,导致交流速度较慢(每分钟几个字)。直接从神经信号解码想象中的语音(然后驱动语音合成器)有可能提高交流速度。在本研究中,我们研究了从 8 名成年受试者的单次试验、非侵入性脑磁图 (MEG) 信号中收集的五个想象和口语短语的解码。使用了两种机器学习算法。一种是以统计特征为基线方法的人工神经网络 (ANN)。另一种方法是将卷积神经网络 (CNN) 应用于从 MEG 信号中提取的空间、光谱和时间特征。实验结果表明,可以直接从神经磁信号中解码想象和口语短语。CNN 被发现非常有效,平均解码准确率高达 93%(想象短语)和 96%(口语短语)。

核心事务 - Generali Investments

一个人可以区分四种类型的AI技术。首先,LLM(大型语言模型)的设计旨在了解和生成人类语言。这些模型经过大量文本数据的培训,以学习统计数据,语义关系和对语言的上下文理解,并专注于产生模仿人类语音的响应(即聊天机器人)。第二,ML/PA(Ma-Chine学习/预测分析)是定量的,涉及算法的统计模型,这些算法可以从输入数据,实时更新和从客观功能中从反馈中提高绩效,从而对进行预测或进行学习。第三,其他自然语言处理与LLM的处理与人类产生的自然语言的处理不同,以从文本中提取意义。第四,语音识别也称为ASR(自动语音识别),将口语转换为书面文本或命令。它涉及将口语或短语转录为可以通过计算机或应用程序处理,分析或采取的文本形式的过程。

科罗拉多州教育部阅读障碍手册

什么是阅读?阅读是一种奇妙的文化发明,它使我们能够“与死者对话”,一种“用眼睛聆听死者的声音”(弗朗西斯科·德·克维多)。通过学习阅读,我们学会通过一种新的方式获取口语知识,这种方式是进化过程中从未预料到的:视觉。书写是一种非常巧妙的加密设备,通过它,我们可以将口语转化为石头、粘土或纸张上丰富的视觉纹理。阅读对应于这种纹理的解密。在阅读习得过程中,我们会改变大脑中的一些视觉结构,以将它们转变为视觉和语言之间的专门接口。因为阅读从进化的角度来看是一项非常新的发明,直到最近才涉及一小部分人类,所以人类基因组不能包含任何针对阅读特定大脑回路的指令。相反,我们必须回收现有的大脑系统来实现这种新用途。

参考文献和参考书目 - Bill Buxton

B.,Prevost, S. 和 Stone, M. (1994)。动画对话:基于规则的多个对话代理的面部表情、手势和口语语调生成。计算机图形学 (SIGGRAPH '94 会议论文集),28(4):413-420。

使用机器的实时手语翻译器...

413304通讯电子邮件:pradnyaanilrepal28@gmail.com,nikitapore305@gmail.com,akankshapasale@gmail.com,rutujathengal401@gmail.com,swatiambule9518@gmail.com摘要:在当今的Interconconnectent Evernalconnectent,fordemental fundamentals fundamentals fundamentals fundainsental。对于聋人和静音社区,与那些不了解手语的人进行交流是具有挑战性的。为了弥合这一差距,我们提出了一个Web应用程序,将手语翻译成口语或书面语言,反之亦然。用户用相机捕获手势,而我们的系统(由Tensorflow和Advanced Image处理供电)将其转换为连贯的文本。支持各种符号语言和口语,它可以实现实时的双向通信。这种创新的解决方案通过赋予聋人与静音社区与普通人群之间有意义的互动,通过实时沟通和教育计划来促进理解和融合来促进包容性。关键字:包容性交流,AI驱动,手语翻译,Web应用程序,聋哑和静音社区。