XiaoMi-AI文件搜索系统

World File Search System移情的社会传播依赖于观察性强化学习

人类从观察他人那里学习。在这里,我们表明这种观察性学习过程会影响一个人对另一个人的痛苦的同情程度。在我们的研究中,女性参与者观察到他人的同理心或非同理心反应,后来自行提供了同理心评级。观察他人的移情反应导致增加,而观察非移情反应导致参与者的本土同理心减少。这些变化可以通过观察性强化学习来解释,并通过前岛中移情的神经处理及其与颞叶交界处的功能连通性反映出。我们的发现表明,同理心可以是社会传播的,观察性学习可以解释不同社会环境中移情反应的可塑性。

RNA-Seq基因融合检测工具的荟萃分析 量表,新颖壁ches的高分辨率微生物分析 壳聚糖金纳米颗粒基于敏感的视觉检测组氨酸标记的重组蛋白 强化学习和工作记忆系统的双重过程障碍是生理焦虑中学习缺陷的基础 合成PPR蛋白的翻译激活阐明了拟南芥叶绿体中PSBA翻译的控制 在某些选定的白色念珠菌基因中对镜面重复序列的内部评估 生成人工智能执行基本的结构生物学建模 研究了模拟的两组分凝胶系统的组织再生 动物和机器人建模和模拟框架

预印本(未通过同行评审认证)是作者/资助者。保留所有权利。未经许可就不允许重复使用。此版本的版权持有人于2025年2月2日发布。 https://doi.org/10.1101/2023.09.09.03.556087 doi:Biorxiv Preprint

地钱属植物导水细胞的趋同进化招募了ZHOUPI基因,促进细胞壁强化和程序性细胞死亡

Yen-Ting Lu、Jeanne Loue-Manifel、Norbert Bollier、Philippe Gadient、Freya de Winter 等。Marchantia 中导水细胞的趋同进化招募了 ZHOUPI 基因,促进细胞壁强化和程序性细胞死亡。当代生物学 - CB,2024,34 (4),第 793-807 页。�10.1016/j.cub.2024.01.014�。�hal-04434325�

对强化学习进化的评论

摘要 - 强化学习(RL)已成为人工智能(AI)和自我足够结构的迅速发展的领域,彻底改变了机器分析和进行选择的方式。在过去的几年中,RL显着提高了更复杂的算法和方法,这些算法和方法解决了越来越复杂的实际世界问题。这一进展是通过使用计算能力的增强,大数据集的可用性以及改进机器获得策略的驱动来驱动的,可以使RL解决从机器人技术和自动驾驶系统到医疗保健和财务的广泛行业的挑战。RL的效果在优化不确定和动态环境中优化选择制定程序的能力方面显而易见。通过从与环境的互动中了解,RL代理可以做出最大化冗长的时间奖励,适应转换情况并随着时间的推移增强的决策。这种适应性使RL在传统方法短暂落后,尤其是在复杂的,过度的空间和安排后的言论中的情况下成为宝贵的工具。本评论旨在提供有关当前RL国家的根本信息,强调其跨学科贡献以及它如何塑造AI和自主技术的命运。它讨论了RL如何影响机器人技术,自然语言处理和娱乐的改进,同时探索其部署的道德和实践要求的情况。此外,它研究了众多领域的主要研究,这些研究促成了RL的发展。

使用无人机进行时间关键荒野搜索和救援的深度强化学习

荒野地区的传统搜索和救援方法可能很耗时,并且承保范围有限。无人机提供更快,更灵活的解决方案,但是优化其搜索路径对于有效操作至关重要。本文提出了一种新型算法,使用深厚的增强学习,以在荒野环境中为无人机创建有效的搜索路径。我们的方法利用概率分布图的形式利用了有关搜索区域和失踪人员的先验数据。这使策略可以学习最佳的飞行路径,以最大程度地提高找到失踪人员的可能性。实验结果表明,与传统的覆盖计划和搜索计划算法相比,我们的方法在搜索时间方面取得了重大改进,这一差异可能意味着在现实世界中的搜索操作中,与以前的工作不同,我们的方法在现实世界中的搜索操作中,我们的方法还包含了近距离的行动空间,从而使群落启用了更多的细微差别飞行模式。

数据驱动方程发现揭示人类的非线性强化学习

强化学习 (RL) 的计算模型对我们理解人类行为和决策做出了重大贡献。然而,传统的 RL 模型通常采用线性方法来更新奖励预期,这可能会过度简化人类行为与奖励之间的微妙关系。为了应对这些挑战并探索强化学习的新模型,我们利用了一种使用方程发现算法的新型模型发现方法。这种方法目前主要用于物理学和生物学,它试图通过从一系列建议的线性和非线性函数中提出微分方程来捕获数据。使用这种新方法,我们能够识别一种新的 RL 模型,我们称之为二次 Q 加权模型。该模型表明,奖励预测误差服从非线性动力学并表现出负偏差,导致在期望值较低时奖励权重过低,而在期望值较高时奖励缺失权重过高。我们通过将我们的模型与 9 项已发表研究中使用的经典模型进行比较来测试其通用性。在已发布的九个数据集中的八个数据集中,我们的模型在预测准确度方面超越了传统模型,这不仅证明了其普遍性,还表明它有可能为人类学习的复杂性提供新的见解。这项工作展示了将新颖的行为任务与先进的计算方法相结合,作为揭示人类认知复杂模式的有效策略,标志着在开发可解释且广泛适用的计算模型方面迈出了重要一步。

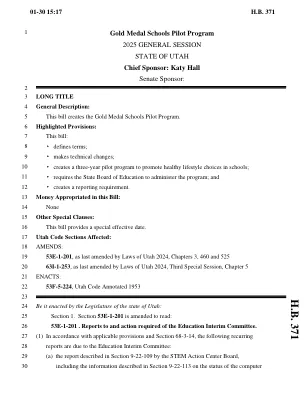

H.B. 371 HB0400S01与HB0400 相比 fun仪服务修正案2025总会... 住房建设修正案2025一般... NRAEQ拨款小组委员会2.4.2025 消费者保护修正案2025一般... HB0249委员会报告 受害者和证人隐私修正案2025将军... b'' 强化您的网络安全 第二个子。 H.B. 230 HB 220:卤素减少和标准建议 b'' 更新犹他州的可再生能源目标。 有效5/5/2021重新编号7/1/2021 63M-4-4-301国家能源政策。 (1)国家的政策是: 车站区域规划 有效5/3/2023 53G-9-303豁免所需疫苗的理由 - 更新。 (1)学生免于接受疫苗的要求 S.B. 227 SB0192S05与SB0192S01 相比 HB0352委员会报告 人口指标和绩效指标 能源燃料公司介绍 犹他州智能电气运输行动计划 经济和社区发展拨款... 第一子。 S.B. 62 b'' 打击水生入侵物种倡议 /支持RFA < / div < / div> OPLR行为健康许可的定期审查 稀缺和丰度: H.B. 459 犹他州的自然资源,农业和环境质量拨款小组委员会| 2025年2月6日 HB0041S01与HB0041 相比 农业和食品修正案2025一般...

213 [(34)](35)标题53F,第10章,第2部分,资本项目评估面板,被废除7月213 [(34)](35)标题53F,第10章,第2部分,资本项目评估面板,被废除7月

基于图神经网络的图形结构SFC的节能VNF部署,并限制了深度强化学习

摘要 - 网络函数虚拟化(NFV),该函数将网络函数从硬件中解除,并将其转换为独立于硬件的虚拟网络函数(VNF),是许多新兴网络域,例如5G,Edge,Edge Computing和Data-Center网络。服务功能链(SFC)是VNF的有序集。VNF部署问题是在SFC中找到最佳的部署策略VNF,同时保证服务级协议(SLA)。现有的VNF部署研究主要关注无能量考虑的VNF序列。但是,随着用户和应用程序要求的快速开发,SFC从序列到动态图,服务提供商对NFV的能源消耗越来越敏感。因此,在本文中,我们确定了能节能的图形结构的SFC问题(EG-SFC),并将其作为组合优化问题(COP)提出。受益于COP机器学习的最新进展,我们提出了一个基于约束深度强化学习(DRL)方法的端到端图神经网络(GNN)来求解EG-SFC。我们的方法利用图形卷积网络(GCN)表示DRL中的双重Q-Network(DDQN)的Q网络。提出了掩模机制来处理COP中的资源约束。实验结果表明,所提出的方法可以处理看不见的SFC图,并且比贪婪的算法和传统DDQN更好地表现出更好的性能。

颠倒的强化学习(UDRL)是解决强化学习问题的有前途的框架,该问题着重于学习命令condi

颠倒的强化学习(UDRL)是解决强化学习问题的有前途的框架,该问题着重于学习命令条件条件政策。在这项工作中,我们将UDRL扩展到学习深神经网络策略的命令条件发生器的任务。我们使用HyperNeTworks完成了这一点,这是一系列快速权重程序员,该程序学会解码输入命令,代表所需的预期返回到特定于命令的权重矩阵。我们的方法是通过策略生成器(UDRLPG)被称为颠倒的增强学习,通过消除评估者或评论家以更新生成器的权重来简化可比较的技术。为了抵消由于没有评估者而引起的最后回报的增加的差异,我们将缓冲液的采样概率与其中的绝对策略数量解脱出来,该策略与简单的权重策略一起改善了算法的经验收敛。与现有算法相比,UDRLPG实现了竞争性能和高回报,有时表现出色的架构更为复杂。我们的实验表明,受过训练的发电机可以概括以创建可实现零射击返回的策略。所提出的方法似乎有效缓解与学习高度模式功能相关的一些挑战。总的来说,我们认为UDRLPG代表了在RL中实现更高的经验样本效率方面迈出的前进一步。https://github.com/jacopod/udrlpg全面实现UDRLPG