XiaoMi-AI文件搜索系统

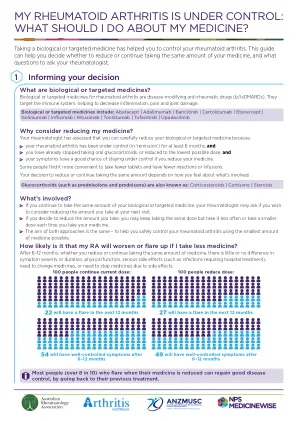

World File Search System我的类风湿关节炎已得到控制

© 2020 NPS MedicineWise。独立。非营利。基于证据。ABN 61 082 034 393。在创建时已采取合理措施提供准确信息。此信息并非医疗建议的替代品,不应仅依赖它来管理或诊断医疗状况。NPS MedicineWise 对因依赖或使用此信息而造成的任何损失、损害或伤害不承担任何责任(包括疏忽)。阅读我们的完整免责声明。2020 年 10 月发布。NPS2335

人工智能如何改变我们做出购买决策的方式?这对商标法意味着什么?商标法的核心在于如何购买商品和服务,而由于人工智能正在影响购买过程,因此从定义上讲它也影响着商标法。人工智能通过两种方式影响购买过程:(a)消费者可获得的品牌信息和(b)谁来做出购买决策。亚马逊的 Alexa 等人工智能个人零售助理有可能成为品牌向消费者提供的“守门人”,控制向消费者提供哪些品牌信息,并以纯粹的形式购买品牌产品,在人工智能所谓的“自动执行模型”中几乎不需要或根本不需要人为干预,从而有效地将传统的购物体验从“先购物后发货”模式颠覆为“先发货后购物”模式。商标法的许多关键方面都涉及人性的弱点。如果您考虑商标法和实践中的一些“流行词”,例如“混淆”、“不完全记忆”、“联想”和“商标混淆”,这些概念都围绕着人类的弱点。然而,人工智能有可能从购买过程中消除“人性”和“弱点”。人工智能应用程序可以通过“给我买个灯泡”等一般命令来购买产品。人类消费者与人工智能应用程序购买的灯泡品牌没有任何互动。人工智能应用程序会混淆吗?它会混淆商标吗?人工智能应用程序甚至会通过传统的听觉、语音和概念比较商标的方式来评估产品购买,这就是所谓的人工智能黑箱问题吗?人工智能应用程序经常受到个人消费者过去购买决策的影响,而人工智能应用程序做出购买决定或建议的原因有时可能难以理解。在这些情况下,知识产权侵权责任问题也引起了重要的问题。然而,即使人工智能应用程序不做出购买决策,它仍然会影响消费者在做出购买决策时可用的品牌信息。例如,亚马逊 Alexa 平均只向消费者推荐三种产品。它控制着向消费者推荐什么品牌产品,它而不是人类消费者掌握着所有的品牌信息。然而,人工智能对购买过程的影响必须放在历史背景中来看待。人工智能的兴起是新的,但并非史无前例。现代商标法诞生于十九世纪,并发展到现代。然而,在此期间,购买过程并非一成不变,而是发生了变化。我们只需看看从传统的十九世纪“店主”购买产品模式到二十世纪二十年代超市发明的变化,从互联网和社交媒体的兴起到人工智能的兴起。商标法已经适应并发生了变化,实际上可以说是适应性最强的知识产权法形式。例如,关于人工智能应用程序的责任问题,我们已经可以从关键词广告的案例中得到指导,例如谷歌法国,它是随着互联网购物的兴起而发展起来的。如果购买过程中的“参与者”如人工智能应用程序在购买决策/过程中扮演更被动的角色,则人工智能应用程序提供商不太可能被追究责任,如果人工智能应用程序在购买决策中扮演更积极的角色,并且可以说人工智能提供商在购买决策中强烈影响消费者,则更有可能发现责任。商标法已经适应了购买过程的变化,并且它将再次适应。HGF 合伙人兼特许商标律师 Lee Curtis

人工智能如何改变我们做出购买决策的方式?这对商标法意味着什么?商标法的核心在于如何购买商品和服务,而由于人工智能正在影响购买过程,因此从定义上讲它也影响着商标法。人工智能通过两种方式影响购买过程:(a)消费者可获得的品牌信息和(b)谁来做出购买决策。亚马逊的 Alexa 等人工智能个人零售助理有可能成为品牌向消费者提供的“守门人”,控制向消费者提供哪些品牌信息,并以纯粹的形式购买品牌产品,在人工智能所谓的“自动执行模型”中几乎不需要或根本不需要人为干预,从而有效地将传统的购物体验从“先购物后发货”模式颠覆为“先发货后购物”模式。商标法的许多关键方面都涉及人性的弱点。如果您考虑商标法和实践中的一些“流行词”,例如“混淆”、“不完全记忆”、“联想”和“商标混淆”,这些概念都围绕着人类的弱点。然而,人工智能有可能从购买过程中消除“人性”和“弱点”。人工智能应用程序可以通过“给我买个灯泡”等一般命令来购买产品。人类消费者与人工智能应用程序购买的灯泡品牌没有任何互动。人工智能应用程序会混淆吗?它会混淆商标吗?人工智能应用程序甚至会通过传统的听觉、语音和概念比较商标的方式来评估产品购买,这就是所谓的人工智能黑箱问题吗?人工智能应用程序经常受到个人消费者过去购买决策的影响,而人工智能应用程序做出购买决定或建议的原因有时可能难以理解。在这些情况下,知识产权侵权责任问题也引起了重要的问题。然而,即使人工智能应用程序不做出购买决策,它仍然会影响消费者在做出购买决策时可用的品牌信息。例如,亚马逊 Alexa 平均只向消费者推荐三种产品。它控制着向消费者推荐什么品牌产品,它而不是人类消费者掌握着所有的品牌信息。然而,人工智能对购买过程的影响必须放在历史背景中来看待。人工智能的兴起是新的,但并非史无前例。现代商标法诞生于十九世纪,并发展到现代。然而,在此期间,购买过程并非一成不变,而是发生了变化。我们只需看看从传统的十九世纪“店主”购买产品模式到二十世纪二十年代超市发明的变化,从互联网和社交媒体的兴起到人工智能的兴起。商标法已经适应并发生了变化,实际上可以说是适应性最强的知识产权法形式。例如,关于人工智能应用程序的责任问题,我们已经可以从关键词广告的案例中得到指导,例如谷歌法国,它是随着互联网购物的兴起而发展起来的。如果购买过程中的“参与者”如人工智能应用程序在购买决策/过程中扮演更被动的角色,则人工智能应用程序提供商不太可能被追究责任,如果人工智能应用程序在购买决策中扮演更积极的角色,并且可以说人工智能提供商在购买决策中强烈影响消费者,则更有可能发现责任。商标法已经适应了购买过程的变化,并且它将再次适应。HGF 合伙人兼特许商标律师 Lee Curtis

抗癌药物在所有癌症患者中均未得到很好的耐受性

引入近50%的新癌症病例发生在65岁以上的人中,预计到2030年,这一数字将增加到58%。1尽管大多数癌症发生在老年人中,但新的抗癌药物主要是根据年轻人的数据或没有合并症或老年障碍的健康老年人选择的。重要的是,由于体液组成,肝代谢,肾脏和肝排泄以及药效学的改变,抗癌药物的药理学可能会有所不同。这些与年龄相关的药理学差异可能需要适应具有狭窄治疗窗口的抗癌药物的剂量适应性,以最大程度地提高功效并最大程度地减少毒性作用,尤其是对于伴随性疾病或其他老年损害的患者。2

Salton Sea得到了升压,可以敲击广阔的锂供应

(新闻发布 - 立即发布)Salton Sea是北美最大,最多样化的可再生能源机会投资组合的中心,从加利福尼亚州获得了支持,从而从大量的Salton Sea中获得了地热盐水的锂提取。州长加文·纽瑟姆(Gavin Newsom)已由议会议员爱德华多·加西亚(Eduardo Garcia)签署了法律立法,该法律将建立一个蓝带委员会,以制定策略来从地热盐水中提取电池的锂。AB 1657指示加利福尼亚能源委员会(CEC)建立一个由14名成员组成的委员会,以帮助制定一项行动计划,以加快计划和计划,从索尔顿海附近的地热盐水中提取锂。委员会将包括议会议长和参议院规则委员会的任命,还包括公共事业委员会成员,汽车制造业,地热行业和地方政府代表的代表。“萨尔顿海地区的巨大锂储量有可能锚定州的气候目标,同时在该州最经济沮丧的地区之一创造了数千个良好的工会工作。SSA感谢州长采取的行动,以及我们自己的集会筹集者爱德华多·加西亚(Eduardo Garcia)是萨尔顿海毫不掩饰的冠军,他介绍和推进了这项重要的立法。此外,委员会还将建议方法简化与锂相关的设施的允许。委员会将承担的任务是评估可能的联邦,州和地方激励措施,以鼓励对锂提取和潜在锂离子制造业的发展进行经济投资。委员会被指示向州长和立法机关提出建议,以创建有利的监管和投资环境,以从地热中提取锂,并于2022年10月1日之前向州长报告。菲尔·罗森特里特(Phil Rosentrater)表示,CEC致力于开发可再生能源和锂在海洋周围的锂提取,这为更健康,更繁荣的索尔顿海地区带来了新的希望。SSA机构支持合作计划,以开发一个外围湖项目,该项目可以涵盖尘土飞扬的普拉亚,并与娱乐和可再生能源的经济机会恢复栖息地。

b“极值图论的一个核心问题是确定给定图 H 在 \xef\xac\x81x 大小的图中诱导副本的最大数量。这个问题最早由 Pippenger 和 Golumbic [13] 研究,近年来已成为广泛研究的主题 [2, 3, 7, 8, 11, 18]。本文重点关注有向图的类似问题。准确地说,设 H 是有向图。有向图 G 中 H 的诱导密度,表示为 i ( H, G ),是 G 中 H 的诱导副本数量除以 | V ( G ) | | V ( H ) | 。对于整数 n ,设 i ( H, n ) 为所有 n 顶点有向图 G 中 i ( H, G ) 的最大值。H 的诱导性定义为为 i ( H ) = lim n \xe2\x86\x92\xe2\x88\x9e i ( H, n )。当 i ( H, n ) 对于 n \xe2\x89\xa5 2 递减时,此极限存在。只有极少数有向图的可诱导性是已知的。一类重要的例子是有向星号。对于非负整数 k 和 \xe2\x84\x93 ,让有向星号 S k,\xe2\x84\x93 为通过对具有 k + \xe2\x84\x93 叶子的星号的边进行有向图,使得中心具有出度 k 和入度 \xe2\x84\x93 。有向星形是所有边都具有相同方向的定向星形,即星形 S k,\xe2\x84\x93 ,使得 k = 0 或 \xe2\x84\x93 = 0。S 2 , 0 和 S 3 , 0 的可诱导性由 Falgas-Ravry 和 Vaughan [5] 确定。为了解决 [5] 中的一个猜想,Huang [10] 扩展了他们的结果,确定了对所有 k \xe2\x89\xa5 2 的 S k, 0 的可诱导性,表明它是通过对入度为 0 的部分进行不平衡的弧爆破而渐近获得的。注意,由于任何有向图的可诱导性等于通过反转所有弧得到的有向图的可诱导性,因此可以考虑有向星号 S k,\xe2\x84\x93 ,使得 k \xe2\x89\xa5 \xe2\x84\x93 。特别地,Huang 的结果还确定了对所有 \xe2\x84\x93 的 S 0 ,\xe2\x84\x93 的可诱导性。 [10] 的结果未涵盖的最小定向星是 S 1 , 1 ,即三个顶点上的有向路径。Thomass\xc2\xb4e [16,猜想 6.32] 猜想 i ( S 1 , 1 ) = 2 / 5,这是通过四个顶点上的有向环的迭代爆炸获得的。

b“极值图论的一个核心问题是确定给定图 H 在 \xef\xac\x81x 大小的图中诱导副本的最大数量。这个问题最早由 Pippenger 和 Golumbic [13] 研究,近年来已成为广泛研究的主题 [2, 3, 7, 8, 11, 18]。本文重点关注有向图的类似问题。准确地说,设 H 是有向图。有向图 G 中 H 的诱导密度,表示为 i ( H, G ),是 G 中 H 的诱导副本数量除以 | V ( G ) | | V ( H ) | 。对于整数 n ,设 i ( H, n ) 为所有 n 顶点有向图 G 中 i ( H, G ) 的最大值。H 的诱导性定义为为 i ( H ) = lim n \xe2\x86\x92\xe2\x88\x9e i ( H, n )。当 i ( H, n ) 对于 n \xe2\x89\xa5 2 递减时,此极限存在。只有极少数有向图的可诱导性是已知的。一类重要的例子是有向星号。对于非负整数 k 和 \xe2\x84\x93 ,让有向星号 S k,\xe2\x84\x93 为通过对具有 k + \xe2\x84\x93 叶子的星号的边进行有向图,使得中心具有出度 k 和入度 \xe2\x84\x93 。有向星形是所有边都具有相同方向的定向星形,即星形 S k,\xe2\x84\x93 ,使得 k = 0 或 \xe2\x84\x93 = 0。S 2 , 0 和 S 3 , 0 的可诱导性由 Falgas-Ravry 和 Vaughan [5] 确定。为了解决 [5] 中的一个猜想,Huang [10] 扩展了他们的结果,确定了对所有 k \xe2\x89\xa5 2 的 S k, 0 的可诱导性,表明它是通过对入度为 0 的部分进行不平衡的弧爆破而渐近获得的。注意,由于任何有向图的可诱导性等于通过反转所有弧得到的有向图的可诱导性,因此可以考虑有向星号 S k,\xe2\x84\x93 ,使得 k \xe2\x89\xa5 \xe2\x84\x93 。特别地,Huang 的结果还确定了对所有 \xe2\x84\x93 的 S 0 ,\xe2\x84\x93 的可诱导性。 [10] 的结果未涵盖的最小定向星是 S 1 , 1 ,即三个顶点上的有向路径。Thomass\xc2\xb4e [16,猜想 6.32] 猜想 i ( S 1 , 1 ) = 2 / 5,这是通过四个顶点上的有向环的迭代爆炸获得的。

人工智能能否重新编程新闻编辑室?自动化新闻中的信任、透明度和道德 计算机程序能否撰写引人入胜的新闻报道?路透社最近发布的《技术趋势与预测》报告中显示,在接受调查的 200 名数字领袖、编辑和首席执行官中,78% 表示投资人工智能 (AI) 技术将有助于确保新闻业的未来 (Newman, 2018)。然而,探索这些新的报道方法给那些已经在努力理解人类记者和计算工作之间复杂动态的人们带来了一系列无法预料的道德问题。在新闻编辑室实施自动化叙事向记者提出了一些问题:如何保持和鼓励报道的准确性和公正性,以及对他们所服务的受众的透明度。新闻编辑室的人工智能已经从一个想法发展成为现实。 1998 年,计算机科学家 Sung-Min Lee 预测人工智能将在新闻编辑室得到应用,届时“机器人代理”将与人类记者一起工作,有时甚至代替人类记者工作 (Latar, 2015)。2010 年,Narrative Science 成为第一家利用人工智能将数据转化为叙事文本的商业企业。Automated Insights 和其他公司紧随 Narrative Science 之后,通过自动叙事将 Lee 的“机器人代理”带入新闻编辑室。虽然当今的新闻编辑室正在使用人工智能来简化各种流程,从跟踪

人工智能可以重新编程新闻编辑室吗?自动化新闻中的信任、透明度和道德 计算机程序可以编写引人入胜的新闻故事吗?在路透社最近的一份技术趋势和预测报告中,接受调查的 200 名数字领导者、编辑和首席执行官中,78% 表示投资人工智能 (AI) 技术将有助于确保新闻业的未来 (Newman, 2018)。然而,探索这些新的报道方法,为那些已经在努力理解人类记者和计算工作之间复杂动态的人带来了一系列无法预见的道德问题。在新闻编辑室实施自动化叙事向记者提出了如何保持和鼓励报道的准确性和公正性以及对他们所服务的受众的透明度的问题。新闻编辑室中的人工智能已经从一个想法发展成为现实。1998 年,计算机科学家 Sung-Min Lee 预测人工智能将在新闻编辑室得到应用,届时“机器人代理”将与人类记者一起工作,有时甚至代替人类记者 (Latar, 2015)。2010 年,Narrative Science 成为第一家使用人工智能将数据转化为叙事文本的商业企业。Automated Insights 和其他公司紧随 Narrative Science 之后,通过自动化讲故事的方式将 Lee 的“机器人代理”带入新闻编辑室。虽然当今的新闻编辑室正在使用人工智能来简化各种流程,从跟踪突发新闻、收集和解释数据、核实在线内容,甚至创建聊天机器人来向用户推荐个性化内容,但自动生成文本和视频故事的能力促使整个行业转向自动化新闻,或“使用软件或算法自动生成新闻故事而无需人工干预的过程”(Graefe, 2016)。《福布斯》、《纽约时报》、《华盛顿邮报》、《ProPublica》和彭博社只是当今在新闻报道中使用人工智能的部分新闻编辑室。《华盛顿邮报》的“内部自动化叙事技术”Heliograf 只是新闻编辑室利用人工智能扩大其在体育和金融等严重依赖结构化数据的领域的报道的众多例子之一,“让记者专注于深入报道”(Gillespie,2017 年)。人工智能有可能让新闻编辑室和报摊的记者都变得更好。通过自动化,现在可以进行大量的新闻报道新闻智库 Polis 在其 2019 年新闻 AI 报告中透露,新闻编辑室使用人工智能的主要动机是“帮助公众应对新闻过载和错误信息的世界,并以便捷的方式将他们与与他们的生活相关、有用和有益的可靠内容联系起来”(Beckett,2019 年)。

谁得到什么?再分配的政治经济学

《2020 年世界社会报告:快速变化世界中的不平等》承认,动员对促进更大平等的政策的支持可能会很困难。然而,报告也指出了减少不平等的政治行动途径(联合国,2020 年)。本简报探讨了再分配的障碍以及政府如何为公平变革创造有利环境。再分配的障碍不平等是一个主要问题。2014 年,在 44 个发达国家和发展中国家的调查中,60% 的受访者同意“贫富差距是他们国家面临的一个非常大的问题”(皮尤研究中心,2014 年)。加剧的不平等可能导致富有的个人、团体或企业集中政治影响力。强大团体反对进一步再分配,使减少不平等变得困难,从而形成了财富和政治权力集中的循环。这些团体能够更好地影响政策,方法是游说政客、动员同僚阻止措施或影响公众对再分配政策的看法。例如,那些可能从改革中受益或受损的人可能被描述成特定的样子,如“不值得帮助的穷人”和“创造就业机会的富人”,这些特征可以用来影响公众舆论。即使得到普遍支持扩大再分配,减少不平等的具体政策也可能难以起步。税收很少受到普遍欢迎,当税收和转移支付无法减少不平等时更是如此——正如近年来许多发达国家的情况一样。至关重要的是,儿童福利或社会养老金等再分配政府计划的预算不是固定的,部分取决于公众支持。例如,针对贫困人口的政策可能被视为

法国国家信息技术研究所 (Inria) 和德国人工智能研究中心 (DFKI) 签署人工智能合作谅解备忘录 在《亚琛条约》签署一周年之际,法国国家信息技术研究所 (Inria) 和德国人工智能研究中心 (DFKI) 签署了谅解备忘录。 签署仪式将于萨尔布吕肯的 Power4Production 创新实验室举行,萨尔州总理托比亚斯·汉斯 (Tobias Hans) 和莱茵兰-普法尔茨州联邦政府代表兼欧洲媒体和数字事务国务秘书海克·拉布 (Heike Raab) 出席。 凯泽斯劳滕、巴黎、萨尔布吕肯,2020 年 1 月 22 日 法国和德国于 2019 年 1 月 22 日签署的《亚琛条约》为法德合作注入了新的动力,并强调了在人工智能 (AI) 领域的伙伴关系。 在此框架内,Inria 和 DFKI 现已同意通过构建和正式化合作,大大加强在人工智能领域的合作。因此,Inria 和 DFKI 将于今天签署谅解备忘录。部长 Tobias Hans 表示:“DFKI 和 INRIA 已经就欧洲人工智能和数字主权的机遇和挑战制定了共同愿景。这两家国际知名研究机构的密切合作是朝着使萨尔州和法国成为欧洲驱动力和人工智能等未来技术中心迈出的开创性一步。这一发展还表明,萨尔州作为 IT 中心具有特殊的意义和吸引力,我们旨在加强与法国合作伙伴合作的法国战略正在取得成果。”国务秘书海克·拉布 (Heike Raab) 指出:“德国和法国也非常重视人工智能研究和开发。人工智能造福人类是这一共同价值观的核心。我很高兴 DFKI 和 Inria 作为两家国际上非常重要的研究机构,将通过签署这份谅解备忘录进一步加强合作。对于凯泽斯劳滕基地来说,这意味着在机器学习和深度学习领域的合作将得到扩大。这些是 DFKI 在凯泽斯劳滕已经拥有国际认可的专业知识的主题,通过合作将进一步加强这些专业知识。” Inria 首席执行官 Bruno Sportisse 表示:“DFKI 和 Inria 之间的这份谅解备忘录体现了继《亚琛条约》和最近的图卢兹会议之后,法德在欧洲动态中就人工智能展开合作的势头。我们致力于人工智能的国家计划促进了两国研究机构之间的双边伙伴关系。DFKI 和 Inria 对人工智能有着相似而开放的愿景,这为加强我们在双边和欧洲层面上的具体项目上的伙伴关系铺平了新的机会。”DFKI 首席执行官 Antonio Krüger 解释说:“Inria 和 DFKI 之间的这份谅解备忘录表明,我们不仅正在讨论法德人工智能合作,而且还在积极协调研究和确定联合项目。我们期待着合作,因为我们将法国和德国对人工智能的愿景结合在一起,造福人民和社会。在这两个国家,都已启动了填补“人工智能”空白的项目

法国国家信息技术研究所 (Inria) 和德国人工智能研究中心 (DFKI) 签署人工智能合作谅解备忘录 在《亚琛条约》签署一周年之际,法国国家信息技术研究所 (Inria) 和德国人工智能研究中心 (DFKI) 签署了谅解备忘录。 签署仪式将于萨尔布吕肯的 Power4Production 创新实验室举行,萨尔州总理托比亚斯·汉斯 (Tobias Hans) 和莱茵兰-普法尔茨州联邦政府代表兼欧洲媒体和数字事务国务秘书海克·拉布 (Heike Raab) 出席。 凯泽斯劳滕、巴黎、萨尔布吕肯,2020 年 1 月 22 日 法国和德国于 2019 年 1 月 22 日签署的《亚琛条约》为法德合作注入了新的动力,并强调了在人工智能 (AI) 领域的伙伴关系。 在此框架内,Inria 和 DFKI 现已同意通过构建和正式化合作,大大加强在人工智能领域的合作。因此,Inria 和 DFKI 将于今天签署谅解备忘录。部长 Tobias Hans 表示:“DFKI 和 INRIA 已经就欧洲人工智能和数字主权的机遇和挑战制定了共同愿景。这两家国际知名研究机构的密切合作是朝着使萨尔州和法国成为欧洲驱动力和人工智能等未来技术中心迈出的开创性一步。这一发展还表明,萨尔州作为 IT 中心具有特殊的意义和吸引力,我们旨在加强与法国合作伙伴合作的法国战略正在取得成果。”国务秘书海克·拉布 (Heike Raab) 指出:“德国和法国也非常重视人工智能研究和开发。人工智能造福人类是这一共同价值观的核心。我很高兴 DFKI 和 Inria 作为两家国际上非常重要的研究机构,将通过签署这份谅解备忘录进一步加强合作。对于凯泽斯劳滕基地来说,这意味着在机器学习和深度学习领域的合作将得到扩大。这些是 DFKI 在凯泽斯劳滕已经拥有国际认可的专业知识的主题,通过合作将进一步加强这些专业知识。” Inria 首席执行官 Bruno Sportisse 表示:“DFKI 和 Inria 之间的这份谅解备忘录体现了继《亚琛条约》和最近的图卢兹会议之后,法德在欧洲动态中就人工智能展开合作的势头。我们致力于人工智能的国家计划促进了两国研究机构之间的双边伙伴关系。DFKI 和 Inria 对人工智能有着相似而开放的愿景,这为加强我们在双边和欧洲层面上的具体项目上的伙伴关系铺平了新的机会。”DFKI 首席执行官 Antonio Krüger 解释说:“Inria 和 DFKI 之间的这份谅解备忘录表明,我们不仅正在讨论法德人工智能合作,而且还在积极协调研究和确定联合项目。我们期待着合作,因为我们将法国和德国对人工智能的愿景结合在一起,造福人民和社会。在这两个国家,都已启动了填补“人工智能”空白的项目

大型水电和径流资源是否得到最大限度利用?

Andrew Rowe 博士是综合能源系统研究所所长,也是加拿大维多利亚大学机械工程系教授。他曾担任加拿大海军工程官,负责推进、发电和辅助系统的运行和维护。他获得了燃料电池性能建模研究硕士学位,并继续攻读热泵和氢液化磁循环博士学位。他目前的研究领域包括能源系统分析、热量循环、电气化、氢系统和储能。Rowe 博士是《Cryogenics》杂志编辑委员会成员、THERMAG 科学委员会成员、不列颠哥伦比亚省注册专业工程师和电化学学会成员。注册方式:https://www.eventbrite.ca/e/oil-part-two-tickets-85419466925。学生可以通过电子邮件 uvraevents@uvic.ca 免费注册

密苏里州安全睡眠战略计划由 NICHQ 制定,并得到密苏里州安全睡眠联盟的认可。

密苏里州安全睡眠联盟由密苏里州社会服务部 (DSS) 儿童部 (CD) 于 2016 年底发起,专门关注婴儿的安全睡眠。该联盟的主要目标是通过加强教育、意识、实践和培训,大幅减少和消除密苏里州因不安全的睡眠环境和习惯而导致的伤害和死亡。密苏里州安全睡眠联盟的成员来自社会服务部、卫生和老年服务部 (DHSS)、儿童信托基金 (CTF)、婴儿死亡资源、儿童权益办公室、儿童慈善医院、Generate Health St. Louis、圣弗朗西斯医疗保健系统、新生儿护士、SSM Health 和美国儿科学会 (AAP) 密苏里分会。联盟成员定期开会分享专业知识,并共同努力在全州范围内制定、支持和传播一致的安全睡眠信息。

![b“极值图论的一个核心问题是确定给定图 H 在 \xef\xac\x81x 大小的图中诱导副本的最大数量。这个问题最早由 Pippenger 和 Golumbic [13] 研究,近年来已成为广泛研究的主题 [2, 3, 7, 8, 11, 18]。本文重点关注有向图的类似问题。准确地说,设 H 是有向图。有向图 G 中 H 的诱导密度,表示为 i ( H, G ),是 G 中 H 的诱导副本数量除以 | V ( G ) | | V ( H ) | 。对于整数 n ,设 i ( H, n ) 为所有 n 顶点有向图 G 中 i ( H, G ) 的最大值。H 的诱导性定义为为 i ( H ) = lim n \xe2\x86\x92\xe2\x88\x9e i ( H, n )。当 i ( H, n ) 对于 n \xe2\x89\xa5 2 递减时,此极限存在。只有极少数有向图的可诱导性是已知的。一类重要的例子是有向星号。对于非负整数 k 和 \xe2\x84\x93 ,让有向星号 S k,\xe2\x84\x93 为通过对具有 k + \xe2\x84\x93 叶子的星号的边进行有向图,使得中心具有出度 k 和入度 \xe2\x84\x93 。有向星形是所有边都具有相同方向的定向星形,即星形 S k,\xe2\x84\x93 ,使得 k = 0 或 \xe2\x84\x93 = 0。S 2 , 0 和 S 3 , 0 的可诱导性由 Falgas-Ravry 和 Vaughan [5] 确定。为了解决 [5] 中的一个猜想,Huang [10] 扩展了他们的结果,确定了对所有 k \xe2\x89\xa5 2 的 S k, 0 的可诱导性,表明它是通过对入度为 0 的部分进行不平衡的弧爆破而渐近获得的。注意,由于任何有向图的可诱导性等于通过反转所有弧得到的有向图的可诱导性,因此可以考虑有向星号 S k,\xe2\x84\x93 ,使得 k \xe2\x89\xa5 \xe2\x84\x93 。特别地,Huang 的结果还确定了对所有 \xe2\x84\x93 的 S 0 ,\xe2\x84\x93 的可诱导性。 [10] 的结果未涵盖的最小定向星是 S 1 , 1 ,即三个顶点上的有向路径。Thomass\xc2\xb4e [16,猜想 6.32] 猜想 i ( S 1 , 1 ) = 2 / 5,这是通过四个顶点上的有向环的迭代爆炸获得的。](/simg/b/ba28460dd1b06d9996628290aa73355077ae7e14.webp)