XiaoMi-AI文件搜索系统

World File Search System我们永远不会忘记你

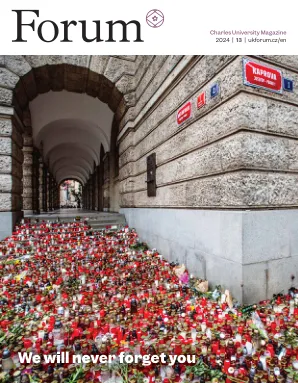

一年过去了,但是这些话仍然不容易出现。是在圣诞节假期之前的2023年12月21日,查尔斯大学的艺术学院成为了前所未有的悲剧的所在地。那天,我们的十二名学生和两名老师在学校枪击中丧生。袭击带来了深刻的悲伤,使我们伤心欲绝。即使是现在,也很难相信可能发生这样的事情。那天的痛苦仍然与我们同在,我们将永远不会忘记那些失去的人。该版本的《大学杂志》献给了他们,他们的家族和最了解他们的人的致敬。我们对他们的最深切同情和尊重,以及所有在袭击中受伤的人。康复的旅程非常困难 - 特别是对于那些失去亲人的人。在大学里,回到日常生活并恢复正常感一直是缓慢而挑战性的。虽然震撼了,但我们仍然保持韧性。在一起,我们将作为一个社区近在咫尺,

助记符——如何记住而不忘记

选修课程在夏季学期进行。学生只能报名参加一门选修课程。所有课程主题和学分均通过华沙医科大学的电子学习平台 eWUM (e learning.wum.edu.pl) 完成。无限数量的学生可以参加选修课程。材料将于 2025 年 2 月 24 日起在夏季学期 (第 1 版) 中按顺序提供。选修课程将于 2025 年 6 月 15 日完成。选修课程成绩基于总结性测试和其他电子学习活动中获得的分数。每位参与者有两次测试机会,得分较高的将获得奖励。

动态量子记忆如何忘记

最近有人争辩说,低维(甚至是一维)量子系统,将局部电路与局部测量结果混合在一起,可以充当量子记忆[1-7]。如果记录了测量结果的结果,则此过程可以保护非平凡的量子信息。在这里,我们研究了此过程的长期动态,以了解系统最终如何“忘记”,即,是否使用系统来存储量子信息,以及这些测量结果一定如何丢失信息。为了研究这种长时间的动态,我们忽略了空间结构。该系统仅由一个高尺寸n的单个希尔伯特空间组成,n均为n。我们的模型包括交替进行两个不同的步骤:第一,一个单一的演变,然后测量单个信息1,由等级N/ 2投影仪表示。我们还可以选择通过单一结合测量结果,因此可以通过在每个步骤中测量单个信息来描述模型,每次测量基础都会改变。因此,如果我们通过统一u 1演变,则测量投影仪P 1,然后按单位u 2进化,然后测量投影仪P 2,这是等效的,直至总体统一,以测量投影仪u†1 p 1 u 1,然后测量投影仪u†1 u†1 u†1 u†2 p 2 u 2 u 2 u 1。我们通过写下测量结果来跟踪量子轨迹,因此尤其是纯状态总是沿着此类轨迹演变为纯状态。我们考虑两个不同的情况,即我们称“多体”和“自由费米昂”。在多体案例中,被选为随机的单位。术语“多体”有点误称:我们有一些固定的高维希尔伯特空间,也许是通过张紧许多量子的量形成的,因此更好的术语可能是“高维单体”。尽管如此,我们仍然坚持使用多体一词。特别是,人们可能希望可以通过我们的HAAR随机测量值对张量的张量产物的足够深的量子电路进行[8-10]。在自由效率的情况下,希尔伯特空间是费米子的一个小空间,只允许测量为fermion biinears。

对生成数据的培训使模型忘记

稳定的扩散从描述性文本彻底改变了图像创建。GPT-2,GPT-3(.5)和GPT-4在各种语言任务中表现出惊人的表现。chatgpt向公众介绍了此类语言模型。现在很明显,大型语言模型(LLMS)将留在这里,并且会在整个在线文本和图像的生态系统中产生巨大的变化。在本文中,我们考虑未来可能会有什么。一旦LLM在网上找到大部分语言,GPT- {N}会发生什么?我们发现,在训练中使用模型生成的内容会导致不可逆的缺陷,其中原始内容分布的尾巴消失了。我们将这种效果称为模型崩溃1,并表明它可以在变异自动编码器,高斯混合模型和LLM中发生。我们建立了这种现象背后的理论直觉,并在所有学到的生成模型中描绘了它的普遍性。我们证明,如果我们要维持从网络上刮除的大规模数据培训的好处,则必须认真对待它。的确,在LLMS在从Internet爬网的数据中产生的内容的存在下,收集到有关人类与系统的真正人类互动的数据的价值将变得越来越有价值。

忘记 CHATGPT:如何在本地运行 AI ...

histo.fyi 网站是一个免疫系统蛋白质结构数据库,称为主要组织相容性复合体 (MHC) 分子。它包括图像、数据表和氨基酸序列,由生物信息学家 Chris Thorpe 运营,他使用称为大型语言模型 (LLM) 的人工智能 (AI) 工具将这些资产转换为可读摘要。但他不使用 ChatGPT 或任何其他基于网络的 LLM。相反,Thorpe 在他的笔记本电脑上运行人工智能。在过去几年中,基于 LLM 的聊天机器人因其写诗或参与对话的能力而赢得了赞誉。一些 LLM 有数千亿个参数——参数越多,复杂性越大——并且只能在线访问。但最近出现了两种趋势。首先,组织正在做出

学习学习而不会忘记使用

持续学习(CL)是指通过在保留先前学习的经验的同时容纳新知识来不断学习的能力。虽然这个概念是人类学习固有的,但当前的机器学习方法很容易覆盖以前学习的作品,因此忘记了过去的经验。相反,应选择性地和仔细地更新模型参数,以避免不必要的遗忘,同时最佳利用先前学习的模式以加速未来的学习。由于很难手工制作有效的更新机制,因此我们提出了元学习基于变压器的优化器来增强CL。此元学习优化器使用ATTENITION来学习跨任务流的模型参数之间的复杂关系,并旨在为当前任务生成有效的重量更新,同时防止对先前遇到的任务的灾难性遗忘。在基准数据集上进行评估,例如SplitMnist,RotatedMnist和SplitCifar-100,即使在较小的标记数据集中,也肯定了所提出的方法的疗效,即使在连续学习框架内集成了元学习优化器的优势。

汗水,所以您不要忘记学习问题

专注的思想有助于学习。不幸的是,头脑很容易分心。现代教室要归咎于现代教室,里面充满了电子设备(以及它们的不懈通知),这些设备可以吸引学生的注意力(Ma等,2020; May&Elder,2018; Shelton等,2009)。但是,思想无法保持专注也是刻苦的。“思维徘徊”一词用于描述大脑的默认模式。当学习者变得疲倦或无聊时,他们的大脑会恢复到其默认模式,这使思想可以徘徊在内部思想,将我们带回过去或向前发展;除了现在和现在的任何地方(Smallwood&Schooler,2006年)。据估计,学生大约花了大约30%的思维徘徊(Kane等,2007; Lindquist&McLean,2011; Szpunar等,2013),他们的大部分思想在学习或在课堂上进行了徘徊(Unsworth等人,2012年)。当学生的思想在徘徊时,他们不太可能正在学习手头的任务。考虑此情况:

在机器人情节长期记忆中忘记

摘要 - 人工认知体系结构传统上依靠复杂的记忆模型来编码,存储和检索信息。但是,将所有数据从工作记忆(WM)转移到长期内存(LTM)的常规实践导致高度数据量和有效的信息处理和访问的挑战。确定在机器人LTM中保留或丢弃的信息尤其具有挑战性,因为缺乏有关未来数据利用的知识。从人类忘记本文中汲取灵感,并评估只有在遇到新信息时,才能在机器人的LTM中巩固新颖的遗忘技术。所提出的方法结合了在数据传输到机器人LTM期间的快速过滤,而较慢,更精确的遗忘机制,这些机制会定期评估LTM内部的离线数据删除。我们比较了不同的机制,利用指标,例如数据相似性,数据年龄和合并频率。通过比较两个ARMAR机器人在其LTM中搜索过去的对象位置中以情节为中心的自我图像和机器人状态数据中搜索过去对象位置的任务,可以评估忘记技术的功效。实验结果表明,我们的遗忘技术大大降低了机器人LTM的空间要求,同时保持其成功执行依靠LTM信息的任务的能力。值得注意的是,基于相似性的遗忘方法的表现优于基于频率和时间的方法。与使用单个遗忘策略相比,基于在线频率的,基于在线相似性,基于离线相似性和基于时间的衰减方法的组合显示出卓越的性能。

适应不忘记的适应:视觉模型中的双重教师的蒸馏

摘要。多模式模型(例如剪辑)具有显着的零拍传输功能,使其在不断学习任务方面非常有效。然而,这种优势因灾难性遗忘而严重损害了这一优势,这破坏了这些模型的宝贵零击学习。现有方法主要集中于保存零拍的功能,但在完全利用多模式模型中固有的丰富模态信息方面通常不足。在本文中,我们提出了一种策略,以增强零射击转移能力和对新数据分布的适应性。我们引入了一种新型的基于图的多模式接近蒸馏方法,该方法保留了视觉和文本方式的内部和模式间信息。通过样本重新加权机制进一步增强了这种方法,并动态调整教师对每个样本的影响。实验结果证明了对现有方法的有很大改善,这说明了所提出的方法在持续学习领域的有效性。代码可在github.com/myz--ah/awoforget上找到。

国家不会忘记也不会原谅 - 伊斯兰堡邮报

伊斯兰堡:陆军参谋长赛义德·阿西姆·穆尼尔将军周四表示,国家不会原谅也不会忘记那些亵渎烈士纪念碑、损害其尊严的人,这种行为是不能容忍的。据三军公共关系部 (ISPR) 新闻稿称,陆军参谋长在访问这里的警察防线期间,向烈士家属发表讲话时发表了这些讲话,当时他正在参加巴基斯坦烈士纪念日 (Youm-e-Takreem-e-Shu- hada-e-Pakistan)。主要活动在拉瓦尔品第总部 (GHQ) 举行,陆军参谋长阿西姆·穆尼尔将军作为主宾。在仪式上,人们向烈士致以深切的敬意,知名人士在烈士纪念碑前献花。参加仪式的人员包括前陆军参谋长卡马尔·贾维德·巴杰瓦将军(已退役)、前参谋长联席会议主席纳迪姆·拉扎将军(已退役)、巴基斯坦板球队队长巴巴尔·阿扎姆、穆夫提·穆尼布·乌尔·拉赫曼和其他社会成员。除此之外,全国各地还组织了众多以诵读《古兰经》和祈祷为特色的活动。此外,还将在烈士纪念碑举行几场纪念仪式。