机构名称:

¥ 1.0

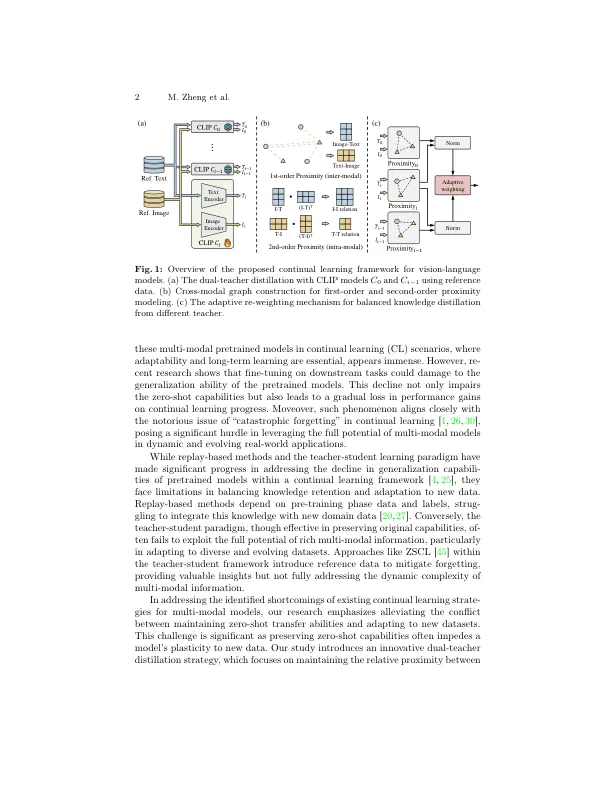

摘要。多模式模型(例如剪辑)具有显着的零拍传输功能,使其在不断学习任务方面非常有效。然而,这种优势因灾难性遗忘而严重损害了这一优势,这破坏了这些模型的宝贵零击学习。现有方法主要集中于保存零拍的功能,但在完全利用多模式模型中固有的丰富模态信息方面通常不足。在本文中,我们提出了一种策略,以增强零射击转移能力和对新数据分布的适应性。我们引入了一种新型的基于图的多模式接近蒸馏方法,该方法保留了视觉和文本方式的内部和模式间信息。通过样本重新加权机制进一步增强了这种方法,并动态调整教师对每个样本的影响。实验结果证明了对现有方法的有很大改善,这说明了所提出的方法在持续学习领域的有效性。代码可在github.com/myz--ah/awoforget上找到。

适应不忘记的适应:视觉模型中的双重教师的蒸馏

主要关键词