XiaoMi-AI文件搜索系统

World File Search System通过表面增强拉曼光谱的去甲肾上腺素和肾上腺素的歧视性和定量分析,用金纳米颗粒悬浮液

Antoine Dowek,Marion Berge,Patrice Prognon,François-Xavier Legrand,Eric Larquet,Eric Larquet等。通过表面增强红色纳米粒子悬架的Raman光谱,对去甲肾上腺素和肾上腺素进行了分解和定量分析。分析和生物分析化学,2021,414(2),pp.1163-1176。10.1007/S00216-021-03743-4。hal-04664781

骚扰和歧视决策者和上诉官培训

对于据称发生在2024年9月23日之前发生的行为,2020年的法规永久适用接收者将需要维护/更新符合2020年法规和2024年法规的政策,程序和培训

<工作场所中的dorithmic歧视... div>

摘要:本文分析了可以通过使用计算机算法(尤其是结合人工智能技术的计算机算法)给出的歧视的潜在歧视途径。 div>提出了有关该技术的一般考虑,然后提出了一般,特别是在工作场所中发生的歧视场景。 div>目的是提出各个方面,这些方面在使用该技术时要谨慎,以便可以统一的各种利益。 div>在分析了我们的法律体系如何应对这一现象之后,它以一系列原则和“良好实践”的结论可以纳入我们的立法。 div>作为工作方法,比较,分析,法律和推论。 div>

歧视性和一致表示蒸馏

知识蒸馏(KD)旨在将知识从大型教师模型转移到较小的学生模型。虽然对比学习通过创建歧视性表示表现出了在自我监督学习中的希望,但其在知识蒸馏中的信息仍然有限,并且主要涉及歧视,忽略了教师模型捕获的结构关系。为了解决这一限制,我们提出了d Iscriminative and C On Consistent d Istillation(DCD),它采用了对比损失以及一致性正规化,以最大程度地减少教师和学生代表分布之间的差异。我们的方法引入了在训练过程中适应这些互补目标的可学习温度和偏置参数,以取代对比度学习方法中常用的固定超平衡器。通过CIFAR-100和Imagenet ILSVRC-2012的广泛实验,我们证明DCD实现了状态的表现,学生模型有时会超过教师的准确性。此外,我们表明DCD的所学表示形式将转移到小型成像网和STL-10 1时表现出较高的跨数据集泛化。

可再生能源的歧视性拍卖设计

负担得起的可再生能源是世界各地经济体经济体本身以及通过行业耦合间接脱碳的基石(Brown等,2018,Hansen等,2019)。尽管可再生能源与化石燃料的电力来源达到了成本均衡(Kost等人,2021年),但他们继续需要针对化石燃料市场价格的贬低,以维持低融资成本并增加部署量以满足气候目标。这种投资的贬低通常是通过监管机构拍卖的长期合同来完成的(DelRío和Kiefer,2021年)。此类拍卖被认为是为公共长期合同分配可再生能源的有效工具,因为它们将成本效率和市场整合归为基础。此外,它们应该减少调节器和竞标者之间的信息不对称性(Bruttel等,2016)。在这些拍卖中,将电力消费者的成本降至最低是政府的重要目标,因为消费者的电力成本会影响经济各个部门的过渡成本。尤其如此,因为能源成本是回归性的(Haan和Simmler,2018年),欧洲可再生能源支持的年度成本超过400亿欧元(Busch等,2023),而2022年能源危机表明,高能源价格的政治争议(Fabra,2023)。

AI和偏见:解决机器中的歧视...

$ k65)。 (46/(+ $ 0+!。(&0&8&)“+1/(6”&#6/86:+1/b&)/+1/'“#$%&'$(!。(&0&8&)“+ 1/(6“”&#6/86+ o!1p+ a)'+ B.)4)(&8)“ G+(。/'0 $ .46B+ s)。 &$ - '+ '68($。':+ 6/a)/86b+ b68&'&$/u 4)i&/#+ 5。 $ 86'6 '+)/B+)-($ 4) (&/#+8 $ 45 "6t+()' i'j+k6'5 & (6+& ('+5 $ (6/(&)"+F6/60 & (':+(A6+B65 "$ G46/(+$ 0+ 4) 8A &/6+"6) ./&/#+)"#$. & (A4 '+a)'+)&'6b+'&#/&0&0&8)/(+8 $/86 ./'+6#)。 b&#+f&)'+)/b+b&'8。&/)(&$/j+@a&'+5)56。+b6“ s6'+&/($+($ 4-”(a6+4-“(&0)86(6b+$。&#&#&/'+$ 0+$ 0+$ 0+$ f&+f&+&/+!1+&b)++a+a+a+a+a+a+a+'; h+(a6'6+。)4)/&06'(+&/+6)“ uh $。“ b+)55”&8)(&$/'+)/b+(a6&。+&45“&8)&8)(&$/'+0 $。+'$ 8&6()”+6v-&(gj+wg+)/)“ gl&/#+8)'gl&/#+8) &/'x'-8a+)'+a6)a&#a”&#a('+(a6+b6(a6+b6((a6.4 $ .6:+(a6+ 5)56。+ 5。$ 5 $'6'6'+)8(&$/)f“ 6+'(。)(6#&6'+ 0 $。+ 4&(&#)(&/#+ f&)':+&/8“ -b&/#+ b&s6。'6+ b)()+8 $“” 68(&$/:+)“#$。&(a4&8+) - b&/#:+)/b+(a6+6'()'6+)。 $ - /b+! 1:+(a&'+ 5)56。+ 645a)'&l6'+(a6+ 8。&(8)“+/66b+ 0 $。+ 6(a&8)(a&8)”+ 8 $/'&b6。)(&$/':+&/8“ - '&s&(g:+)/b+(。/'5).6/8G+&/+(A6+B6S6“ $ 546/(+)/B+B65” $ G46/(+$ 0+4)8a&/6+“ 6)./&&&&&&&&&&&&&&&&&&&&&#&#” $'(6。+)+4 $ .6+6v-&()f“ 6+!1+”)/b'8)56+(a)(+'6.s6'+)“”+464f6。“ gj + +!“#$%&'() +!“#$%$&$'() *+#,(($ - ,+&,。)/'&0 $+,)1,'“+$+ - 。)< /div>2 $'3.)4 $ 3&“ $ 5 $+'#$ 6+)4'#')2 $'3.)(-6“ $#05 $&)2 $'> 6(&$ 6+。)a,“ a6($&&&&&$&$&$&$+。)8C:$#<)++)!*。)!*)80 $&3。)d“'so,+&6:+#'f $($#<。)'+=)?#

计算机拒绝时:欧洲对算法歧视的法律回应

近年来,对算法系统部署而产生的基本权利的侵犯的担忧已有所增加。尤其是全球研究表明,在各种决策过程中使用的算法系统可以区分受合法保护的群体。例如,在具有里程碑意义的决定中,意大利法庭迪·博洛尼亚(Di Bologna)发现,交付平台使用的代名词排名算法是使骑手访问骑手可以访问用于预订工作转变的系统是间接歧视的。2在确定哪些骑手优先级时,该系统构建了其“可靠性”和“参与”的量度,这些量度没有考虑到合法保护的原因,例如罢工,疾病,疾病,残疾,个人信仰或护理职责(仍然由多数妇女执行)。通过不公平地对待所有工作转移的取消,该系统不公平地限制了骑手的工作机会。在奥地利,所谓的“ AMS”算法是由国家就业机构委托授权或拒绝求职者支持的,基于他们找到就业机会的预测。研究人员表明,在某些版本中,预测系统对女性求职者的负重分配了负重(尤其是当他们有护理职责时3),并且考虑到诸如候选人的迁移背景,健康障碍和年龄等特征,从而使该系统可能会歧视合法受保护的群体(Kayser-Bril,2019年; 2019年; Alhutter et alhutter et alhutter et alhutter et alhutter et 2020)。研究揭示了欧洲算法歧视的许多其他例子(有关最近的概述,请参见Wulf,2022年)。在一定程度上,欧洲制定的反歧视法可以解决算法歧视。然而,关于这些法律的解释和应用,出现了棘手的问题。现有立法还表现出差距和缺点,尤其是在机器学习系统的背景下。本章研究了这些问题,并提出了如何在算法社会中执行平等的反思。这样做,它首先仔细检查了算法歧视的根和机制,并提出了工作定义,目的是消除现有的语义混乱。第二,本章研究了现有的反歧视法律框架的缺点,并区分了监管,概念,教义和程序差距。最后,本章提出了对执行(算法)平等的一些思考。这样做,本章反映了根据算法歧视的问题,对法律框架的不同可能解释的规范含义。

使用现象细胞绘画和多机械染色试剂盒的表型歧视。

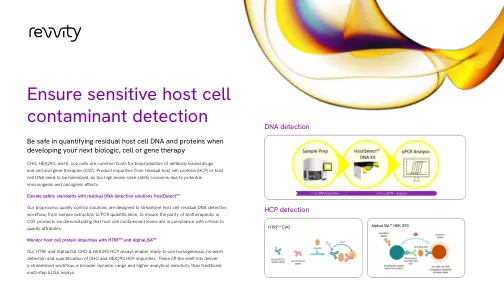

我们的hostDetect CHO(DXMDX-RGT-1003),HEK293(DXMDX-RGT-1004)和E.COLI(DXMDX-RGT-1005)PCR DNA量化集成了Chemagic™DNA DNA DNA提取和实时PCR技术,可从示例中提供无缝的工作流程,而不是3小时。受益于简化的检测过程,该过程有助于加速生物制剂或CGT产品开发和纯化时间表,并增强纯度和安全性。

培养黑人女孩:黑人女孩心理健康及其在学校种族歧视的现象学探索

培养黑人女孩:黑人培养黑人女孩的现象学探索:黑人女孩心理健康及其与种族女孩的心理健康的现象学探索及其在种族中的生活经历

保护个人免受怀孕歧视

CRC 通过评估、调查和裁决歧视投诉以及进行合规审查来管理和执行平等机会法,从而促进平等机会。CRC 执行多项保护个人免受歧视的法律依据,包括《劳动力创新和机会法案》(WIOA)第 188 条,29 USC § 3248;劳工部实施 WIOA 第 188 条的规定(29 CFR 第 38 部分);1972 年《教育修正案》第 IX 条,20 USC §§ 1681 et seq.;以及劳工部实施第 IX 条的规定(29 CFR 第 36 部分)。本情况说明书介绍了这些保护措施如何涵盖怀孕和/或有生育能力的个人,以及受怀孕、分娩或相关医疗条件影响的个人。它还简要概述了一些额外的怀孕保护措施,这些措施未由 CRC 执行,但可能适用于涵盖的实体,特别是作为雇主的实体。根据 WIOA 第 188 条规定,免受歧视的保护: