机构名称:

¥ 1.0

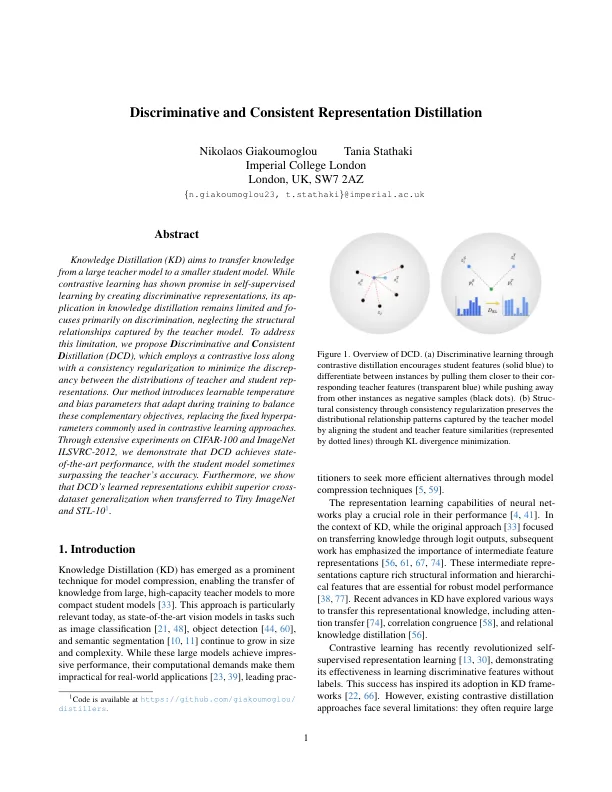

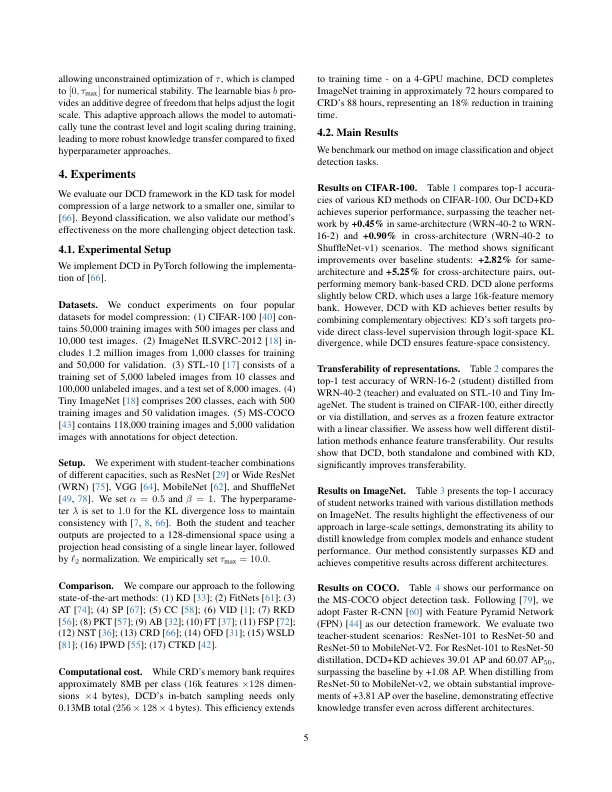

知识蒸馏(KD)旨在将知识从大型教师模型转移到较小的学生模型。虽然对比学习通过创建歧视性表示表现出了在自我监督学习中的希望,但其在知识蒸馏中的信息仍然有限,并且主要涉及歧视,忽略了教师模型捕获的结构关系。为了解决这一限制,我们提出了d Iscriminative and C On Consistent d Istillation(DCD),它采用了对比损失以及一致性正规化,以最大程度地减少教师和学生代表分布之间的差异。我们的方法引入了在训练过程中适应这些互补目标的可学习温度和偏置参数,以取代对比度学习方法中常用的固定超平衡器。通过CIFAR-100和Imagenet ILSVRC-2012的广泛实验,我们证明DCD实现了状态的表现,学生模型有时会超过教师的准确性。此外,我们表明DCD的所学表示形式将转移到小型成像网和STL-10 1时表现出较高的跨数据集泛化。

歧视性和一致表示蒸馏