XiaoMi-AI文件搜索系统

World File Search SystemNCEWP中的奖励论文集 - 2024

这是我的联系,旨在在我的论文中探索 - 现实与想象力之间的联系,理性与情感之间的联系,科学与艺术之间的联系。令人着迷的是,我们一些最伟大的物理学家如何将音乐作为对他们的思想和反之亦然的最持久影响之一。音乐的创作和接受是一种深刻的科学行为。从创建乐器到演奏以表演,科学定律通常被认为是直观和创造性的。实际上,正如我所看到的,物理定律可以通过这种表演艺术的直观和创造性的方法深入理解和欣赏,尤其是在使年轻一代更容易获得。如果我们成功地建立了为学生建立这种联系,那么学习音乐和物理学的同时也可以同时获得高度愉快和有益。

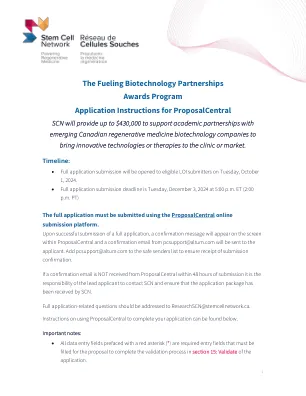

Anthem 2025 奖励计划

如果您在 2025 年加入 USG Anthem 医疗保健计划,您就有机会获得奖励。您的健康选择值得认可。在 Sydney SM Health 应用程序上寻求支持,这是一个访问您的福利信息和健康奖励的一体化中心。通过 USG 健康奖励计划,您和您已加入的合格配偶可以通过参与跟踪您的步数或完成健康检查等活动,每人最多可获得 100 美元。赚取期从 2025 年 1 月 1 日开始,到 2025 年 9 月 30 日结束。

对奖励预测错误和1加强学习的雌激素控制2

图1:大鼠的试验开始时间是由状态和发情阶段的值调节的。a。行为范式的示意图。b。任务的块结构带有示例会话(顶部)和每个块中的奖励分布(底部)。c。一个示例大鼠的跨块的平均降解试验启动时间。在低和高块中的起始时间显着不同,p << 1×10-20,双面Wilcoxon秩和测试,误差线是置信区间(CIS)。d。跨population的启动时间对块(低 - 高块)的敏感性与零,一侧Wilcoxon签名的等级测试p << 1×10-20,n = 303。e。示意图描述强化学习模型。启动时间与试验(t)中的状态价值(V t)成反比,当该试验提供奖励(R T)时,该启动时间通过奖励预测错误(δ)而更新。学习率(α)确定在状态值估计中权衡先前的奖励(r t-n)的程度。f。在所有大鼠的混合块期间,在混合块中,脱机试验启动时间的中值回归系数是奖励的函数。

AGL峰值能量奖励

在AGL中,我们认为能量使生活变得更好,并热衷于为澳大利亚人的生活,移动和工作提供动力。自豪地澳大利亚人已有185多年的历史,AGL提供约450万台能源,电信和Netflix客户服务。AGL致力于为我们的客户提供简单,公平和易于访问的基本服务,因为他们脱碳并使他们的生活,工作和移动方式振奋。AGL在国家电力市场上运营澳大利亚最大的私人发电投资组合,包括煤炭和燃气发电,可再生能源,例如风能,水力和太阳能,电池,电池以及其他限制技术以及存储资产。我们是我们的历史,是澳大利亚领先的可再生能源私人投资者之一,现在将过渡业务带到较低的排放,负担得起和智能的能源的未来,这符合我们气候过渡行动计划的目标。我们将继续创新能源和其他基本服务,以增强澳大利亚人的生活方式,并帮助将我们周围的世界保存在后代。

生成验证者:作为下一句话预测的奖励建模

图3:生成验证者的例证,即GenRM和GenRM-Cot。给出了一个问题和候选解决方案,genRM直接对llm进行了填补,以回答“答案正确(是/否)吗?”的问题。通过sft对对应于“是”或“否”的下一步响应。在推断期间,通过提取“是”令牌(4)的概率获得验证者分数。相比,GenRM-COT FINETUNES llm在产生最终的是/否代币之前产生验证链(COT)的基本原理。在测试时间时,我们采样了多个COT理由,并使用多数投票来计算“是”的平均概率,从而使GenRM-COT能够利用其他推理计算以更好地验证。

深度基于模型的强化学习,用于对机器人系统的预测控制,并具有稀疏奖励

抽象的稀疏奖励和样本效率是增强学习领域的开放研究领域。在考虑对机器人技术和其他网络物理系统的增强学习应用时,这些问题尤其重要。之所以如此,是因为在这些领域中,许多任务都是基于目标的,并且自然而然地表达了二进制成功和失败,动作空间较大且连续,并且与环境的实际相互作用受到限制。在这项工作中,我们提出了深层的价值和预测模型控制(DVPMC),这是一种基于模型的预测增强学习算法,用于连续控制,该算法使用系统识别,值函数近似和基于采样的优化对选择动作。该算法是根据密集的奖励和稀疏奖励任务进行评估的。我们表明,它可以使预测控制方法的性能与密集的奖励问题相匹配,并且在样本效率和性能的指标上,在稀疏奖励任务上优于模型和基于模型的学习算法。我们验证了使用DVPMC训练在仿真的机器人上培训的代理商的性能。可以在此处找到实验的视频:https://youtu.be/ 0q274kcfn4c。

使用自适应奖励增强方法的深度强化学习来改进 GNSS 定位校正

由于多径干扰和非视距接收的影响,城市环境中自动驾驶的高精度全球导航卫星系统 (GNSS) 定位仍是一个未解决的问题。最近,基于数据驱动的深度强化学习 (DRL) 的方法已被用于学习定位校正策略,这些方法适用于非平稳城市环境,而无需对模型参数进行严格的假设。然而,DRL 的性能严重依赖于训练数据的数量,而由于信号衰减和随机噪声大等问题,在城市环境中收集的高质量可用 GNSS 数据不足,导致 DRL 性能不佳和训练效率低下。在本文中,我们提出了一种基于 DRL 的定位校正方法,该方法结合自适应奖励增强方法 (ARAM),以提高非平稳城市环境中的 GNSS 定位精度。为了解决目标域环境中训练数据不足的问题,我们利用在源域环境中收集的足够数据来弥补训练数据不足,其中源域环境可以位于与目标环境不同的位置。然后我们

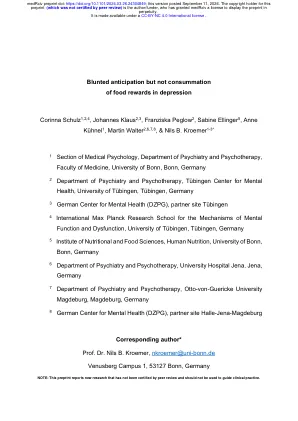

抑郁症中食物奖励的期待钝了

SSRI 13(13)0(0)13 25)1酰基和DES-acyl Ghrelin的值是指97名参与者的数据。缺少5个HCP和1个MDD的数据。2 Pearson的卡方测试;韦尔奇两个样本t检验。 数据是平均值±SD,如果未另有说明。 Abbreviations : HCP = healthy control participants, MDD = major depressive disorder, HOMA-IR = homeostasis model assessment of insulin resistance, TyG = Triglyceride-glucose Index, BDI = Beck's Depression Inventory, SHAPS = Snaith-Hamilton Pleasure Scale, SSRI = Selective serotonin reuptake inhibitors.2 Pearson的卡方测试;韦尔奇两个样本t检验。数据是平均值±SD,如果未另有说明。Abbreviations : HCP = healthy control participants, MDD = major depressive disorder, HOMA-IR = homeostasis model assessment of insulin resistance, TyG = Triglyceride-glucose Index, BDI = Beck's Depression Inventory, SHAPS = Snaith-Hamilton Pleasure Scale, SSRI = Selective serotonin reuptake inhibitors.

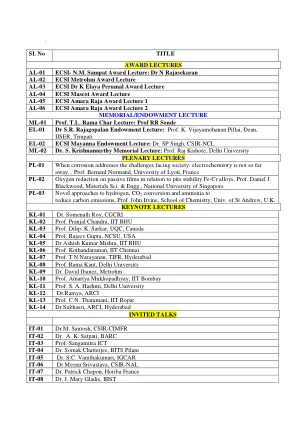

奖励讲座AL-01 ECSI-N.M. SAMPAT奖演讲:n Rajasekaran al-02 ECSI Metrohm Drection Decture Decture al-03 ECSI ecsi ecsi k elaya perumal奖

IT-09 Sachindranath Das博士,Jadhavpur Univ。 div>IT-100 Kuldeep Singh Kakran博士,Csir-Cecri IT-11 Vaishali Umrania博士,Sac,ISRO IT-12 Ravi Kumar Arjun博士Surajmal Brij University IT 16 Utkarsh Jain博士,Sohst IT-17 Sanket Goel博士,Bits Pilani IT-18博士Chaitanya Lekshmi博士,Plaksha University it-19 IT-19 Rajini P. Antony IT 23 Koyel Baneerjee Ghosh教授,IIT,海得拉巴IT-24 Alex Joseph教授,Mahatma Gandhi University Kottayam IT-25 Surender Kumar博士,CSIR-MPRI IT-26 IT-26 IT-26 BAMBESH DIXIT博士Singh,Snioe