XiaoMi-AI文件搜索系统

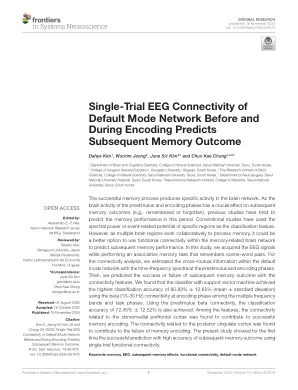

World File Search System编码前和编码期间默认模式网络的单次试验脑电图连接可预测后续记忆结果

成功的记忆过程会在大脑网络中产生特定的活动。由于刺激前和编码阶段的大脑活动对后续的记忆结果(如记住或遗忘)有着至关重要的影响,先前的研究试图预测这一时期的记忆表现。传统研究使用特定区域的频谱功率或事件相关电位作为分类特征。然而,由于多个大脑区域协同处理记忆,使用与记忆相关的大脑网络内的功能连接来预测后续的记忆表现可能是更好的选择。在本研究中,我们在执行记住场景-单词对的联想记忆任务时获取了脑电图信号。对于连接分析,我们使用刺激前和编码阶段的时间频谱来估计默认模式网络内的交叉信息。然后,我们利用连接特征预测后续记忆结果的成功或失败。我们发现,在多个频带和任务阶段中,使用编码阶段的 beta(13–30 Hz)连接,支持向量机分类器实现了最高的分类准确率 80.83% ± 12.65%(平均值±标准差)。使用刺激前 beta 连接,分类准确率也达到了 72.45% ± 12.52%。在这些特征中,与背内侧前额叶皮质相关的连接被发现有助于记忆编码成功。与后扣带皮层相关的连接被发现导致记忆编码失败。本研究首次显示使用单次试验功能连接可以成功且高精度地预测后续记忆结果。

真实量子处理单元上的量子模式识别

摘要 量子计算最有前途的应用之一是处理图像等图形数据。在这里,我们研究了基于交换测试实现量子模式识别协议的可能性,并使用 IBMQ 噪声中型量子 (NISQ) 设备来验证这个想法。我们发现,使用双量子比特协议,交换测试可以有效地以良好的保真度检测两个模式之间的相似性,尽管对于三个或更多量子比特,真实设备中的噪声会变得有害。为了减轻这种噪声影响,我们采用破坏性交换测试,这显示出三量子比特状态的性能有所提高。由于云对较大 IBMQ 处理器的访问有限,我们采用分段方法将破坏性交换测试应用于高维图像。在这种情况下,我们定义了一个平均重叠度量,当在真实 IBMQ 处理器上运行时,它可以忠实地区分两个非常不同或非常相似的模式。作为测试图像,我们使用具有简单模式的二进制图像、灰度 MNIST 数字和时尚 MNIST 图像,以及从磁共振成像 (MRI) 获得的人体血管的二进制图像。我们还介绍了一种利用金刚石中的氮空位 (NV) 中心进行破坏性交换测试的实验装置。我们的实验数据显示单量子比特状态具有高保真度。最后,我们提出了一种受量子联想记忆启发的协议,其工作方式类似于监督学习,使用破坏性交换测试进行量子模式识别。

神经形态自旋电子学

神经形态计算使用受大脑启发的基本原理来设计电路,以卓越的能效执行人工智能任务。传统方法受到传统电子设备实现的人工神经元和突触的能量区域的限制。近年来,多个研究小组已经证明,利用电子的磁性和电学特性的自旋电子纳米器件可以提高能源效率并减少这些电路的面积。在已使用的各种自旋电子器件中,磁隧道结因其与标准集成电路的既定兼容性和多功能性而发挥着重要作用。磁隧道结可以用作突触,存储连接权重,用作本地非易失性数字存储器或连续变化的电阻。作为纳米振荡器,它们可以充当神经元,模拟生物神经元组的振荡行为。作为超顺磁体,它们可以通过模拟生物神经元的随机尖峰来实现这一点。磁结构(如畴壁或 skyrmion)可以通过其非线性动力学配置为用作神经元。神经形态计算与自旋电子器件的几种实现方式展示了它们在这一领域的前景。用作可变电阻突触时,磁隧道结可在联想记忆中执行模式识别。作为振荡器,它们可在储层计算中执行口语数字识别,当耦合在一起时,它们可对信号进行分类。作为超顺磁体,它们可执行群体编码和概率计算。模拟表明,纳米磁体阵列和 skyrmion 薄膜可作为神经形态计算机的组件运行。虽然这些例子展示了自旋电子学在这一领域的独特前景,但扩大规模仍面临一些挑战,包括

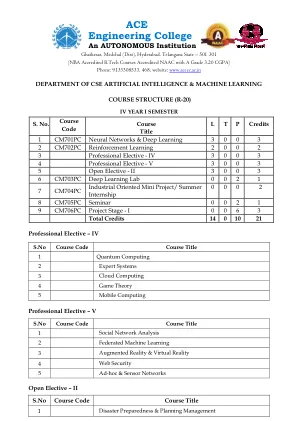

人工智能与机器学习 IV 年级课程大纲

神经网络与深度学习 B.Tech. IV 第一年 学期 LTPC 3 0 0 3 课程目标: 介绍人工神经网络的基础知识 获取有关深度学习概念的知识 学习各种类型的人工神经网络 获取应用优化策略的知识 课程成果: 能够理解神经网络的概念 能够选择学习网络来建模现实世界系统 能够使用有效的深度模型算法 能够将优化策略应用于大规模应用 UNIT-I 人工神经网络简介、ANN 的基本模型、重要术语、监督学习网络、感知器网络、自适应线性神经元、反向传播网络。联想记忆网络。模式关联的训练算法、BAM 和 Hopfield 网络。 UNIT-II 无监督学习网络-简介,固定权重竞争网络,Maxnet,Hamming 网络,Kohonen 自组织特征映射,学习矢量量化,反向传播网络,自适应共振理论网络。特殊网络-各种网络的介绍。 UNIT - III 深度学习简介、深度学习的历史趋势、深度前馈网络、基于梯度的学习、隐藏单元、架构设计、反向传播和其他微分算法 UNIT - IV 深度学习的正则化:参数范数惩罚、范数惩罚作为约束优化、正则化和欠约束问题、数据集增强、噪声鲁棒性、半监督学习、多任务学习、早期停止、参数类型化和参数共享、稀疏表示、Bagging 和其他集成方法、Dropout、对抗性训练、切线距离、切线 Prop 和流形、切线分类器 UNIT - V 训练深度模型的优化:神经网络优化中的挑战、基本算法、参数初始化策略、具有自适应学习率的算法、近似二阶方法、优化策略和元算法应用:大规模深度学习、计算机视觉、语音识别、自然语言处理教科书:1. 深度学习:麻省理工学院出版社出版的书籍,作者:Ian Goodfellow、Yoshua Bengio 和 Aaron Courville 2. 神经网络和学习机器,Simon Haykin,第 3 版,Pearson Prentice Hall。

重新思考愿景和行动 Ken Nakayama1、Jeff Moher2 ...

1. 简介 1981 年,罗杰·斯佩里与大卫·休伯尔和托尔斯滕·维塞尔共同获得了诺贝尔生理学和医学奖。斯佩里对裂脑患者的研究表明,高阶认知功能甚至意识的各个方面都是基于大脑的,可以用科学方法解决。然而,斯佩里 (1952) 在获得诺贝尔奖的 30 年前就持有截然不同且截然相反的观点。在一篇题为《神经病学和心脑问题》的文章中,他写了一篇措辞强硬的文章,否认当时人们对认知和感觉处理的兴趣。他坚持用另一种框架来理解心智和大脑,其中感觉处理、主观体验和联想记忆应该服从于心智和大脑最明显、最重要的功能——运动协调。乌尔里克·奈瑟是公认的认知革命领袖,他的里程碑式著作《认知心理学》标志着行为主义的终结和一个新领域的开始 (Neisser,1967)。然而,他自己在这个领域的角色出人意料地短暂,他很快就对他所认为的毫无意义的事业感到失望。不到 10 年后,在他的著作《认知与现实》(Neisser,1977)中,他指出,独立于行动研究认知几乎毫无意义,认知和行动总是结合在一起发生,有机体处于感知和行动的无休止循环中,并且不能单独研究它们。尽管早期的 Sperry 和后期的 Neisser 表达了如此强烈的观点,但心理学学科大多满足于保留其传统的子学科。有一些重要的重大例外,但这些领域已经确立,每个领域都有重要的会议、期刊和学会。具体主题多年来不断变化,但学术和研究领域仍在继续,许多领域取得了明显的进展。仔细阅读心理学入门教科书,没有关于行动或运动行为的章节。鉴于行动的重要性,心理学学科本身却出奇地疏忽大意(Rosenbaum,2005)。如果我们看教科书,或者去参加会议,我们可以感觉到整个大脑如何组织起来以产生行动的隐含图景。很少有正式的概述,但它已被默认。下面的图 1 显示了这个最简单的概念。对于许多研究过视觉心理物理学的人来说,尤其是描述视觉的早期阶段的人来说,这是一个毫无疑问的成功。一个典型的例子是测量绝对阈值,即在黑暗中可以感知到的最小光量。几乎是魔术般的,似乎

通用人工智能程序合成语言Pro5Lang的情景记忆机制

我们设计了一种陈述性记忆机制,它尽可能与神经科学和认知科学的发现保持一致,同时不违反证明合理性的数学逻辑要求。其主要特点如下。 寄存器和内容可寻址存储器中存储的值仅限于已证明的命题。由于信息处理的最小单位(一个已被证明的命题)有自足的意义,记忆管理(比如忘记不必要的知识)就变得更容易。另一个优点是,即使在合成过程中执行不完整的程序,数据结构也不太可能崩溃。由于程序执行的顺序也将变得更加灵活,因此在时间允许的情况下规划未来的行动将变得更加容易。 每次进行推理时,都会自动将已证明的命题添加到已证明命题集合中,即将信息写入联想记忆机制。目的是减轻程序负担,提高程序综合的性能。 我们计划提供两种类型的陈述性知识回忆:自动回忆和主动回忆。 (目前仅实现了主动回忆。)事件回忆并不涉及重现某一特定时刻大脑的整个内部状态,而是仅重现一个已证实的命题。这使得信息处理能够实现,例如从一个命题推断另一个命题。 回忆陈述性知识的机制也被设计成不破坏证明的合理性(第 3.7 节)。 陈述性知识分为证实命题(情景记忆)和语义记忆。 Pro5Lang 中的语义记忆是多个已证明命题的压缩和抽象版本,旨在使用 [5]2 中描述的方法通过归纳推理来获取。 (然而,在当前的实现中,语义记忆也是从一开始就手动提供的。)由于存在过度概括和获取不正确的语义记忆的可能性,因此有必要提供单独的机制来选择和忘记不正确的语义记忆。这将在第 5 节中讨论。 由于记忆空间有限,即使正确的陈述性知识也会被适当地遗忘。即使不时随机选择和删除已证明命题集合中的元素,图 2 和 Pro5Lang 中的算法也不会失去健全性。然而,证明可能需要更长的时间并且可能变得越来越难以完成。为了避免降低证明的效率,需要使用一些启发式方法来选择需要遗忘的知识。 (目前实施中尚未采取此类措施。)