机构名称:

¥ 3.0

2019 年 9 月,Google Scholar 上查找到 Yoshua Bengio 撰写的科学出版物被引用近 206,000 次,H 指数为 146,仅 2018 年就被引用了 60,000 多次。正如图灵奖特别认可的那样,他的主要贡献共同创造了深度学习领域,涉及循环网络、使深度学习成功的方法、深度学习的理论理解、基于注意力的新架构的开发以及使神经网络能够处理集合而不仅仅是向量和序列,以及开发深度生成模型(如生成对抗网络)。最近,YB 将注意力转向了表示学习的代理视角(以及深度强化学习),并参加了关于人工智能社会责任发展的国内和全球讨论(和文件),并为人工智能在社会公益应用方面的研究做出了贡献,例如在医疗保健、环境和教育领域。主要贡献如下。 • 1989-1998 卷积和循环网络与概率对齐 (HMM) 相结合来对序列进行建模,这是我的博士论文 (1991)、NIPS'1988、NIPS'1989、Eurospeech'1991、PAMI'1991、IEEE Trans. Neural Nets 1992 的主要贡献。这些架构首先应用于我博士论文中的语音识别(并在 2010 年后重新发现),然后与 Yann LeCun 等人一起应用于手写识别和文档分析(被引用最多的论文是“基于梯度的学习应用于文档识别”,1998 年,引用次数超过 19,000 次)。 • 1991-1995 与 Samy Bengio 一起学习学习论文,从 1991 年的 IJCNN 开始,

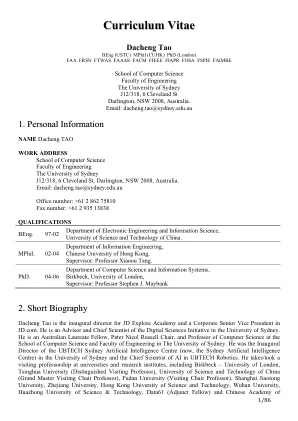

简历 - Joshua Bengio -

主要关键词