机构名称:

¥ 2.0

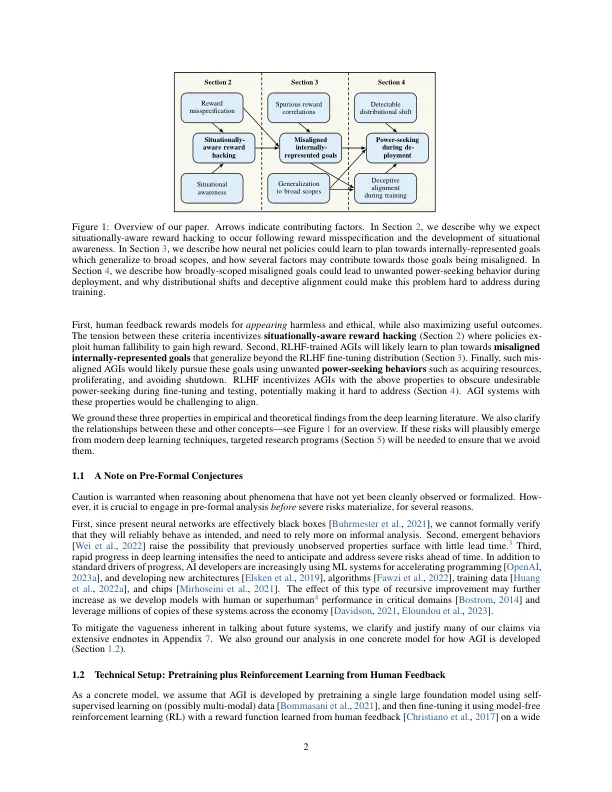

在未来的几年或几十年里,通用人工智能 (AGI) 可能会在许多关键任务上超越人类的能力。我们认为,如果不付出巨大的努力去阻止它,AGI 可能会学会追求与人类利益相冲突 (即不一致) 的目标。如果像今天最强大的模型那样进行训练,AGI 可以学会采取欺骗行为以获得更高的奖励,学习不一致的内部表示目标 (这些目标可以超越其微调分布),并使用寻求权力的策略来追求这些目标。我们回顾了这些特性的新证据。具有这些特性的 AGI 很难对齐,即使实际上并非如此,也可能看起来是对齐的。最后,我们简要概述了部署不一致的 AGI 可能会如何不可逆转地破坏人类对世界的控制,并回顾了旨在防止这种结果的研究方向。

从深度学习角度看对齐问题

主要关键词