机构名称:

¥ 1.0

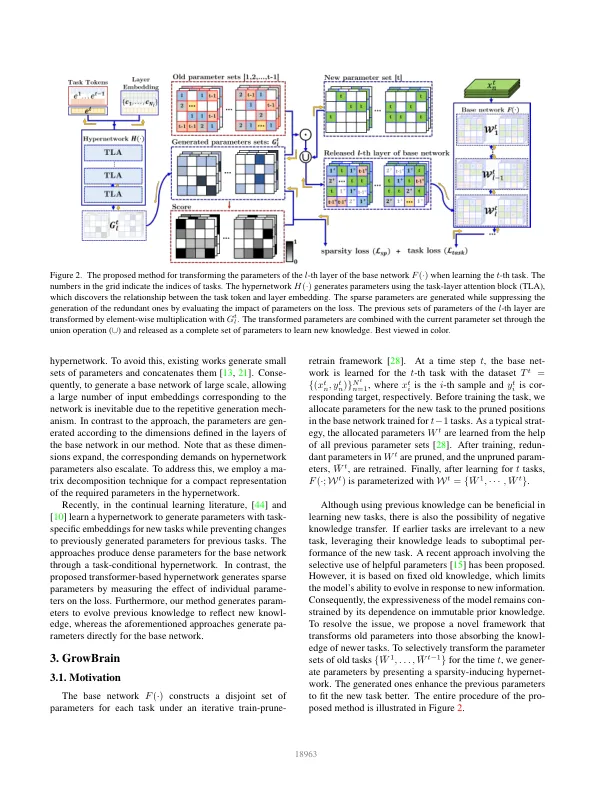

深度神经网络在持续学习中会遭受灾难性遗忘,在优化新任务时,它们往往会丢失有关先前学习过的任务的信息。最近的策略是隔离先前任务的重要参数,以便在学习新任务时保留旧知识。然而,使用固定的旧知识可能会成为获取新表示的障碍。为了克服这个限制,我们提出了一个框架,通过吸收新任务的知识来演化先前分配的参数。该方法在两个不同的网络下执行。基础网络学习顺序任务的知识,而稀疏诱导超网络为每个时间步骤生成参数以演化旧知识。生成的参数将基础网络的旧参数转换为反映新知识。我们设计超网络以根据任务特定信息和基础网络的结构信息生成稀疏参数。我们在图像分类和视频动作识别任务的类增量和任务增量学习场景中评估了所提出的方法。实验结果表明,通过发展旧知识,所提出的方法在这些场景中始终优于各种各样的持续学习方法。

通过稀疏诱导生成来培养大脑以实现持续学习

主要关键词