机构名称:

¥ 1.0

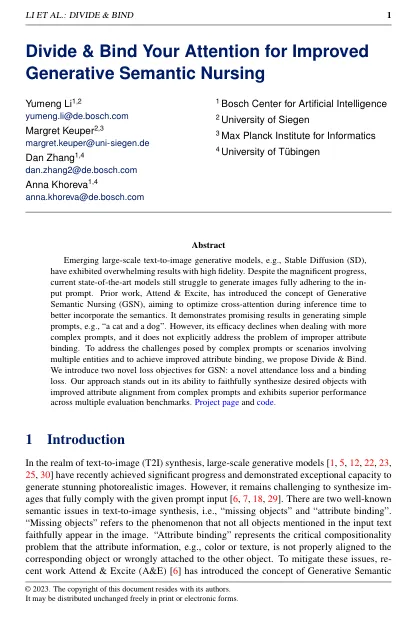

新兴的大规模文本对图像生成模型,例如稳定扩散(SD),表现出了高忠诚度的压倒性结果。尽管取得了巨大进展,但当前的最新模型仍在难以生成完全遵守信息提示的图像。先前的工作,参加和激励,引入了生成语义护理(GSN)的概念,旨在优化推理时间期间的跨注意,以更好地纳入语义。它在产生简单的提示(例如“猫与狗”)时展示了有希望的结果。但是,在处理更复杂的提示时,其功效会下降,并且没有明确解决属性绑定不当的问题。要解决涉及多个实体的复杂提示或场景所带来的挑战并获得改进的属性绑定,我们提出了划分和绑定。我们介绍了GSN的两个新颖的损失目标:一种新颖的出席率损失和具有约束力的损失。我们的方法在忠实地合成所需物体的能力方面脱颖而出,并从复杂提示中提高了属性对齐,并在多个评估基准中展示出卓越的性能。项目页面和代码。

Error 500 (Server Error)!!1500.That’s an error.There was an error. Please try again later.That’s all we know.