机构名称:

¥ 7.0

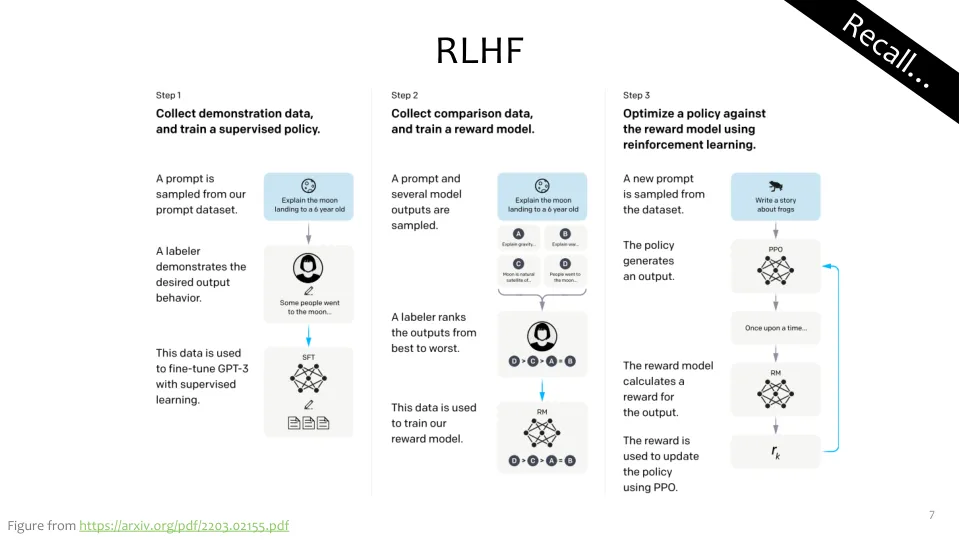

此处使用的目标函数是根据(相当流行的)PPO算法建模的。该算法反过来是一种策略梯度方法,并且是由信任区域策略优化(TRPO)的目标函数所激发的。,但是目标函数背后的(超高级别)直觉如下:1。对奖励的期望表明,在RL训练的模型πRL的样品上,我们希望该样品πrl的概率高时,当奖励rθ高,否则否则为低。2。beta术语的期望表明我们不希望RL训练的模型概率πrl到

直接偏好优化(DPO) +潜在扩散模型